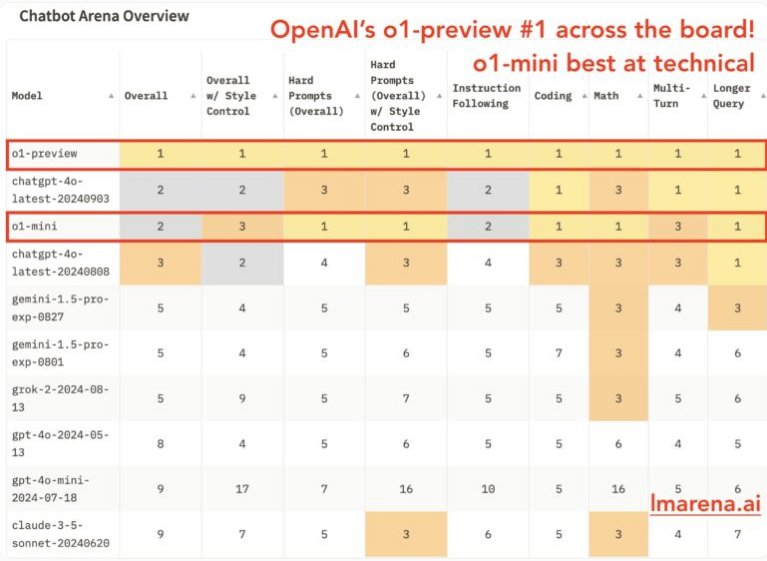

El editor de Downcodes informa: El sistema de chatbot recientemente lanzado de OpenAI encabezó la lista en evaluaciones recientes. Funciona bien en términos de rendimiento general, seguridad y capacidades técnicas, especialmente en tareas STEM. Sin embargo, vale la pena señalar que el número de calificaciones que participaron en esta evaluación fue relativamente bajo, lo que puede tener un cierto impacto en los resultados finales y debe interpretarse con cautela.

El nuevo sistema de OpenAI logró excelentes resultados en evaluaciones recientes, ocupando el primer lugar en la clasificación de chatbots. Sin embargo, debido al bajo número de calificaciones, esto puede sesgar los resultados de la evaluación.

Según la descripción general del comunicado, los nuevos sistemas tuvieron un buen desempeño en todas las categorías de evaluación, incluido el rendimiento general, la seguridad y las capacidades técnicas. Uno de los sistemas, dedicado a tareas STEM, ocupó brevemente el segundo lugar y tomó la delantera en el campo tecnológico, junto con la versión GPT-4o lanzada a principios de septiembre.

Chatbot Arena, una plataforma para comparar diferentes sistemas, evalúa nuevos sistemas utilizando más de 6000 calificaciones de la comunidad. Los resultados mostraron que estos nuevos sistemas funcionaron bien en tareas matemáticas, indicaciones complejas y programación.

Sin embargo, estos nuevos sistemas reciben calificaciones mucho más bajas que otros sistemas maduros como GPT-4o o Claude3.5 de Anthropic, cada uno con menos de 3000 revisiones. Un tamaño de muestra tan pequeño puede sesgar la evaluación y limitar la importancia de los resultados.

El nuevo sistema de OpenAI destaca en matemáticas y codificación, que fueron los principales objetivos de su diseño. Al "pensar" más antes de responder, estos sistemas pretenden establecer nuevos estándares para el razonamiento de la IA. Sin embargo, estos sistemas no superan a otros en todas las áreas. Muchas tareas no requieren un razonamiento lógico complejo y, a veces, una respuesta rápida de otros sistemas es suficiente.

El gráfico de Lmsys sobre la solidez del modelo matemático muestra claramente que estos nuevos sistemas obtuvieron una puntuación superior a 1360, muy por encima del rendimiento de otros sistemas.

A pesar del tamaño limitado de la muestra, el excelente rendimiento del nuevo sistema de OpenAI sigue siendo digno de atención. Sus avances en los campos de las matemáticas y la codificación proporcionan una nueva dirección para el desarrollo de la tecnología de razonamiento de IA. En el futuro, con la acumulación de más datos y la mejora continua de los modelos, se espera que el nuevo sistema de OpenAI demuestre sus poderosas capacidades en más campos. El editor de Downcodes seguirá atento a su desarrollo.