Recientemente, el editor de Downcodes se enteró de que para hacer frente al creciente desafío del contenido generado por IA y mejorar la capacidad de los usuarios para identificar la autenticidad del contenido, Google anunció que agregará una nueva función a los resultados de búsqueda. Esta función está diseñada para ayudar a los usuarios a comprender mejor dónde se crean y editan las imágenes, reduciendo así el impacto negativo de la información errónea y las imágenes ultrafalsas. El lanzamiento de esta función es un paso importante después de que Google se uniera a la Content Provenance and Authenticity Alliance (C2PA), entre cuyos miembros también se encuentran gigantes tecnológicos como Amazon, Adobe y Microsoft.

Recientemente, Google anunció que implementaría una nueva función en sus resultados de búsqueda diseñada para ayudar a los usuarios a comprender mejor cómo se crea y modifica el contenido. La medida se produce después de que Google se uniera a la Content Provenance and Authenticity Alliance (C2PA), que incluye marcas importantes como Amazon, Adobe y Microsoft, y se dedica a combatir la desinformación en línea.

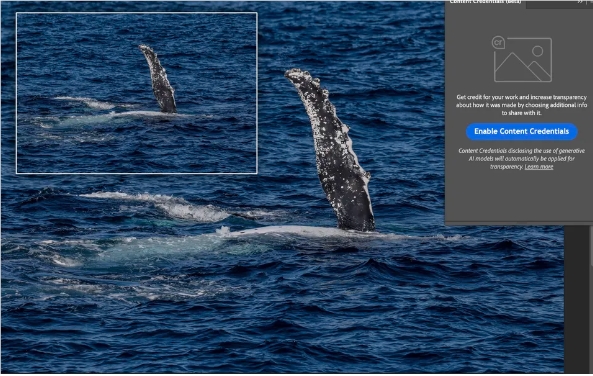

Google dijo que la nueva función, que se implementará gradualmente durante los próximos meses, aprovecha el estándar de credenciales de contenido actual (es decir, los metadatos de la imagen) para etiquetar imágenes generadas o editadas por IA en la búsqueda para aumentar la transparencia para los usuarios.

Los usuarios podrán ver si fue generada por IA haciendo clic en los tres puntos encima de la imagen y seleccionando "Acerca de esta imagen". Esta función también estará disponible para los usuarios a través de Google Lens y la función “Círculo para buscar” de Android. Sin embargo, vale la pena señalar que esta etiqueta no es muy llamativa y requiere que los usuarios tomen medidas adicionales para confirmar el origen de una imagen.

En los últimos años, con el desarrollo de la tecnología de inteligencia artificial, los problemas de la tecnología de video deep fake y las imágenes generadas por inteligencia artificial se han vuelto cada vez más graves. Por ejemplo, Trump publicó una vez una imagen ficticia de Taylor Swift apoyando su campaña, lo que provocó muchos malentendidos y controversias. Además, Taylor Swift también encontró imágenes maliciosas generadas por IA, lo que generó dudas sobre la autenticidad de las imágenes de IA.

Si bien el lanzamiento de esta función por parte de Google es un buen comienzo, persisten las preocupaciones sobre si esta etiqueta oculta es lo suficientemente efectiva. Es posible que muchos usuarios no sepan que existe la función Acerca de esta imagen y es posible que no puedan aprovechar al máximo esta nueva herramienta. Además, actualmente sólo unos pocos modelos de cámaras y algunos programas implementan la función de bono de contenido, lo que también limita la eficacia del sistema.

Según un estudio de la Universidad de Waterloo, sólo el 61% de las personas pueden distinguir entre una imagen generada por IA y una imagen real, lo que significa que si el sistema de etiquetado de Google no se puede utilizar de forma eficaz, será difícil ofrecer una verdadera transparencia. a los usuarios.

Destacar:

Google lanzará una nueva función para etiquetar imágenes editadas y generadas por IA para aumentar la transparencia del usuario.

Los usuarios pueden comprobar si la imagen fue generada por IA a través de la función "Acerca de esta imagen", pero la etiqueta no es llamativa.

Las investigaciones muestran que sólo el 61% de las personas pueden distinguir las imágenes de IA de las imágenes reales, y Google necesita mejorar la visibilidad de las etiquetas.

Con todo, aunque la medida de Google es un paso importante en la lucha contra la desinformación, su eficacia aún está por verse. Aumentar la visibilidad de las etiquetas y popularizar la tecnología de vales de contenido serán direcciones clave para futuras mejoras. El editor de Downcodes seguirá prestando atención al desarrollo posterior de esta función y brindará información más relevante a los lectores.