La capacidad de razonamiento de los grandes modelos lingüísticos (LLM) es un punto de investigación en el campo de la inteligencia artificial. El equipo de investigación de IA de Apple publicó recientemente un artículo que revela las limitaciones de los LLM en razonamiento matemático. El editor de Downcodes interpretará el contenido principal del artículo y analizará su impacto en el desarrollo de la tecnología de IA.

En el mundo de la inteligencia artificial, las capacidades de razonamiento de los modelos de aprendizaje automático, especialmente los modelos de lenguaje grande (LLM), siempre han sido el foco de atención de los científicos.

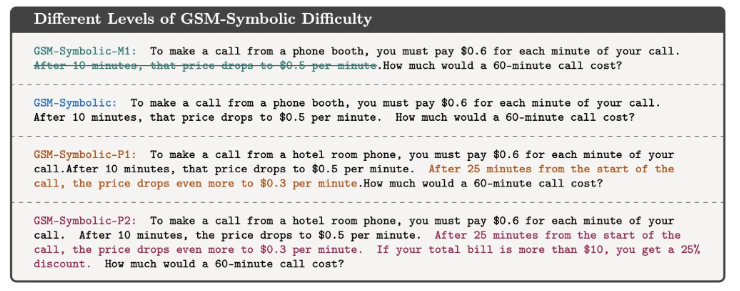

Recientemente, el equipo de investigación de IA de Apple publicó un artículo titulado "Comprensión de las limitaciones de los modelos de lenguaje grandes en el razonamiento matemático", que reveló las limitaciones de estos modelos al abordar problemas lógicos.

En el artículo, los investigadores lo demuestran mediante un sencillo problema matemático. Primero hicieron una pregunta sobre Oliver recogiendo kiwis:

Como se muestra a continuación:

Oliver recogió 44 kiwis el viernes. El sábado recogió otros 58 kiwis. El domingo recogió el doble de kiwis que el viernes. ¿Cuántos kiwis tiene Oliver en total?

Obviamente, la respuesta es 44+58+ (44*2) =190. Si bien los modelos de lenguaje grandes no son matemáticamente perfectos, pueden resolver problemas como este de manera bastante confiable.

Pero si agrega alguna información irrelevante para observar la respuesta del modelo, como por ejemplo:

Oliver recogió 44 kiwis el viernes. El sábado eligió otros 58. El domingo recogió el doble de kiwis que el viernes, pero cinco de ellos eran un poco más pequeños que la media. ¿Cuántos kiwis tiene Oliver?

Aunque esto no cambia la naturaleza matemática del problema, incluso los LLM más avanzados dan respuestas incorrectas ante esta pequeña perturbación. Por ejemplo, GPT-o1-mini restó incorrectamente 5 kiwis pequeños del número total de kiwis recolectados el domingo.

Este experimento muestra que, aunque los LLM pueden dar la respuesta correcta en algunos casos, realmente no comprenden la naturaleza del problema.

Los investigadores creen que los patrones de falla de estos modelos indican que no están realizando un verdadero razonamiento lógico, sino que están replicando los pasos de razonamiento que observaron en los datos de entrenamiento. Es como un LLM capaz de contar que "Te amo" suele ir seguido de "Yo también te amo", pero eso no significa que realmente comprenda el significado del amor.

Mehrdad Farajtabar, uno de los coautores del artículo, explicó con más detalle los hallazgos en las redes sociales. Señala que si bien es posible mejorar el rendimiento del modelo en algunos casos simples a través de una mejor ingeniería de sugerencias, para perturbaciones complejas el modelo puede necesitar más datos contextuales para manejar correctamente, y estas perturbaciones pueden no ser viables para que un niño pequeño las maneje en absoluto. No es un problema.

Este estudio nos recuerda que, aunque los LLM sobresalen en el procesamiento del lenguaje, sus habilidades en el razonamiento lógico aún son limitadas. Esta no es solo una pregunta académica. A medida que la tecnología de IA se vuelve cada vez más parte de nuestra vida diaria, las respuestas a estas preguntas se vuelven cada vez más importantes.

No podemos simplemente asumir que la IA puede comprender y realizar tareas complejas, sino que deberíamos tener una comprensión más profunda de cómo funcionan y sus limitaciones. Esta investigación nos proporciona una comprensión más profunda de las tecnologías de inteligencia artificial, al mismo tiempo que brinda información valiosa sobre cómo usamos y desarrollamos estas tecnologías.

Referencia: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

Con todo, la investigación del equipo de Apple destaca las limitaciones de los grandes modelos de lenguaje en el razonamiento lógico, recordándonos que debemos ser cautelosos con las capacidades de la IA y seguir prestando atención a su dirección de desarrollo para evitar una dependencia excesiva de sus capacidades. En el futuro, necesitamos estudiar más profundamente cómo mejorar las capacidades de razonamiento de los LLM para que puedan comprender verdaderamente la esencia del problema en lugar de limitarse a imitar patrones existentes.