El editor de Downcodes le llevará a comprender un fenómeno inquietante en el campo de la IA: el colapso de los modelos. Imagine que un modelo de IA es como un bloguero de comida que comienza a comer la comida que cocina. Cuanto más come, más adicto se vuelve y la comida se vuelve cada vez más desagradable. Con el tiempo, se vuelve "mala". es cuando el modelo colapsa. Ocurre cuando un modelo de IA depende demasiado de los datos que genera, lo que provoca una disminución en la calidad del modelo o incluso un fracaso total. Este artículo profundizará en las causas, los efectos y cómo evitar el colapso del modelo.

Recientemente ha sucedido algo extraño en el círculo de la IA, como un blogger de comida que de repente comenzó a comer la comida que cocinaba, y cuanto más comía, más adicto se volvía y la comida se volvía cada vez más desagradable. Da bastante miedo decir esto. El término profesional se llama colapso del modelo.

¿Qué es el colapso del modelo? En pocas palabras, si un modelo de IA utiliza una gran cantidad de datos autogenerados durante el proceso de entrenamiento, caerá en un círculo vicioso, lo que hará que la calidad de la generación del modelo empeore cada vez más y, finalmente, empeore. fallar.

Esto es como un ecosistema cerrado. El modelo de IA es el único ser vivo en este sistema y el alimento que produce son datos. Al principio, todavía podía encontrar algunos ingredientes naturales (datos reales), pero a medida que pasó el tiempo, empezó a depender cada vez más de los ingredientes "artificiales" que producía (datos sintéticos). El problema es que estos ingredientes “artificiales” son nutricionalmente deficientes y conllevan algunos de los defectos del modelo en sí. Si comes demasiado, el "cuerpo" del modelo de IA colapsará y las cosas generadas se volverán cada vez más escandalosas.

Este artículo estudia el fenómeno del colapso del modelo e intenta responder dos preguntas clave:

¿Es inevitable el colapso del modelo? ¿Se puede resolver el problema mezclando datos reales y sintéticos?

¿Cuanto más grande es el modelo, más fácil es estrellarse?

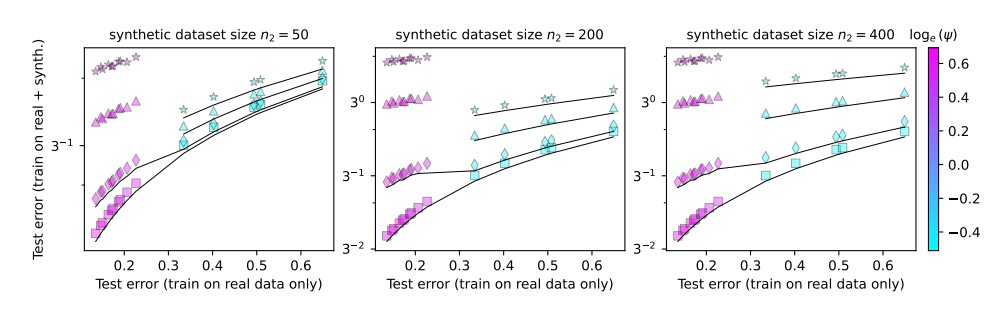

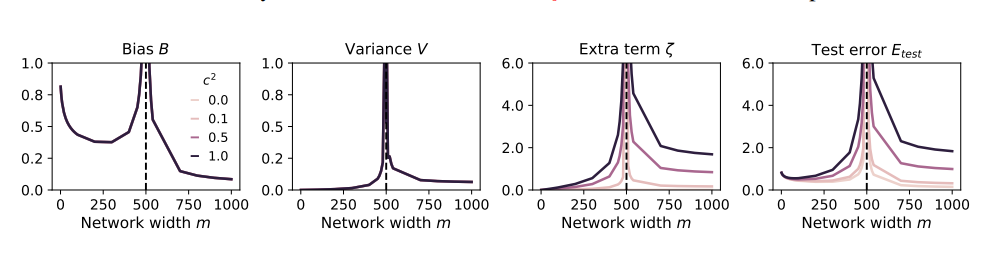

Para estudiar estas cuestiones, los autores del artículo diseñaron una serie de experimentos y utilizaron un modelo de proyección aleatoria para simular el proceso de entrenamiento de la red neuronal. Descubrieron que utilizar incluso una pequeña porción de los datos sintéticos (digamos, el 1%) podría provocar el colapso del modelo. Para empeorar las cosas, a medida que aumenta el tamaño del modelo, el fenómeno del colapso del modelo se vuelve más grave.

Esto es como un blogger de comida que comenzó a probar todo tipo de ingredientes extraños para llamar la atención, pero terminó con mal estómago. Para recuperar las pérdidas, solo pudo aumentar su ingesta de alimentos y comer más y más cosas raras. Como resultado, su estómago empeoró cada vez más y finalmente tuvo que dejar el mundo de la comida y la radiodifusión.

Entonces, ¿cómo deberíamos evitar el colapso del modelo?

Los autores del artículo hicieron algunas sugerencias:

Priorice el uso de datos reales: los datos reales son como alimentos naturales, ricos en nutrientes y son la clave para el crecimiento saludable de los modelos de IA.

Utilice los datos sintéticos con precaución: los datos sintéticos son como los alimentos artificiales. Aunque pueden complementar algunos nutrientes, no conviene confiar demasiado en ellos, de lo contrario serán contraproducentes.

Controla el tamaño del modelo: Cuanto más grande es el modelo, mayor es el apetito y más fácil es tener mal estómago. Cuando utilice datos sintéticos, controle el tamaño del modelo para evitar la sobrealimentación.

El colapso del modelo es un nuevo desafío encontrado en el proceso de desarrollo de la IA. Nos recuerda que mientras buscamos la escala y la eficiencia del modelo, también debemos prestar atención a la calidad de los datos y la salud del modelo. Sólo así los modelos de IA podrán seguir desarrollándose de forma saludable y crear mayor valor para la sociedad humana.

Documento: https://arxiv.org/pdf/2410.04840

Con todo, el colapso del modelo es un problema que merece atención en el desarrollo de la IA. Debemos tratar los datos sintéticos con precaución, prestar atención a la calidad de los datos reales y controlar la escala del modelo para evitar el fenómeno de la "IA". comer demasiado." Espero que este análisis pueda ayudar a todos a comprender mejor el colapso del modelo y contribuir al desarrollo saludable de la IA.