¡El editor de Downcodes te trae grandes novedades! Hay un nuevo miembro en el campo de la inteligencia artificial: ¡Zyphra lanzó oficialmente su modelo de lenguaje pequeño Zamba2-7B! Este modelo de 7 mil millones de parámetros ha logrado un gran avance en rendimiento, especialmente en términos de eficiencia y adaptabilidad, mostrando ventajas impresionantes. No solo es adecuado para entornos informáticos de alto rendimiento, sino que, lo que es más importante, Zamba2-7B también puede ejecutarse en GPU de consumo, lo que permite que más usuarios experimenten fácilmente el encanto de la tecnología avanzada de IA. Este artículo profundizará en las innovaciones de Zamba2-7B y su impacto en el campo del procesamiento del lenguaje natural.

Recientemente, Zyphra lanzó oficialmente Zamba2-7B, un modelo de lenguaje pequeño con un rendimiento sin precedentes, con un número de parámetros que alcanza los 7B.

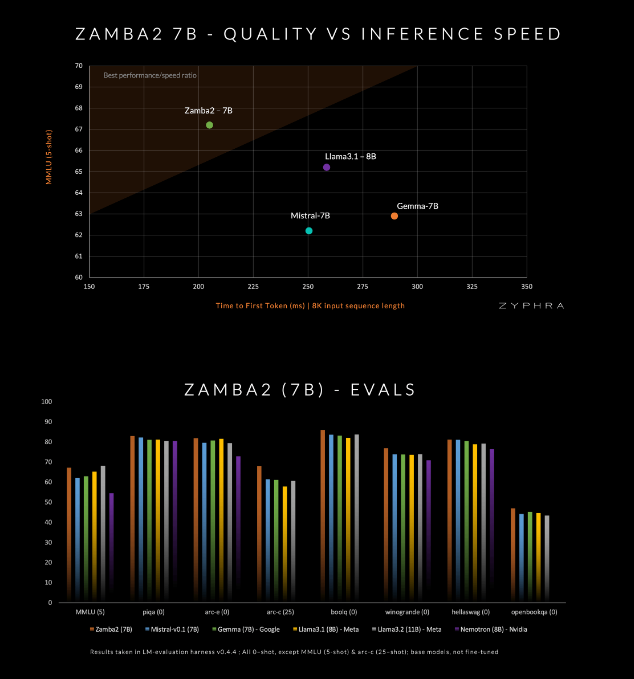

Este modelo pretende superar a los competidores actuales en calidad y velocidad, incluidos Mistral-7B, Gemma-7B de Google y Llama3-8B de Meta.

Zamba2-7B está diseñado para satisfacer las necesidades de entornos que requieren potentes capacidades de procesamiento de lenguaje pero que están limitados por las condiciones del hardware, como el procesamiento en el dispositivo o el uso de GPU de consumo. Al mejorar la eficiencia sin sacrificar la calidad, Zyphra espera permitir que una gama más amplia de usuarios, ya sean empresas o desarrolladores individuales, disfruten de la comodidad de la IA avanzada.

Zamba2-7B ha realizado muchas innovaciones en su arquitectura para mejorar la eficiencia y las capacidades de expresión del modelo. A diferencia del modelo Zamba1 de la generación anterior, Zamba2-7B utiliza dos bloques de atención compartidos. Este diseño puede manejar mejor las dependencias entre el flujo de información y las secuencias.

El bloque Mamba2 forma el núcleo de toda la arquitectura, lo que hace que la utilización de parámetros del modelo sea mayor que la de los modelos de convertidor tradicionales. Además, Zyphra también utiliza proyección de adaptación de rango bajo (LoRA) en bloques MLP compartidos, lo que mejora aún más la adaptabilidad de cada capa mientras mantiene la compacidad del modelo. Gracias a estas innovaciones, el tiempo de primera respuesta de Zamba2-7B se redujo en un 25% y la cantidad de tokens procesados por segundo aumentó en un 20%.

La eficiencia y adaptabilidad de Zamba2-7B han sido verificadas mediante pruebas rigurosas. El modelo está previamente entrenado en un conjunto de datos masivo que contiene tres billones de tokens, que son datos abiertos de alta calidad y rigurosamente seleccionados.

Además, Zyphra también introduce una etapa de preentrenamiento de "recocido" que reduce rápidamente la tasa de aprendizaje para procesar tokens de alta calidad de manera más eficiente. Esta estrategia permite que Zamba2-7B tenga un buen desempeño en los puntos de referencia, superando a los competidores en velocidad y calidad de inferencia, y es adecuada para tareas como la comprensión y generación del lenguaje natural sin requerir los recursos informáticos masivos que requieren los modelos tradicionales de alta calidad.

amba2-7B representa un avance importante en los modelos de lenguajes pequeños, manteniendo la alta calidad y el rendimiento y prestando especial atención a la accesibilidad. A través de un diseño arquitectónico innovador y una tecnología de capacitación eficiente, Zyphra ha creado con éxito un modelo que no solo es fácil de usar, sino que también puede satisfacer diversas necesidades de procesamiento del lenguaje natural. La versión de código abierto de Zamba2-7B invita a investigadores, desarrolladores y empresas a explorar su potencial y se espera que avance en el desarrollo del procesamiento avanzado del lenguaje natural dentro de la comunidad en general.

Entrada al proyecto: https://www.zyphra.com/post/zamba2-7b

https://github.com/Zyphra/transformers_zamba2

La versión de código abierto de Zamba2-7B ha aportado nueva vitalidad al campo del procesamiento del lenguaje natural y ha brindado más posibilidades a los desarrolladores. ¡Esperamos que Zamba2-7B se utilice más ampliamente en el futuro y promueva el progreso continuo de la tecnología de inteligencia artificial!