¡El editor de Downcodes se enteró de que se han logrado avances significativos en el campo de la generación de videos! Genmo ha abierto su último modelo de generación de video, Mochi1, que tiene 10 mil millones de parámetros y es el modelo de generación de video más grande lanzado públicamente actualmente. Mochi1 adopta la innovadora arquitectura Asynchronous Diffusion Transformer (AsymmDiT), que es simple y fácil de modificar, brinda gran comodidad a los desarrolladores de la comunidad de código abierto y puede generar videos de alta calidad de hasta 5,4 segundos de duración y con una velocidad de fotogramas de hasta 30. fotogramas/segundo.

¡Se ha producido un gran avance en el campo de la generación de video! Genmo ha abierto su último modelo de generación de video, Mochi1, estableciendo un nuevo punto de referencia en el campo de la generación de video. Mochi1 utiliza la innovadora arquitectura de Transformador de Difusión Asimétrica (AsymmDiT) y tiene hasta 10 mil millones de parámetros, lo que lo convierte en el modelo de generación de video más grande lanzado públicamente hasta la fecha.

Más importante aún, está entrenado completamente desde cero y tiene una arquitectura simple y modificable, lo que brinda una gran comodidad a los desarrolladores de la comunidad de código abierto.

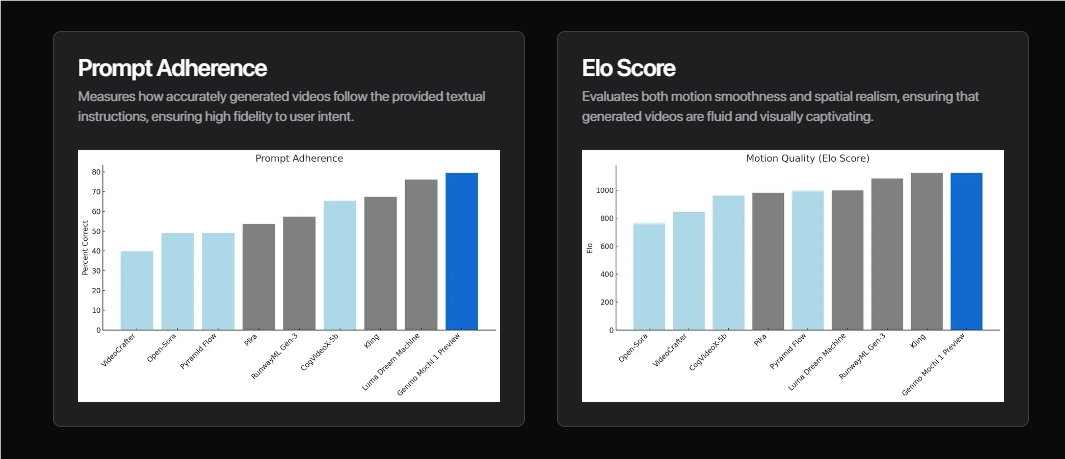

Lo más destacado de Mochi1 es su excelente calidad de movimiento y el cumplimiento preciso de las indicaciones de texto. Es capaz de generar vídeos fluidos de hasta 5,4 segundos de duración con una velocidad de fotogramas de hasta 30 fotogramas/segundo, con una coherencia temporal sorprendente y una dinámica de movimiento realista.

Mochi1 también puede simular diversos fenómenos físicos, como dinámica de fluidos, simulación de cabello, etc. Los personajes que genera tienen movimientos naturales y suaves, casi comparables a las actuaciones de la vida real.

Para facilitar el uso a los desarrolladores, Genmo también ha abierto su video VAE, que puede comprimir el video a 1/128 del tamaño original, reduciendo efectivamente la cantidad de cálculo y los requisitos de memoria del modelo.

La arquitectura AsymmDiT maneja de manera eficiente las indicaciones del usuario y las etiquetas de video comprimido a través de un mecanismo de autoatención multimodal, y aprende capas MLP separadas para cada modalidad, lo que mejora aún más la eficiencia y el rendimiento del modelo.

El lanzamiento de Mochi1 marca un paso importante en el campo de la generación de vídeo de código abierto. La compañía Genmo dijo que lanzarán la versión completa de Mochi1 antes de fin de año, incluido Mochi1HD que admite la generación de video de 720p, momento en el cual la fidelidad y fluidez del video mejorarán aún más.

Para permitir que más personas experimenten las poderosas funciones de Mochi1, Genmo también lanzó un área de juegos alojada de forma gratuita, que los usuarios pueden experimentar en genmo.ai/play. Los pesos y la arquitectura de Mochi1 también se han hecho públicos en la plataforma HuggingFace para que los desarrolladores los descarguen y utilicen.

Genmo está compuesto por miembros principales de proyectos como DDPM, DreamFusion y Emu Video, y su equipo asesor incluye a Ion Stoica, presidente ejecutivo y cofundador de Databricks y Anyscale, Pieter Abbeel, cofundador de Covariant y miembro inicial del equipo de OpenAI; y líderes de la industria de sistemas de modelos de lenguaje como Joey González, pionero y cofundador de Turi.

La misión de Genmo es desbloquear el cerebro derecho de la inteligencia artificial general, y Mochi1 es el primer paso en la construcción de un simulador mundial que puede imaginar cualquier cosa, posible o imposible.

Genmo completó recientemente una ronda de financiación Serie A liderada por NEA, por un total de 28,4 millones de dólares, que proporcionará suficiente apoyo financiero para su futura investigación y desarrollo.

Si bien Mochi1 ha logrado resultados impresionantes, todavía tiene algunas limitaciones. Por ejemplo, la versión inicial actualmente solo puede producir video de 480p, con una ligera distorsión y distorsión en algunos casos extremos de movimiento extremo. Además, Mochi1 está actualmente optimizado para un estilo fotorrealista y es necesario mejorar su rendimiento en contenido de animación.

Genmo dice que continuará mejorando Mochi1 y alienta a la comunidad a ajustar el modelo para que se adapte a diferentes preferencias estéticas. Al mismo tiempo, también han implementado sólidos protocolos de auditoría de seguridad en sus áreas de juego para garantizar que toda la generación de videos sea ética.

Descarga del modelo: https://huggingface.co/genmo/mochi-1-preview

Experiencia en línea: https://www.genmo.ai/play

Introducción oficial: https://www.genmo.ai/blog

El código abierto de Mochi1 aporta nuevas posibilidades al campo de la generación de vídeo, y vale la pena esperar por sus potentes funciones y su uso conveniente. Los continuos esfuerzos de Genmo y la participación activa de la comunidad promoverán aún más el avance de la tecnología de generación de video. Esperamos con ansias la llegada de Mochi1HD y la aparición de logros más innovadores.