El editor de Downcodes se enteró de que Hugging Face lanzó recientemente una nueva herramienta de inteligencia artificial llamada SmolLM, que es una serie de pequeños modelos de lenguaje con tamaños de parámetros que van desde 135 millones a 1,7 mil millones, con el objetivo de proporcionar soluciones eficientes y potentes para diversos dispositivos y aplicaciones de inteligencia artificial. . El modelo SmolLM también puede funcionar bien en dispositivos con recursos limitados, teniendo en cuenta la protección de la privacidad del usuario, y es muy adecuado para su uso en dispositivos como teléfonos móviles y tabletas.

Recientemente, Hugging Face lanzó una nueva herramienta de inteligencia artificial: SmolLM. Se trata de una serie de modelos de lenguaje pequeño de alto rendimiento con parámetros que van desde 135 M a 1,7 B, especialmente diseñados para una variedad de dispositivos y aplicaciones. ¡Es genial imaginar estos pequeños modelos funcionando de manera eficiente en teléfonos móviles y computadoras portátiles!

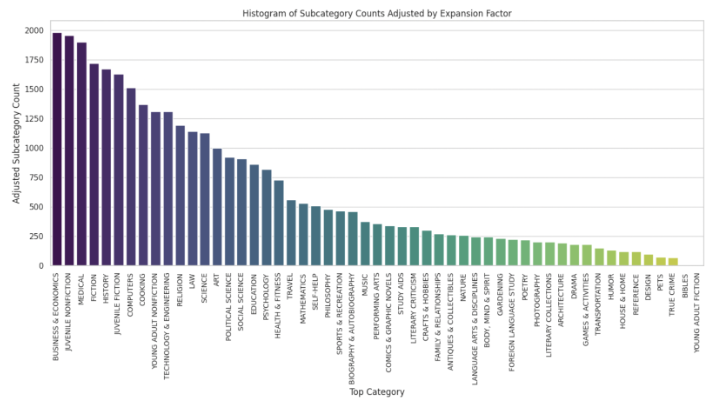

El modelo SmolLM se caracteriza por su compacidad y potencia. Aún pueden funcionar bien con menos recursos informáticos y ayudar a los usuarios a proteger la privacidad. Hugging Face utilizó un conjunto de datos llamado SmolLM-Corpus al entrenar estos modelos. Este conjunto de datos fue cuidadosamente seleccionado y contiene datos educativos y sintéticos ricos para garantizar que el modelo pueda aprender una variedad de conocimientos.

En concreto, SmolLM tiene tres versiones: parámetros 135M, 360M y 1.7B. Estos modelos no sólo pueden realizar una variedad de tareas, sino que también pueden funcionar de manera flexible según la configuración de hardware del usuario. Por ejemplo, el modelo SmolLM-135M ha superado a muchos productos similares y se ha convertido en líder entre los modelos con parámetros inferiores a 200M.

El modelo SmolLM se evalúa según varios puntos de referencia, poniendo a prueba el razonamiento de sentido común y el conocimiento mundial. Estos modelos demuestran un rendimiento impresionante, superando a otros modelos en sus respectivas categorías de tamaño. Por ejemplo, a pesar de haber sido entrenado con menos tokens, el modelo SmolLM-135M supera al MobileLM-125M, el mejor modelo actual con menos de 200 millones de parámetros. Asimismo, los modelos SmolLM-360M y SmolLM-1.7B superaron a todos los demás modelos con parámetros inferiores a 500M y 2B, respectivamente.

Además de su excelente rendimiento, SmolLM también se ha ajustado especialmente para mejorar la comprensión de instrucciones y la respuesta a preguntas. Hugging Face también ofrece una demostración de WebGPU para que todos puedan experimentar directamente las capacidades de estos modelos.

El lanzamiento de SmolLM demuestra que incluso los modelos pequeños pueden lograr un rendimiento sorprendente con datos de entrenamiento de alta calidad.

Entrada del producto: https://top.aibase.com/tool/smollm

Destacar:

1. **Rendimiento eficiente**: el modelo SmolLM puede funcionar bien con bajos recursos informáticos y proteger la privacidad del usuario.

2. **Enriquezca datos**: utilice un conjunto de datos SmolLM-Corpus de alta calidad para garantizar que el modelo aprenda conocimientos diversos.

3. ? **Múltiples aplicaciones**: Adecuado para teléfonos móviles, portátiles y otros dispositivos, funcionamiento flexible para satisfacer diferentes necesidades.

SmolLM aporta nuevas posibilidades al campo de la IA con su rendimiento eficiente, sus ricas reservas de conocimiento y su amplia aplicación. El editor de Downcodes cree que SmolLM desempeñará un papel importante en futuras aplicaciones de IA. ¡Date prisa y experimentalo!