El editor de Downcodes se enteró de que académicos chinos del Instituto de Tecnología de Georgia y NVIDIA propusieron un marco de ajuste innovador llamado RankRAG, que simplifica significativamente el complejo proceso de generación de mejoras de recuperación (RAG). RankRAG afina un único modelo de lenguaje grande (LLM) para realizar simultáneamente las tareas de recuperación, clasificación y generación, mejorando así en gran medida el rendimiento y la eficiencia y logrando resultados experimentales que son superiores a los modelos de código abierto existentes. Esta innovadora tecnología ofrece nuevas posibilidades para la aplicación de la IA en diversos campos.

Recientemente, dos académicos chinos del Instituto de Tecnología de Georgia y NVIDIA propusieron un nuevo marco de ajuste llamado RankRAG. Este marco simplifica enormemente la compleja canalización RAG original y utiliza el método de ajuste para permitir que el mismo LLM complete la recuperación, clasificación y generación. tareas, lo que también resultó en una mejora sustancial en el desempeño.

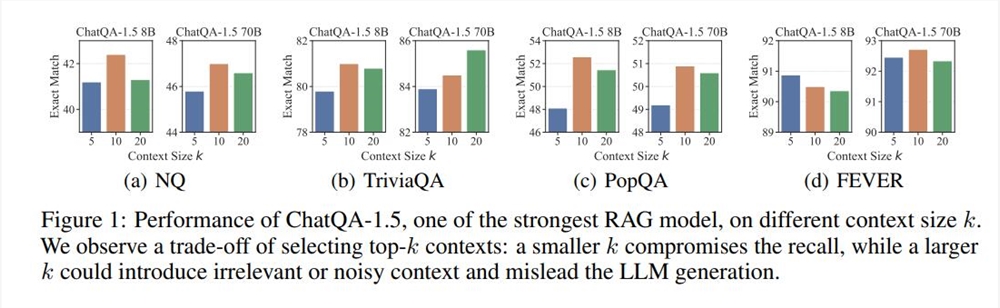

RAG (Recuperación-Generación Aumentada) es una tecnología comúnmente utilizada en la implementación de LLM y es particularmente adecuada para tareas de generación de texto que requieren una gran cantidad de conocimiento fáctico. Generalmente, el proceso de RAG es: un modelo denso basado en codificación de texto recupera los k segmentos de texto principales de una base de datos externa, y luego LLM los lee y genera. Este proceso ha sido ampliamente utilizado, pero también tiene limitaciones, como la selección del valor k. Si el valor k es demasiado grande, incluso el LLM que admite un contexto largo tendrá dificultades para procesarlo rápidamente; si el valor k es demasiado pequeño, se requiere un mecanismo de recuperación de alta recuperación y los recuperadores y modelos de clasificación existentes tienen sus propias deficiencias.

Basado en los problemas anteriores, el marco RankRAG presenta una nueva idea: expandir las capacidades de LLM mediante ajustes y dejar que LLM complete la recuperación y clasificación por sí solo. Los resultados experimentales muestran que este método no solo mejora la eficiencia de los datos, sino que también mejora significativamente el rendimiento del modelo. Especialmente en múltiples puntos de referencia generales y puntos de referencia intensivos en conocimiento biomédico, el modelo Llama38B/70B ajustado por RankRAG superó a los modelos ChatQA-1.58B y ChatQA-1.570B respectivamente.

La clave de RankRAG es su alto grado de interactividad y editabilidad. Los usuarios no sólo pueden ver contenido generado por IA en tiempo real, sino también editarlo e iterarlo directamente en la interfaz. Este mecanismo de retroalimentación instantánea mejora enormemente la eficiencia del trabajo y convierte a la IA en un verdadero asistente poderoso en el proceso creativo. Lo que es aún más emocionante es que esta actualización hace que estos artefactos ya no se limiten a la plataforma Claude y los usuarios puedan compartirlos fácilmente en cualquier lugar.

Esta innovación del marco de ajuste fino de RankRAG también incluye dos etapas de ajuste fino de la instrucción. La primera etapa es el ajuste fino supervisado (SFT), que combina múltiples conjuntos de datos para mejorar la capacidad de seguimiento de instrucciones de LLM. El conjunto de datos de ajuste fino de la segunda etapa contiene una variedad de datos de control de calidad, datos de control de calidad mejorados con recuperación y datos de clasificación contextual para mejorar aún más las capacidades de recuperación y clasificación de LLM.

En experimentos, RankRAG supera consistentemente al actual modelo SOTA de código abierto ChatQA-1.5 en nueve conjuntos de datos de dominio general. Especialmente en tareas de control de calidad desafiantes, como el control de calidad de cola larga y el control de calidad de múltiples saltos, RankRAG mejora el rendimiento en más de un 10 % con respecto a ChatQA-1.5.

En general, RankRAG no solo tiene un buen desempeño en tareas de recuperación y generación, sino que también demuestra su gran adaptabilidad en el punto de referencia biomédico RAG Mirage. Incluso sin realizar ajustes, RankRAG supera a muchos modelos de código abierto en campos especializados en tareas de respuesta a preguntas médicas.

Con la introducción y mejora continua del marco RankRAG, tenemos motivos para creer que el futuro de la creación colaborativa entre la IA y los humanos será más brillante. Tanto los desarrolladores como los investigadores independientes pueden utilizar este marco innovador para inspirar más ideas y posibilidades y promover el desarrollo de tecnología y aplicaciones.

Dirección del artículo: https://arxiv.org/abs/2407.02485

El surgimiento del marco RankRAG presagia otro salto adelante para los modelos lingüísticos a gran escala en los campos de la recuperación de información y la generación de texto. Su diseño simple y eficiente y su excelente rendimiento sin duda proporcionarán nuevas direcciones y motivación para el desarrollo de la tecnología de IA en el futuro. ¡Esperamos que RankRAG muestre su gran potencial en más campos!