La startup israelí de inteligencia artificial aiOla ha lanzado un nuevo modelo de reconocimiento de voz de código abierto Whisper-Medusa, que es una mejora del Whisper de OpenAI y es un 50% más rápido. Es de código abierto bajo la licencia del MIT en Hugging Face y se permite el uso comercial. El editor de Downcodes te dará una explicación detallada de este nuevo y llamativo modelo.

La startup israelí de inteligencia artificial aiOla recientemente dio un gran paso y anunció el lanzamiento de un nuevo modelo de reconocimiento de voz de código abierto Whisper-Medusa.

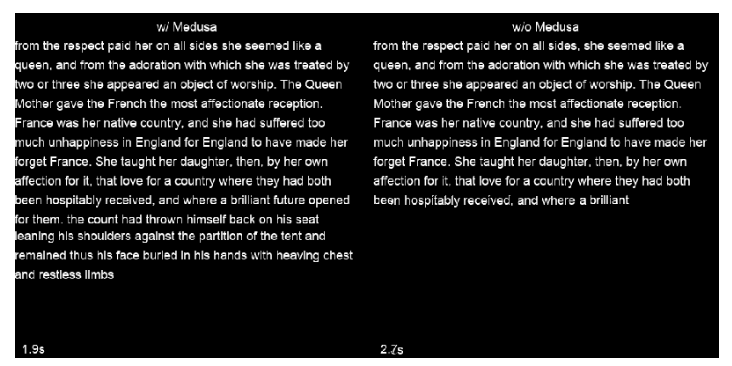

Este modelo no es simple. Es un 50% más rápido que el famoso Whisper de OpenAI. Está construido sobre la base de Whisper, pero utiliza una novedosa arquitectura de "atención de múltiples cabezas" para predecir la cantidad de tokens a la vez. Mucho más allá de OpenAI. productos. Además, el código y los pesos se publicaron en Hugging Face bajo una licencia del MIT, lo que permite la investigación y el uso comercial.

Gill Hetz, vicepresidente de investigación de aiOla, dijo que el código abierto puede fomentar la innovación y la cooperación comunitaria, haciéndola más rápida y completa. Este trabajo podría allanar el camino para sistemas complejos de inteligencia artificial que puedan comprender y responder las preguntas de los usuarios casi en tiempo real.

En esta era en la que los modelos básicos pueden producir una variedad de contenidos, el reconocimiento de voz avanzado sigue siendo muy importante. Whisper, por ejemplo, puede manejar discursos complejos en diferentes idiomas y acentos. Se descarga más de 5 millones de veces al mes, admite muchas aplicaciones y se ha convertido en el estándar de oro para el reconocimiento de voz.

Entonces, ¿qué tiene de especial Whisper-Medusa de aiOla?

La compañía cambió la estructura de Whisper y agregó un mecanismo de atención de múltiples cabezales, que puede predecir 10 tokens a la vez y aumentar la velocidad en un 50% sin afectar la precisión. Se utilizó un método de aprendizaje automático débilmente supervisado para entrenar este modelo y habrá versiones más potentes en el futuro. Es más, debido a que la columna vertebral de Whisper-Medusa se basa en Whisper, las mejoras en la velocidad no se producirán a expensas del rendimiento.

Al entrenar a Whisper-Medusa, aiOla utilizó un método de aprendizaje automático llamado supervisión débil. Como parte de esto, congeló los componentes principales de Whisper y entrenó un módulo de predicción de tokens adicional utilizando las transcripciones de audio generadas por el modelo como etiquetas.

Cuando se le preguntó si alguna empresa podría obtener acceso temprano a Whisper-Medusa, Hetz dijo que han sido probadas en casos de uso de datos empresariales reales y que pueden ejecutarse con precisión en escenarios del mundo real, lo que hará que las aplicaciones de voz tengan mayor capacidad de respuesta en el futuro. En última instancia, cree que el aumento de las velocidades de reconocimiento y transcripción permitirá tiempos de respuesta más rápidos para las aplicaciones de voz y allanará el camino para proporcionar respuestas en tiempo real.

Destacar:

?50% más rápido: Whisper-Medusa de aiOla es significativamente más rápido que el reconocimiento de voz Whisper de OpenAI.

?Sin pérdida de precisión: se mejora la velocidad manteniendo la misma precisión que el modelo original.

Amplias perspectivas de aplicación: se espera que acelere la respuesta, mejore la eficiencia y reduzca los costos en las aplicaciones de voz.

Con todo, se espera que el modelo Whisper-Medusa de aiOla, con su ventaja de velocidad y atributos de código abierto, desencadene una nueva ola en el campo del reconocimiento de voz y aporte importantes mejoras de rendimiento a diversas aplicaciones de voz. El editor de Downcodes seguirá prestando atención al desarrollo posterior y a las contribuciones de la comunidad de este modelo.