Google DeepMind se asoció con varias universidades para desarrollar un nuevo método llamado Modelo de Recompensa Generativa (GenRM), cuyo objetivo es resolver el problema de la precisión y confiabilidad insuficientes de la IA generativa en tareas de razonamiento. Aunque los modelos de IA generativa existentes se utilizan ampliamente en campos como el procesamiento del lenguaje natural, a menudo generan información errónea con confianza, especialmente en campos que requieren una precisión extremadamente alta, lo que limita su alcance de aplicación. La innovación de GenRM es redefinir el proceso de verificación como una tarea de predicción de la siguiente palabra, integrar las capacidades de generación de texto de modelos de lenguaje grande (LLM) en el proceso de verificación y respaldar el razonamiento en cadena, logrando así una verificación más completa y sistemática.

Recientemente, el equipo de investigación de Google DeepMind se asoció con varias universidades para proponer un nuevo método llamado Modelo de Recompensa Generativa (GenRM), cuyo objetivo es mejorar la precisión y confiabilidad de la IA generativa en tareas de razonamiento.

La IA generativa se utiliza ampliamente en muchos campos, como el procesamiento del lenguaje natural. Genera principalmente texto coherente prediciendo la siguiente palabra de una serie de palabras. Sin embargo, estos modelos a veces generan información incorrecta con confianza, lo cual es un gran problema, especialmente en campos donde la precisión es fundamental, como la educación, las finanzas y la atención médica.

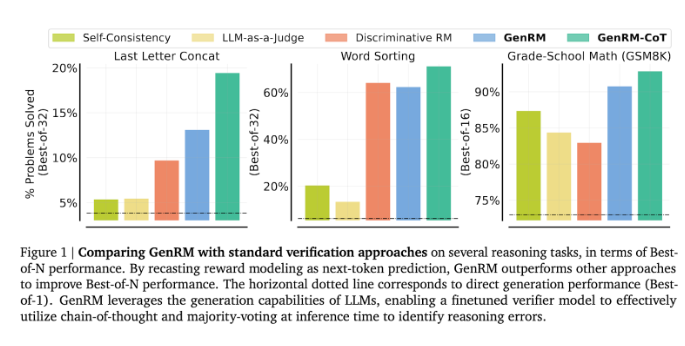

Actualmente, los investigadores han probado diferentes soluciones a las dificultades que encuentran los modelos de IA generativa en la precisión de la salida. Entre ellos, los modelos de recompensa discriminativos (RM) se utilizan para determinar si las posibles respuestas son correctas en función de las puntuaciones, pero este método no logra utilizar plenamente las capacidades generativas de los modelos de lenguaje grande (LLM). Otro método comúnmente utilizado es el "LLM como juez", pero este método a menudo no es tan eficaz como el de un verificador profesional a la hora de resolver tareas de razonamiento complejas.

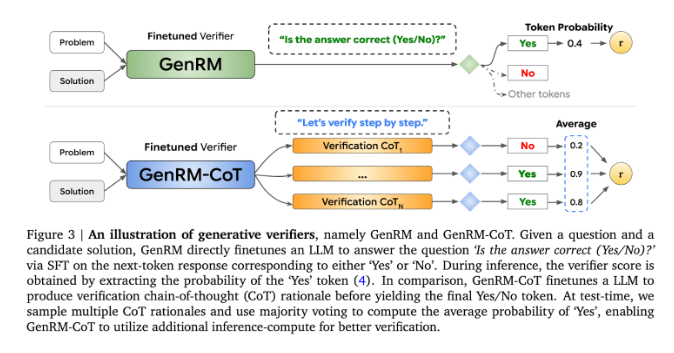

La innovación de GenRM es redefinir el proceso de verificación como una tarea de predicción de la siguiente palabra. Esto significa que, a diferencia de los modelos tradicionales de recompensa discriminativa, GenRM incorpora las capacidades de generación de texto de los LLM en el proceso de verificación, lo que permite que el modelo genere y evalúe soluciones potenciales simultáneamente. Además, GenRM también admite el razonamiento encadenado (CoT), es decir, el modelo puede generar pasos de razonamiento intermedios antes de llegar a la conclusión final, haciendo así que el proceso de verificación sea más completo y sistemático.

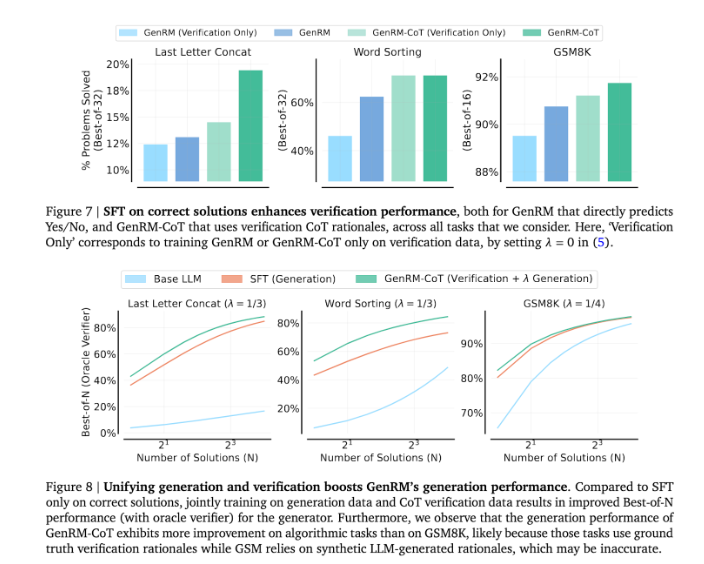

Al combinar generación y validación, el enfoque GenRM adopta una estrategia de capacitación unificada que permite que el modelo mejore simultáneamente las capacidades de generación y validación durante la capacitación. En aplicaciones reales, el modelo genera pasos de inferencia intermedios que se utilizan para verificar la respuesta final.

Los investigadores descubrieron que el modelo GenRM funcionó bien en varias pruebas rigurosas, como una precisión significativamente mejorada en matemáticas preescolares y tareas algorítmicas de resolución de problemas. En comparación con el modelo de recompensa discriminativa y el LLM como método de evaluación, la tasa de éxito en la resolución de problemas de GenRM aumentó entre un 16% y un 64%.

Por ejemplo, al verificar el resultado del modelo Gemini1.0Pro, GenRM aumentó la tasa de éxito en la resolución de problemas del 73 % al 92,8 %.

La introducción del método GenRM marca un avance importante en el campo de la IA generativa, ya que mejora significativamente la precisión y confiabilidad de las soluciones generadas por IA al unificar la generación y verificación de soluciones en un solo proceso.

Con todo, la aparición de GenRM proporciona nuevas ideas para mejorar la confiabilidad de la IA generativa. Su mejora significativa en la resolución de problemas de razonamiento complejos indica la posibilidad de que la IA generativa se aplique en más campos, lo que merece más investigación y exploración.