Alibaba anunció que abrirá el código fuente de su modelo de lenguaje visual de segunda generación Qwen2-VL y proporcionará interfaces API y código fuente abierto para facilitar el uso de los desarrolladores. El modelo ha logrado avances significativos en la comprensión de imágenes y videos, admite múltiples idiomas y tiene sólidas capacidades de agentes visuales, capaces de operar de forma autónoma teléfonos móviles y robots. Qwen2-VL ofrece modelos en tres tamaños: 2B, 7B y 72B para satisfacer las necesidades de diferentes escenarios de aplicaciones. El modelo 72B funciona mejor en la mayoría de los indicadores, mientras que el modelo 2B es adecuado para aplicaciones móviles.

El 2 de septiembre, Tongyi Qianwen anunció el código abierto de su modelo de lenguaje visual de segunda generación Qwen2-VL y lanzó API para tamaños 2B y 7B y su modelo de versión cuantificada en la plataforma Alibaba Cloud Bailian para que los usuarios llamen directamente.

El modelo Qwen2-VL logra mejoras integrales de rendimiento en múltiples aspectos. Puede comprender imágenes de diferentes resoluciones y relaciones de aspecto y ha logrado un rendimiento líder a nivel mundial en pruebas comparativas como DocVQA, RealWorldQA y MTVQA. Además, el modelo también puede comprender vídeos largos de más de 20 minutos y admitir aplicaciones de creación de contenido, diálogo y preguntas y respuestas basadas en vídeo. Qwen2-VL también tiene potentes capacidades de inteligencia visual y puede operar de forma autónoma teléfonos móviles y robots para realizar razonamientos y tomas de decisiones complejos.

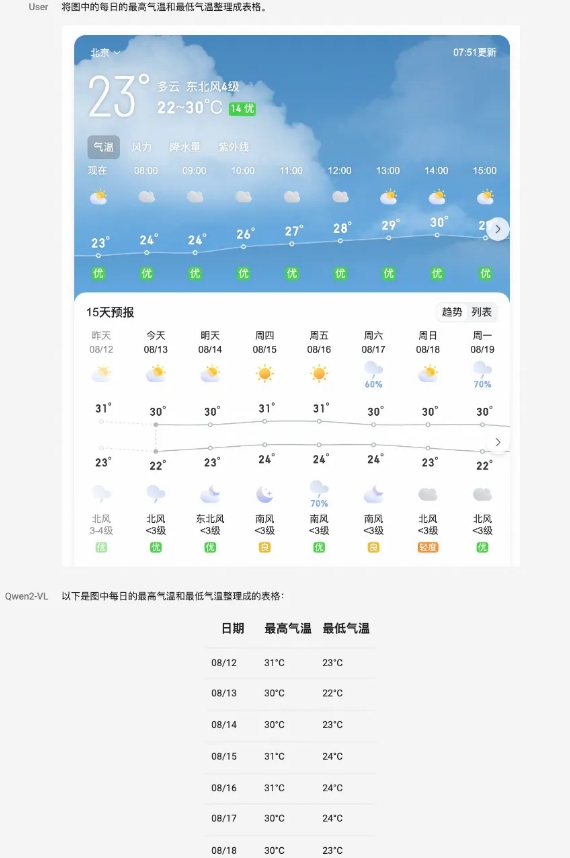

El modelo es capaz de comprender texto multilingüe en imágenes y vídeos, incluidos chino, inglés, la mayoría de los idiomas europeos, japonés, coreano, árabe, vietnamita y más. El equipo de Tongyi Qianwen evaluó las capacidades del modelo desde seis aspectos, incluidas preguntas universitarias integrales, capacidad matemática, comprensión de documentos, tablas, texto e imágenes en varios idiomas, preguntas y respuestas de escenas generales, comprensión de videos y capacidades del agente.

Como modelo insignia, Qwen2-VL-72B ha alcanzado el nivel óptimo en la mayoría de los indicadores. Qwen2-VL-7B logra un rendimiento altamente competitivo con su escala de parámetros económica, mientras que Qwen2-VL-2B admite aplicaciones móviles enriquecidas y tiene capacidades completas de comprensión de imágenes y videos en varios idiomas.

En términos de arquitectura del modelo, Qwen2-VL continúa la estructura en serie de ViT más Qwen2. Los tres tamaños de modelos utilizan 600M ViT, lo que admite la entrada unificada de imágenes y vídeos. Para mejorar la percepción del modelo de la información visual y las capacidades de comprensión de video, el equipo ha actualizado la arquitectura, incluida la implementación de soporte completo para la resolución dinámica nativa y el uso del método de incrustación de posición de rotación multimodal (M-ROPE).

La plataforma Alibaba Cloud Bailian proporciona la API Qwen2-VL-72B, a la que los usuarios pueden llamar directamente. Al mismo tiempo, el código fuente abierto de Qwen2-VL-2B y Qwen2-VL-7B se ha integrado en Hugging Face Transformers, vLLM y otros marcos de terceros, y los desarrolladores pueden descargar y utilizar los modelos a través de estas plataformas.

Plataforma Bailian de la nube de Alibaba:

https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

GitHub:

https://github.com/QwenLM/Qwen2-VL

AbrazandoCara:

https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

Alcance del modelo mágico:

https://modelscope.cn/organization/qwen?tab=model

Experiencia modelo:

https://huggingface.co/spaces/Qwen/Qwen2-VL

En resumen, el código abierto del modelo Qwen2-VL proporciona a los desarrolladores herramientas poderosas, promueve el desarrollo de tecnología de modelos de lenguaje visual y brinda más posibilidades para diversos escenarios de aplicaciones. Los desarrolladores pueden obtener el modelo y el código a través del enlace proporcionado para comenzar a crear sus propias aplicaciones.