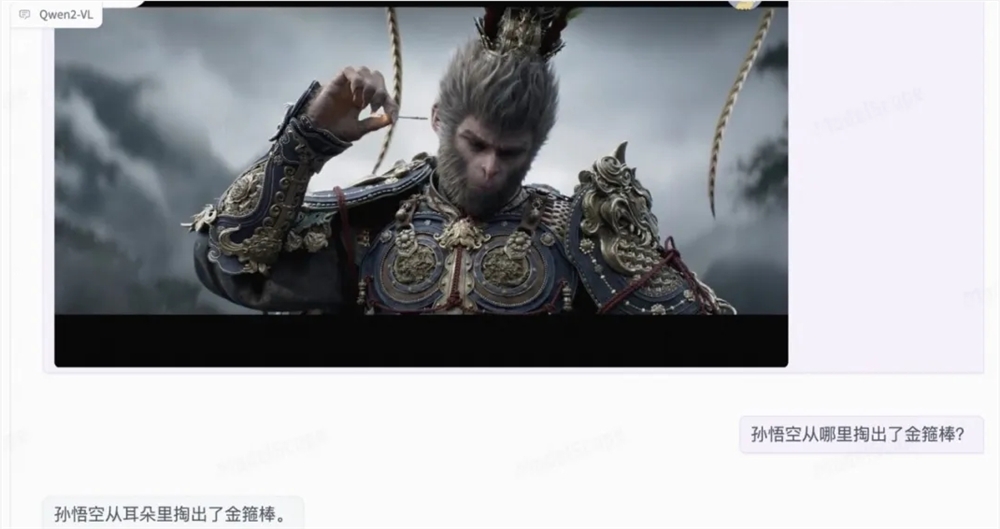

Alibaba Damo Academy lanzó una actualización importante de su modelo de lenguaje multimodal a gran escala Qwen2-VL el 30 de agosto de 2024. Esta actualización logra avances significativos en la comprensión de imágenes, el procesamiento de video y la compatibilidad con varios idiomas, y establece nuevos puntos de referencia de rendimiento. El modelo Qwen2-VL no solo mejora la comprensión de la información visual, sino que también tiene capacidades avanzadas de comprensión de video y funciones de agente de visualización integradas, lo que le permite realizar razonamientos y tomas de decisiones más complejos. Además, la compatibilidad ampliada con varios idiomas facilita su uso a nivel mundial.

El modelo Qwen2-VL ha logrado mejoras significativas en la comprensión de imágenes, el procesamiento de vídeo y la compatibilidad con varios idiomas, estableciendo un nuevo punto de referencia para los indicadores clave de rendimiento. Las nuevas características del modelo Qwen2-VL incluyen capacidades mejoradas de comprensión de imágenes que permiten una comprensión e interpretación más precisas de la información visual; capacidades avanzadas de comprensión de video que permiten que el modelo analice contenido de video dinámico en tiempo real y capacidades de agente de visualización integradas que transforman el modelo; en un agente poderoso para el razonamiento y la toma de decisiones complejos y soporte multilingüe ampliado, haciéndolo más accesible y efectivo en diferentes entornos lingüísticos;

En términos de arquitectura técnica, Qwen2-VL implementa soporte de resolución dinámica y puede procesar imágenes de cualquier resolución sin dividirlas en bloques, garantizando así la coherencia entre la entrada del modelo y la información inherente de la imagen. Además, la innovación de la incrustación de posición rotativa multimodal (M-ROPE) permite que el modelo capture e integre simultáneamente información de posición de texto 1D, visión 2D y video 3D.

El modelo Qwen2-VL-7B conserva con éxito la compatibilidad con entradas de imágenes, múltiples imágenes y vídeo a escala 7B, y funciona bien en tareas de comprensión de documentos y comprensión de textos multilingües basados en imágenes.

Al mismo tiempo, el equipo también lanzó un modelo 2B optimizado para implementación móvil. Aunque la cantidad de parámetros es solo 2B, tiene un buen rendimiento en imágenes, videos y comprensión en varios idiomas.

Enlace del modelo:

Qwen2-VL-2B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-2B-Instruct

Qwen2-VL-7B-Instruct:https://www.modelscope.cn/models/qwen/Qwen2-VL-7B-Instruct

La actualización del modelo Qwen2-VL marca un nuevo avance en la tecnología de modelos de lenguaje multimodal a gran escala. Sus poderosas capacidades en procesamiento de imágenes, videos y múltiples idiomas brindan amplias perspectivas para aplicaciones futuras. El lanzamiento de dos versiones, 7B y 2B, también ofrece opciones más flexibles para diferentes escenarios de aplicación.