El equipo de Alibaba Tongyi Qianwen lanzó el sorprendente modelo matemático Qwen2-Math. Su rendimiento superó al GPT-4 en múltiples pruebas de referencia, e incluso superó la versión de parámetros 72B del modelo de código abierto NuminaMath. Este modelo no solo puede manejar problemas matemáticos ingresados por texto, sino también reconocer fórmulas en imágenes y capturas de pantalla, lo que lo convierte en una poderosa herramienta auxiliar para el aprendizaje de matemáticas. Las diferentes versiones (72B, 7B y 1.5B) brindan opciones para diferentes necesidades, mostrando un gran rendimiento y adaptabilidad.

¡El equipo Tongyi Qianwen de Alibaba ha dado otra gran noticia! Acaban de lanzar la demostración de Qwen2Math. Este modelo matemático es simplemente un pequeño monstruo, incluso GPT-4 está pisoteado.

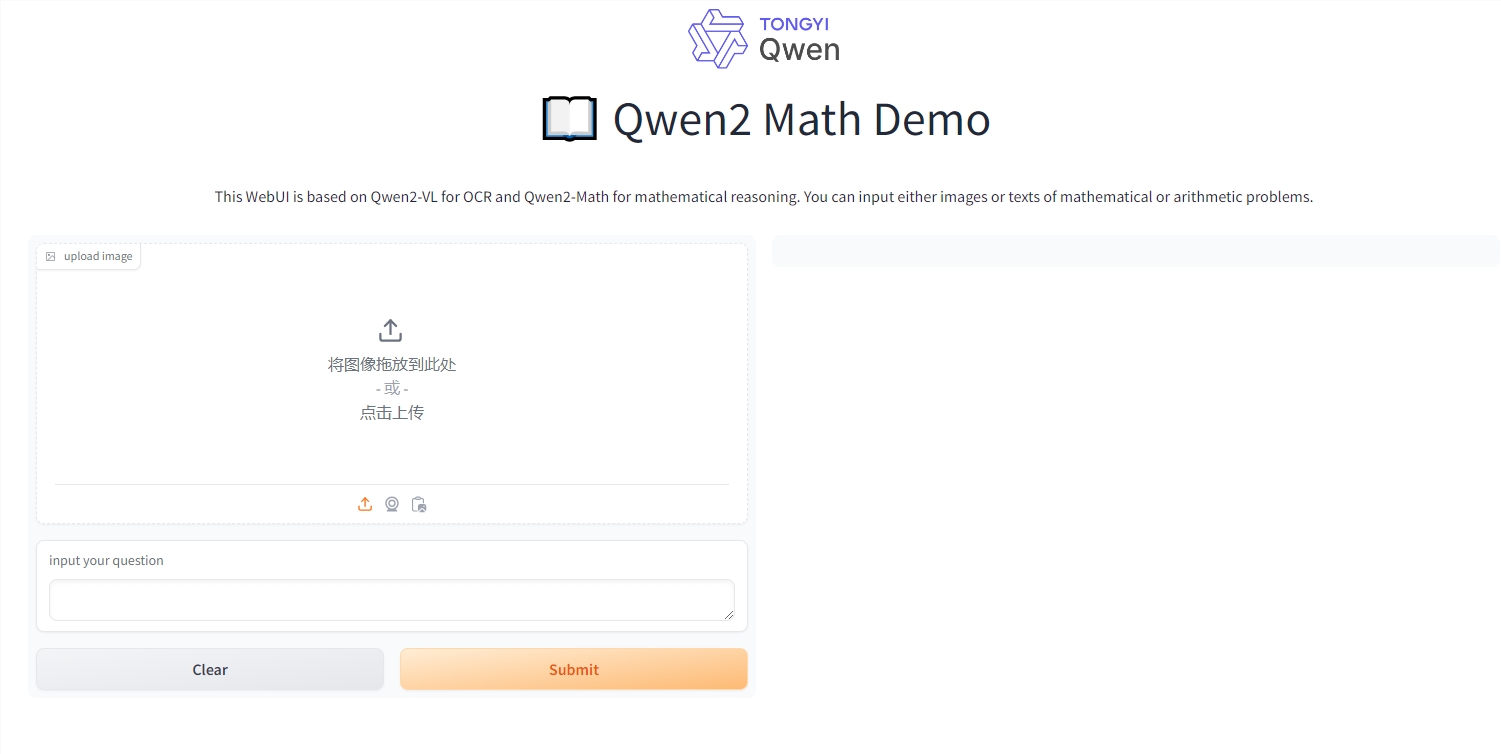

Este modelo no sólo puede manejar problemas matemáticos de entrada de texto, sino también comprender fórmulas en imágenes y capturas de pantalla. Imagina que tomas una foto de un cálculo y te puede dar la respuesta. Es simplemente una herramienta para resolver problemas en la clase de matemáticas (¡Por supuesto, no recomendamos hacer trampa!).

Qwen2-Math se lanza en tres versiones: 72B, 7B y 1.5B. Entre ellos, la versión 72B es simplemente un genio matemático. De hecho, obtuvo 7 puntos más que GPT-4 en el conjunto de datos MATH, un aumento del 9,6%. Esto es como si hubieras obtenido 145 puntos en el examen de matemáticas del examen de ingreso a la universidad, pero el mejor estudiante a tu lado solo obtuvo 132 puntos.

Lo que es aún más sorprendente es que la versión 7B utiliza menos de una décima parte de los parámetros, superando el modelo matemático de código abierto 72B NuminaMath. Ya sabes, NuminaMath es el modelo que ganó el premio en el primer AIMO del mundo, y el premio fue entregado personalmente por Terence Tao, la figura más importante del mundo de las matemáticas.

Lin Junyang, experto senior en algoritmos de Alibaba, anunció con entusiasmo que habían convertido el modelo Qwen2 en un maestro matemático. ¿Cómo lo hicieron? Utilizaron un suplemento cerebral matemático especial: un corpus específico de matemáticas cuidadosamente diseñado. Este suplemento cerebral contiene una gran cantidad de textos, libros, códigos, preguntas de exámenes e incluso preguntas de matemáticas en línea de alta calidad compiladas por el modelo Qwen2.

¿El resultado? En los equipos de pruebas de matemáticas clásicos como GSM8K y MATH, Qwen2-Math-72B dejó atrás al 405B Llama-3.1. Estos conjuntos de pruebas no son una broma. Contienen varios problemas matemáticos como álgebra, geometría, probabilidad y teoría de números.

No solo eso, Qwen2-Math también cuestionó el conjunto de datos chinos CMATH y las preguntas del examen de ingreso a la universidad. En el conjunto de datos chinos, incluso la versión 1.5B puede superar al Llama3.1 70B. Además, independientemente de la versión, en comparación con el modelo básico Qwen2 de la misma escala, el rendimiento ha mejorado significativamente.

Parece que Tongyi Qianwen realmente le preguntó a un genio de las matemáticas esta vez. ¿Podemos preguntarle cuando resuelva problemas matemáticos en el futuro? Pero recuerde, esto es solo una herramienta, no se deje engañar por su inteligencia. Ojos confusos, aún necesita practicar. ¡Tus habilidades matemáticas!

Dirección de la experiencia en línea: https://huggingface.co/spaces/Qwen/Qwen2-Math-Demo

La aparición de Qwen2-Math marca un progreso significativo en modelos de lenguaje a gran escala en el campo de las matemáticas. Aunque es una herramienta poderosa, es más importante desarrollar sus propias habilidades matemáticas y nunca confiar en la herramienta e ignorar el proceso de aprendizaje. Esperamos que Qwen2-Math pueda desempeñar un papel en más campos en el futuro, brindando más comodidad al aprendizaje y la investigación científica.