El rápido desarrollo de los grandes modelos de lenguaje (LLM) ha aportado increíbles capacidades de procesamiento del lenguaje natural, pero sus enormes requisitos informáticos y de almacenamiento limitan su popularidad. Ejecutar un modelo con 176 mil millones de parámetros requiere cientos de gigabytes de espacio de almacenamiento y múltiples GPU de alta gama, lo que lo hace costoso y difícil de escalar. Para resolver este problema, los investigadores se han centrado en técnicas de compresión de modelos, como la cuantificación, para reducir el tamaño del modelo y los requisitos de ejecución, pero también enfrentan el riesgo de pérdida de precisión.

La inteligencia artificial (IA) se está volviendo más inteligente, especialmente los modelos de lenguaje grandes (LLM), que son sorprendentes a la hora de procesar el lenguaje natural. Pero, ¿sabías que detrás de estos cerebros inteligentes de IA se necesita una enorme potencia informática y espacio de almacenamiento para respaldarlos?

Un modelo Bloom multilingüe con 176 mil millones de parámetros requiere al menos 350 GB de espacio solo para almacenar los pesos del modelo, y también requiere varias GPU avanzadas para ejecutarse. Esto no sólo es costoso sino también difícil de popularizar.

Para solucionar este problema, los investigadores han propuesto una técnica llamada "cuantificación". La cuantificación es como "reducir el tamaño" del cerebro de la IA. Al asignar los pesos y activaciones del modelo a un formato de datos de dígitos más bajos, no solo reduce el tamaño del modelo, sino que también acelera la velocidad de ejecución del modelo. Pero este proceso también conlleva riesgos y es posible que se pierda algo de precisión.

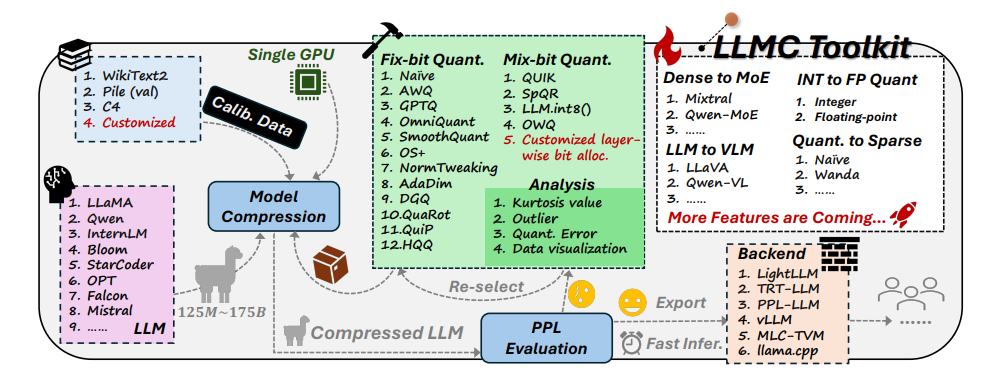

Ante este desafío, investigadores de la Universidad de Beihang y SenseTime Technology desarrollaron conjuntamente el conjunto de herramientas LLMC. LLMC es como un entrenador personal de pérdida de peso para la IA. Puede ayudar a los investigadores y desarrolladores a encontrar el plan de pérdida de peso más adecuado, que puede hacer que el modelo de IA sea más liviano sin afectar su nivel de inteligencia.

El conjunto de herramientas de LLMC tiene tres características principales:

Diversificación: LLMC proporciona 16 métodos cuantitativos diferentes, lo que es como preparar 16 recetas de pérdida de peso diferentes para la IA. Ya sea que su IA quiera perder peso de forma total o local, LLMC puede satisfacer sus necesidades.

Bajo coste: LLMC ahorra muchos recursos y requiere poco soporte de hardware incluso para procesar modelos muy grandes. Por ejemplo, utilizando sólo una GPU A100 de 40 GB, se puede ajustar y evaluar el modelo OPT-175B con 175 mil millones de parámetros. ¡Esto es tan eficiente como usar una cinta de correr casera para entrenar a un campeón olímpico!

Alta compatibilidad: LLMC admite una variedad de configuraciones de cuantificación y formatos de modelo, y también es compatible con una variedad de backends y plataformas de hardware. Es como un entrenador universal que puede ayudarte a desarrollar un plan de entrenamiento adecuado sin importar el equipo que utilices.

Aplicaciones prácticas de LLMC: hacer que la IA sea más inteligente y más eficiente energéticamente

La aparición del conjunto de herramientas LLMC proporciona una prueba de referencia integral y justa para la cuantificación de grandes modelos lingüísticos. Considera tres factores clave: datos de entrenamiento, algoritmo y formato de datos para ayudar a los usuarios a encontrar la mejor solución de optimización del rendimiento.

En aplicaciones prácticas, LLMC puede ayudar a investigadores y desarrolladores a integrar algoritmos apropiados y formatos de bits bajos de manera más eficiente, promoviendo la popularización de la compresión de modelos de lenguaje grandes. Esto significa que es posible que veamos aplicaciones de IA más ligeras pero igualmente potentes en el futuro.

Los autores del artículo también compartieron algunos hallazgos y sugerencias interesantes:

Al seleccionar datos de entrenamiento, debe elegir un conjunto de datos que sea más similar a los datos de prueba en términos de distribución de vocabulario, al igual que cuando los humanos pierden peso, deben elegir recetas apropiadas según sus propias circunstancias.

En términos de algoritmos de cuantificación, exploraron el impacto de las tres técnicas principales de transformación, recorte y reconstrucción, al igual que compararon los efectos de diferentes métodos de ejercicio sobre la pérdida de peso.

Al elegir entre cuantificación entera y de punto flotante, descubrieron que la cuantificación de punto flotante tiene más ventajas en el manejo de situaciones complejas, mientras que la cuantificación entera puede ser mejor en algunos casos especiales. Es como si se necesitaran diferentes intensidades de ejercicio en diferentes etapas de la pérdida de peso.

La llegada del conjunto de herramientas LLMC ha traído una nueva tendencia al campo de la IA. No sólo proporciona un potente asistente para investigadores y desarrolladores, sino que también señala la dirección para el desarrollo futuro de la IA. A través de LLMC, podemos esperar ver aplicaciones de IA más livianas y de alto rendimiento, lo que permitirá que la IA realmente entre en nuestra vida diaria.

Dirección del proyecto: https://github.com/ModelTC/llmc

Dirección del artículo: https://arxiv.org/pdf/2405.06001

Con todo, el kit de herramientas LLMC proporciona una solución eficaz para resolver el problema del consumo de recursos de los modelos de lenguaje grandes. No solo reduce el costo y el umbral de operación del modelo, sino que también mejora la eficiencia y usabilidad del modelo, inyectando una inyección en el. Popularización y desarrollo de la IA con nueva vitalidad. En el futuro, podemos esperar la aparición de aplicaciones de IA más ligeras basadas en LLMC, que aportarán más comodidad a nuestras vidas.