El metacientífico Thomas Scialom explicó en detalle el proceso de desarrollo de Llama 3.1 en el podcast Latent Space y anticipó la dirección de desarrollo de Llama 4. Llama 3.1 no es un simple apilamiento de parámetros, sino una compensación entre el tamaño de los parámetros, el tiempo de entrenamiento y las limitaciones del hardware. Su tamaño de parámetros 405B es una respuesta a GPT-4o. Aunque el enorme tamaño del modelo dificulta su ejecución en computadoras comunes, la función de código abierto permite que más personas participen y promuevan el desarrollo tecnológico.

El nacimiento de Llama3.1 es un equilibrio perfecto entre escala de parámetros, tiempo de entrenamiento y limitaciones de hardware. El enorme cuerpo de 405B no es una elección aleatoria, sino un desafío lanzado por Meta a GPT-4o. Aunque las limitaciones de hardware impiden que Llama3.1 se ejecute en todas las computadoras domésticas, el poder de la comunidad de código abierto hace que todo sea posible.

Durante el desarrollo de Llama 3.1, Scialom y su equipo reexaminaron la Ley de Escala. Descubrieron que el tamaño del modelo era clave, pero más importante era la cantidad total de datos de entrenamiento. Llama3.1 optó por aumentar la cantidad de tokens de entrenamiento, incluso si eso significaba gastar más potencia informática.

No hay cambios trascendentales en la arquitectura de Llama 3.1, pero Meta ha hecho grandes esfuerzos en términos de escala y calidad de los datos. El océano de tokens 15T le ha dado a Llama3.1 un salto cualitativo en profundidad y amplitud de conocimiento.

En términos de selección de datos, Scialom cree firmemente que hay demasiada basura de texto en la Internet pública y que el verdadero oro son los datos sintéticos. En el proceso posterior al entrenamiento de Llama3.1, no se utilizó ninguna respuesta escrita manualmente, sino que se basó completamente en los datos sintéticos generados por Llama2.

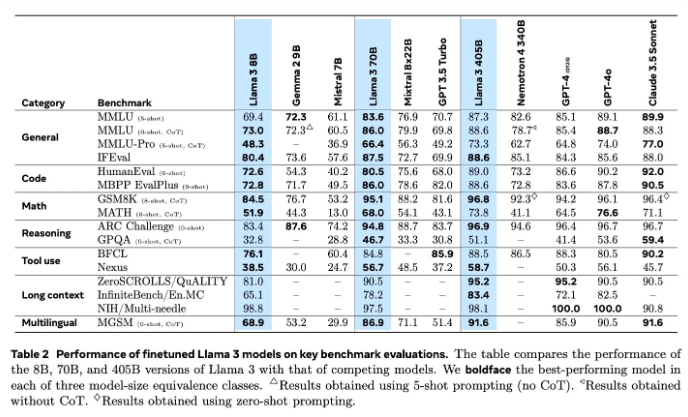

La evaluación de modelos siempre ha sido un problema difícil en el campo de la IA. Llama3.1 ha probado una variedad de métodos de evaluación y mejora, incluidos modelos de recompensa y diversas pruebas de referencia. Pero el verdadero desafío radica en encontrar las indicaciones adecuadas que puedan derrotar a modelos poderosos.

Meta ha iniciado la formación de Llama4 en junio, y esta vez se ha centrado en la tecnología de agentes. El desarrollo de herramientas de agentes como Toolformer presagia la nueva exploración de Meta en el campo de la IA.

El código abierto de Llama3.1 no es solo un intento audaz de Meta, sino también una reflexión profunda sobre el futuro de la IA. Con el lanzamiento de Llama4, tenemos motivos para creer que Meta seguirá liderando el camino en IA. Esperemos ver cómo Llama4 y la tecnología de agentes redefinirán el futuro de la IA.

A través de una comprensión profunda del proceso de I + D de Llama 3.1, podemos ver la innovación y los esfuerzos continuos de Meta en el campo de los modelos de lenguaje a gran escala, así como su énfasis en la comunidad de código abierto. La dirección de investigación y desarrollo de Llama 4 también indica la tendencia de desarrollo futuro de la tecnología de inteligencia artificial, que vale la pena esperar y observar. Esperemos con ansias cómo se desarrollará la tecnología de inteligencia artificial en el futuro.