¿Qué pasaría si la IA se volviera a entrenar utilizando las imágenes que generó? Recientemente, investigadores de la Universidad de Stanford y la Universidad de California en Berkeley realizaron un experimento de este tipo y los resultados fueron sorprendentes.

Los investigadores descubrieron que cuando los modelos de generación de imágenes de IA fueron reentrenados para usar imágenes que ellos mismos generaban, los modelos producían imágenes muy distorsionadas. Peor aún, esta distorsión no se limita a las señales de texto utilizadas para el reentrenamiento. Una vez que el modelo está "contaminado", es difícil que el modelo se recupere por completo, incluso si luego se vuelve a entrenar solo con imágenes reales.

El punto de partida del experimento es un modelo de código abierto llamado Difusión Estable (SD). Los investigadores primero seleccionaron 70.000 imágenes de rostros de alta calidad del conjunto de datos de rostros de FFHQ y las clasificaron automáticamente. Luego utilizaron estas imágenes reales como entrada para generar 900 imágenes consistentes con las características de un grupo específico de personas a través del modelo de Difusión Estable.

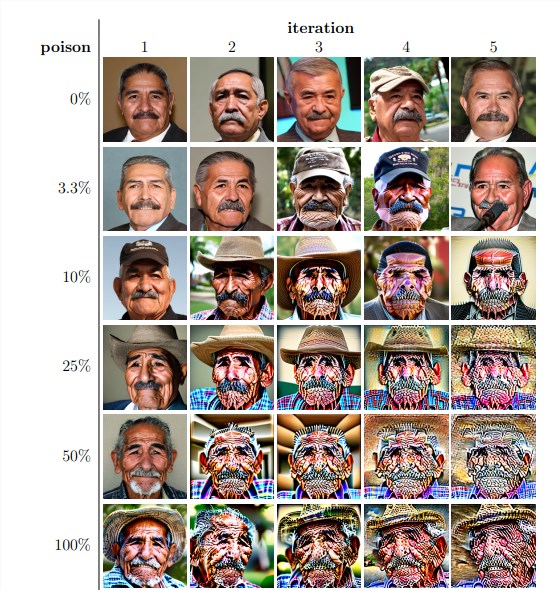

A continuación, los investigadores utilizaron estas imágenes generadas para el reentrenamiento iterativo del modelo. Descubrieron que, independientemente de la proporción de imágenes autogeneradas en el conjunto de datos de reentrenamiento, el modelo finalmente colapsaba y la calidad de las imágenes generadas disminuía drásticamente. Incluso cuando los datos de reentrenamiento contienen solo un 3% de imágenes autogeneradas, el fenómeno del colapso del modelo todavía existe.

Los resultados experimentales muestran que la versión básica del modelo de Difusión Estable genera imágenes que son consistentes con las señales de texto y tienen una alta calidad visual. Pero a medida que el modelo fue reentrenado iterativamente, las imágenes generadas comenzaron a exhibir inconsistencias semánticas y distorsiones visuales. Los investigadores también descubrieron que el colapso del modelo no sólo afectaba la calidad de la imagen sino que también provocaba una falta de diversidad en las imágenes generadas.

Para verificar esto, los investigadores también realizaron experimentos controlados para intentar mitigar el impacto del colapso del modelo ajustando el histograma de color de las imágenes generadas y eliminando imágenes de baja calidad. Pero los resultados muestran que estas medidas no son efectivas para prevenir el colapso del modelo.

Los investigadores también exploraron si era posible que un modelo se recuperara mediante el reentrenamiento después de haber sido "contaminado". Descubrieron que, aunque en algunos casos la calidad de las imágenes resultantes se recuperaba después de múltiples iteraciones de reentrenamiento, persistían signos de colapso del modelo. Esto demuestra que una vez que un modelo está "contaminado", los efectos pueden ser a largo plazo o incluso irreversibles.

Este estudio revela una cuestión importante: los actualmente populares sistemas de IA de generación de texto a imagen basados en difusión son muy sensibles a la “contaminación” de datos. Esta "contaminación" puede ocurrir sin querer, por ejemplo, al extraer indiscriminadamente imágenes de fuentes en línea. También podría tratarse de un ataque dirigido, como colocar deliberadamente datos "contaminados" en un sitio web.

Ante estos desafíos, los investigadores han propuesto algunas posibles soluciones, como utilizar detectores de autenticidad de imágenes para excluir imágenes generadas por IA o agregar marcas de agua a las imágenes generadas. Si bien son imperfectos, estos métodos combinados pueden reducir significativamente el riesgo de "contaminación" de los datos.

Este estudio nos recuerda que el desarrollo de la tecnología de IA no está exento de riesgos. Necesitamos ser más cuidadosos con el contenido generado por IA para asegurarnos de que no tenga impactos negativos a largo plazo en nuestros modelos y conjuntos de datos. Las investigaciones futuras deben explorar más a fondo cómo hacer que los sistemas de IA sean más resistentes a este tipo de "contaminación" de datos o desarrollar técnicas que puedan acelerar la "curación" del modelo.