El equipo de Alibaba Qwen lanzó un nuevo punto de referencia llamado "PROCESSBENCH", cuyo objetivo es evaluar de manera más integral la capacidad de los modelos de lenguaje en el razonamiento matemático, con un enfoque particular en la capacidad del modelo para identificar errores de proceso. Los puntos de referencia existentes tienen limitaciones, como ser demasiado simplistas para modelos de alto nivel o proporcionar solo evaluaciones de corrección binaria, careciendo de un análisis detallado de los pasos de error. La aparición de "PROCESSBENCH" llena este vacío y proporciona una nueva herramienta para una comprensión más profunda y una mejora del mecanismo de razonamiento de los modelos lingüísticos.

Recientemente, investigadores del equipo Qwen de Alibaba lanzaron un nuevo punto de referencia llamado "PROCESSBENCH", que está diseñado para medir la capacidad de los modelos de lenguaje para identificar errores de proceso en el razonamiento matemático. A medida que los modelos de lenguaje han logrado avances significativos en tareas de razonamiento complejas, los investigadores en este campo han descubierto que, a pesar de su excelente desempeño, todavía enfrentan desafíos para manejar ciertos problemas difíciles. Por lo tanto, es particularmente importante desarrollar un método de supervisión eficaz.

Los puntos de referencia de evaluación actuales para modelos lingüísticos tienen algunas deficiencias. Por un lado, algunos conjuntos de problemas se vuelven demasiado simples para los modelos avanzados y, por otro lado, los métodos de evaluación existentes a menudo proporcionan solo evaluaciones de corrección binaria sin anotaciones de error detalladas. Este fenómeno resalta la necesidad urgente de marcos de evaluación más integrales para examinar más profundamente los mecanismos de inferencia de modelos lingüísticos complejos.

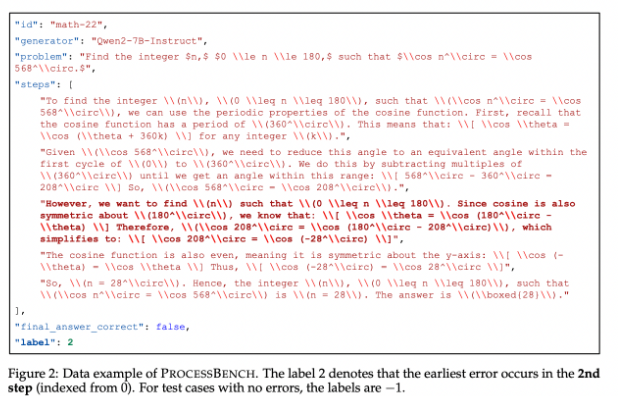

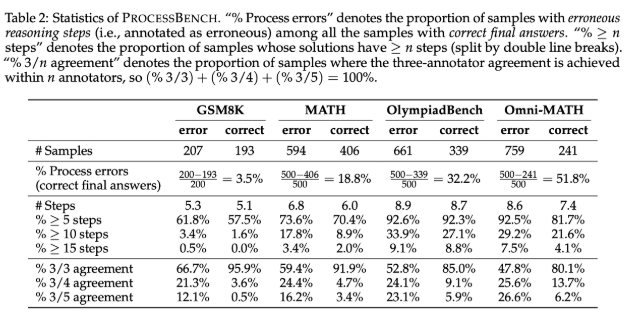

Para llenar este vacío, los investigadores diseñaron "PROCESSBENCH", un punto de referencia centrado en identificar pasos defectuosos en el razonamiento matemático. Sus principios de diseño incluyen la dificultad del problema, la diversidad de soluciones y la evaluación integral. El punto de referencia se centra en problemas matemáticos de nivel competitivo y olímpico, aprovechando múltiples modelos de lenguaje de código abierto para generar soluciones que demuestren diferentes enfoques para resolver los problemas. PROCESSBENCH contiene un total de 3400 casos de prueba que han sido cuidadosamente anotados por múltiples expertos humanos para garantizar la calidad de los datos y la confiabilidad de la evaluación.

Durante el desarrollo, el equipo de investigación recopiló problemas matemáticos de cuatro conjuntos de datos conocidos (GSM8K, MATH, OlympiadBench y Omni-MATH), garantizando que se cubriera una amplia gama de dificultades desde la escuela primaria hasta el nivel de competición. Aprovecharon los modelos de código abierto para generar hasta 12 soluciones diferentes para aumentar la diversidad de soluciones. Además, para unificar el formato de los pasos de la solución, el equipo adoptó un método de reformateo para garantizar un razonamiento paso a paso lógicamente completo.

Los resultados de la investigación muestran que los modelos de recompensa de proceso existentes funcionan mal cuando se trata de problemas difíciles, especialmente en conjuntos de problemas más simples, y el modelo de juicio impulsado por indicaciones tiene un desempeño más destacado. La investigación revela las limitaciones de los modelos existentes a la hora de evaluar el razonamiento matemático, especialmente cuando el modelo alcanza la respuesta correcta a través de pasos intermedios incorrectos, lo que dificulta juzgar con precisión.

Como punto de referencia pionero para evaluar la capacidad de los modelos de lenguaje para identificar errores en el razonamiento matemático, PROCESSBENCH proporciona un marco importante para futuras investigaciones y promueve la comprensión y mejora de la IA en el proceso de razonamiento.

Entrada en papel: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Código: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

En definitiva, el lanzamiento del punto de referencia PROCESSBENCH proporciona una herramienta más completa y profunda para evaluar la capacidad de razonamiento matemático de los modelos de lenguaje, ayudando a promover el desarrollo de la investigación en este campo y, en última instancia, mejorando el rendimiento de los modelos de lenguaje en tareas de razonamiento complejas.