Con la explosión de contenido generado por inteligencia artificial, las plataformas de redes sociales se enfrentan a un desafío sin precedentes: ¿Cómo garantizar que los usuarios puedan distinguir entre información verdadera y falsa? El jefe de Instagram, Adam Mosseri, publicó recientemente una serie de publicaciones en Threads expresando sus preocupaciones sobre el contenido generado por IA y exponiendo las estrategias de Instagram y Meta para enfrentar este desafío. Hizo hincapié en que los usuarios deben estar más atentos y aprender a identificar el contenido generado por IA, y pidió a las plataformas que fortalezcan la supervisión del contenido y mejoren la transparencia y credibilidad de la información.

En una serie reciente de publicaciones en Threads, el director de Instagram, Adam Mosseri, destacó la necesidad de que los usuarios de las redes sociales estén más atentos ante las crecientes cantidades de contenido generado por IA.

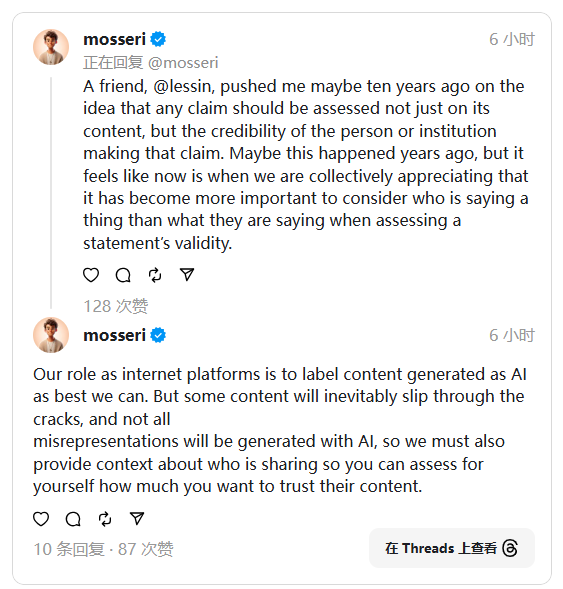

Señaló que las imágenes y la información que los usuarios ven en línea pueden no ser reales, porque la tecnología de inteligencia artificial ya puede generar contenido que es muy similar a la realidad. Para ayudar a los usuarios a juzgar mejor la autenticidad de la información, Mosseri mencionó que los usuarios deben considerar la fuente del contenido, y las plataformas sociales también tienen la responsabilidad de respaldar esto.

Mosseri dijo que el papel de las plataformas de redes sociales es etiquetar el contenido de IA generado tanto como sea posible para ayudar a los usuarios a identificarlo. Sin embargo, también admitió que es posible que se pierdan algunos contenidos y no se puedan marcar a tiempo. Con este fin, enfatizó que las plataformas también deben proporcionar a los usuarios información básica sobre el contenido compartido para que los usuarios puedan decidir mejor en qué medida confiar en el contenido. Sus opiniones reflejan profundas preocupaciones sobre la credibilidad de los mensajes de las redes sociales.

En esta etapa, Meta (la empresa matriz de Instagram) no ha proporcionado suficiente información contextual para ayudar a los usuarios a juzgar la autenticidad del contenido. Aún así, la compañía insinuó recientemente que podría estar realizando cambios significativos en sus reglas de contenido. Se espera que este cambio aumente la confianza de los usuarios en la información y les ayude a afrontar mejor los desafíos que plantea la tecnología de IA.

Mosseri mencionó que los usuarios deben confirmar si la información proporcionada por el chatbot es confiable antes de confiar en un motor de búsqueda impulsado por inteligencia artificial. Esto es similar a verificar la fuente de una publicación o imagen, solo que la información proveniente de cuentas acreditadas es más confiable.

El enfoque de moderación de contenido que describe Mosseri se acerca más a los sistemas de moderación impulsados por el usuario, como las notas de la comunidad en Twitter y los filtros de contenido de YouTube. Si bien no está claro si Meta introducirá características similares, dada la experiencia pasada de la compañía tomando prestado de otras plataformas, vale la pena estar atento a las futuras políticas de moderación de contenido.

Con todo, frente a los desafíos que plantea el contenido generado por IA, Instagram y Meta están explorando activamente soluciones, lo que no solo requiere los esfuerzos de la propia plataforma, sino que también requiere que los usuarios mejoren sus propias capacidades de discernimiento y mantengan conjuntamente la credibilidad y seguridad de la información en línea. La forma en que evolucionará el futuro modelo de supervisión de contenidos merece nuestra atención continua.