En los últimos años, los modelos de lenguajes grandes (LLM) han logrado avances significativos en el campo del procesamiento del lenguaje natural, pero sus métodos de procesamiento a nivel de token tienen limitaciones en la comprensión del contexto y las aplicaciones multilingües y multimodales. Meta AI propone un método completamente nuevo para este propósito: los modelos de conceptos grandes (LCM), con el objetivo de resolver las deficiencias de los LLM existentes. Al modelar en el espacio de incrustación de alta dimensión SONAR, los LCM admiten múltiples idiomas y modalidades, y adoptan una arquitectura jerárquica para mejorar la coherencia y las capacidades de edición local de contenido extenso, lo que mejora en gran medida la eficiencia y las capacidades de generalización del modelo.

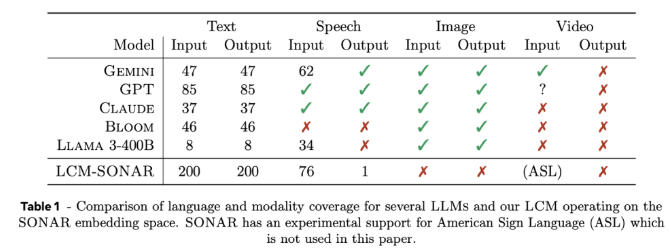

Los modelos de grandes conceptos (LCM) representan un cambio importante con respecto a la arquitectura LLM tradicional. Introducen dos innovaciones importantes: primero, los LCM modelan en un espacio de incrustación de alta dimensión en lugar de depender de tokens discretos. Este espacio de integración, llamado SONAR, está diseñado para admitir más de 200 idiomas y múltiples modalidades, incluidos texto y voz, proporcionando capacidades de procesamiento independientes del idioma y la modalidad. En segundo lugar, el diseño de LCM permite una transición fluida a nivel semántico, lo que permite sólidas capacidades de generalización cero en diferentes lenguajes y modalidades.

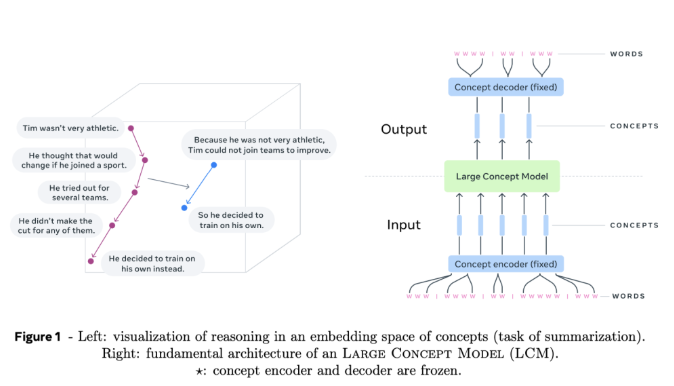

En el núcleo de los LCM, hay codificadores y decodificadores de conceptos, que son componentes que asignan oraciones de entrada al espacio de incrustación de SONAR y decodifican las incrustaciones en lenguaje natural u otras modalidades. El diseño congelado de estos componentes garantiza la modularidad, lo que facilita la ampliación de nuevos lenguajes o modalidades sin volver a entrenar todo el modelo.

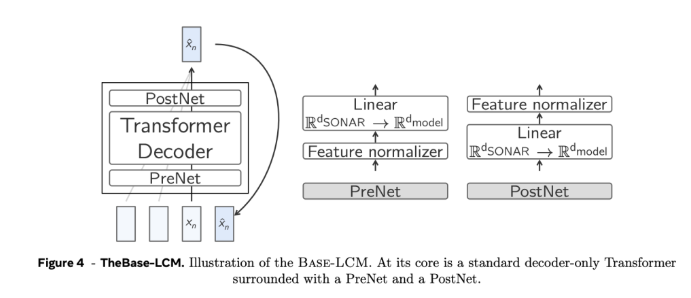

En términos de detalles técnicos, los LCM adoptan una arquitectura jerárquica que imita el proceso de razonamiento humano, mejorando así la coherencia del contenido de formato largo y al mismo tiempo permitiendo la edición local sin alterar el contexto general. Los LCM destacan en el proceso de generación al emplear modelos de difusión que predicen la próxima incorporación de SONAR en función de la incorporación anterior. En el experimento, se utilizaron dos arquitecturas, una torre y una torre doble. La arquitectura de doble torre procesó la codificación de contexto y la eliminación de ruido por separado, lo que mejoró la eficiencia.

Los resultados experimentales muestran que los LCM de dos torres basados en difusión demuestran competitividad en múltiples tareas. Por ejemplo, en la tarea de resumen multilingüe, los LCM superan a los modelos de referencia en el caso de disparo cero, lo que demuestra su adaptabilidad. Al mismo tiempo, los LCM también muestran una alta eficiencia y precisión al procesar secuencias más cortas, lo que se confirma con la mejora significativa en las métricas relacionadas.

El modelo de concepto grande de Meta AI proporciona una alternativa prometedora a los modelos de lenguaje tradicionales a nivel de token, resolviendo algunas de las limitaciones clave de los métodos existentes mediante la incorporación de conceptos de alta dimensión y el procesamiento independiente de la modalidad. A medida que se profundiza la investigación sobre esta arquitectura, se espera que los LCM redefinan las capacidades de los modelos de lenguaje y proporcionen un enfoque más escalable y adaptable a la comunicación impulsada por la IA.

Entrada del proyecto: https://github.com/facebookresearch/large_concept_model

Con todo, el modelo LCM propuesto por Meta AI proporciona una solución innovadora para resolver las limitaciones del LLM tradicional. Sus ventajas en el procesamiento multilenguaje y multimodal y el diseño de arquitectura eficiente le hacen tener un gran futuro en el campo del lenguaje natural. procesamiento tiene un enorme potencial y merece una atención continua y una investigación en profundidad.