Google lanzó oficialmente la TPU de sexta generación, Trillium, y la abrió a los clientes de Google Cloud. Trillium es el TPU más potente de Google hasta la fecha y se utiliza para entrenar Gemini 2.0, su modelo de IA más potente. Mejora significativamente el rendimiento del entrenamiento, el rendimiento de inferencia y la eficiencia energética, al tiempo que logra menores costos. Este artículo analizará en profundidad las mejoras de rendimiento, las características clave y el rendimiento sobresaliente de Trillium TPU en diferentes cargas de trabajo de IA, y demostrará sus casos de aplicación práctica entre clientes como AI21Labs.

A principios de este año, Google lanzó Trillium, su TPU de sexta generación y el más potente hasta la fecha. Hoy, Trillium está oficialmente disponible para los clientes de Google Cloud.

Google utilizó Trillium TPU para entrenar el último Gemini2.0, que es el modelo de inteligencia artificial más potente de Google hasta la fecha. Ahora, tanto las empresas como las nuevas empresas pueden aprovechar la misma infraestructura sólida, eficiente y sostenible.

El núcleo de la supercomputadora de IA: Trillium TPU

Trillium TPU es un componente clave de la hipercomputadora Google Cloud AI. AI Hypercomputer es una innovadora arquitectura de supercomputadora que aprovecha hardware de rendimiento optimizado, software abierto, marcos de aprendizaje automático líderes y sistemas de integración de modelos de consumo flexibles. Con el lanzamiento oficial de Trillium TPU, Google también ha realizado mejoras clave en la capa de software abierto del hiperordenador AI, incluida la optimización del compilador XLA y marcos populares como JAX, PyTorch y TensorFlow para lograr una relación precio/rendimiento líder en entrenamiento de IA. , tuning y servicios .

Además, funciones como la descarga del host utilizando DRAM de host masiva (memoria suplementaria de alto ancho de banda o HBM) proporcionan niveles más altos de eficiencia. AI Hypercomputer le permite extraer el máximo valor de una implementación sin precedentes de más de 100 000 chips Trillium por arquitectura de red Júpiter con 13 petabits/segundo de ancho de banda bidireccional y la capacidad de escalar un único trabajo de entrenamiento distribuido a cientos de miles de aceleradores.

Clientes como AI21Labs ya están utilizando Trillium para ofrecer soluciones de IA significativas a sus clientes más rápido:

Barak Lenz, CTO de AI21Labs, dijo: “En AI21, trabajamos constantemente para mejorar el rendimiento y la eficiencia de los modelos de lenguaje Mamba y Jamba. Como usuarios a largo plazo de TPU v4, estamos impresionados por las capacidades de Trillium de Google Cloud. A escala, velocidad y costo, las mejoras en eficiencia son significativas. Creemos que Trillium desempeñará un papel vital en la aceleración del desarrollo de nuestra próxima generación de modelos de lenguaje complejos, lo que nos permitirá ofrecer soluciones de inteligencia artificial más potentes y accesibles a nuestros clientes".

El rendimiento de Trillium ha mejorado enormemente y muchos indicadores han establecido nuevos récords.

En comparación con la generación anterior, Trillium ha realizado mejoras significativas en:

El rendimiento del entrenamiento mejoró más de 4 veces

Mejora 3 veces mayor en el rendimiento de inferencia

La eficiencia energética aumentó un 67%

Mejora de 4,7 veces el rendimiento informático máximo por chip

La memoria de alto ancho de banda (HBM) duplica su capacidad

La interconexión entre chips (ICI) duplica el ancho de banda

Una única arquitectura de red Júpiter contiene 100.000 chips Trillium

Mejora de 2,5 veces el rendimiento del entrenamiento por dólar y mejora de 1,4 veces el rendimiento de inferencia por dólar

Estas mejoras permiten que Trillium funcione bien en una variedad de cargas de trabajo de IA, que incluyen:

Ampliación de las cargas de trabajo de formación de IA

Entrene LLM, incluidos modelos densos y modelos mixtos de expertos (MoE).

Rendimiento de inferencia y programación colectiva.

Incrustar modelos densos

Proporcionar capacitación e inferencia con rentabilidad.

¿Cómo funciona Trillium en diferentes cargas de trabajo?

Ampliación de las cargas de trabajo de formación de IA

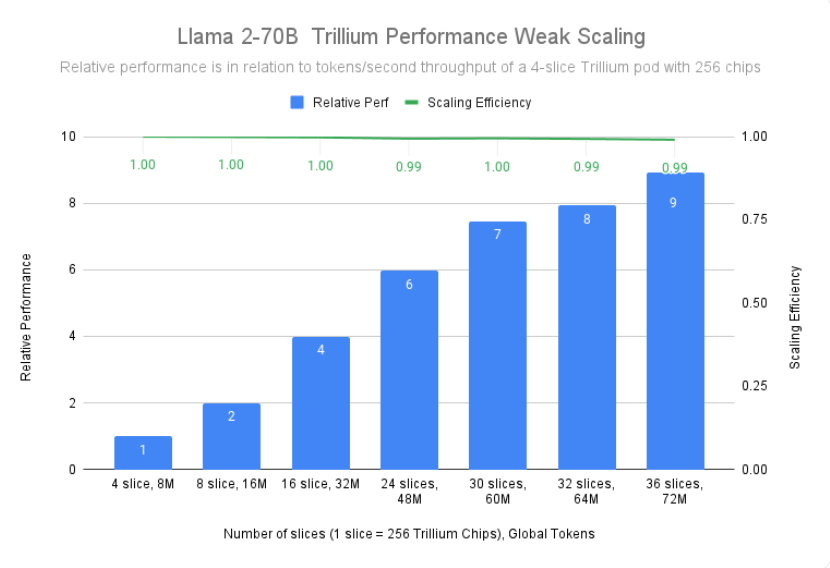

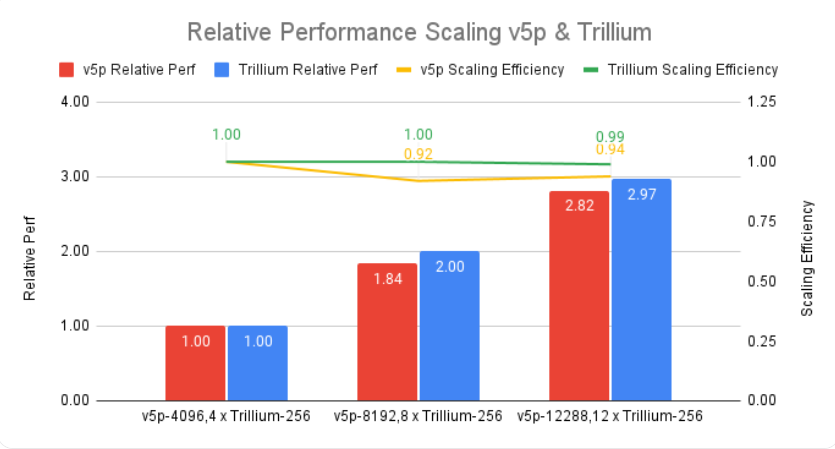

Entrenar un modelo grande como Gemini2.0 requiere una gran cantidad de datos y cálculos. La escalabilidad casi lineal de Trillium permite que estos modelos se entrenen significativamente más rápido al distribuir de manera efectiva y eficiente las cargas de trabajo entre múltiples hosts Trillium, conectados a través de interconexiones de chip a chip de alta velocidad en módulos de 256 chips y nuestra tecnología de última generación. la red de centros de datos de Júpiter. Esto se logra a través de la tecnología de pila completa de múltiples chips de TPU para capacitación a gran escala, y se optimiza aún más a través de Titanium, un sistema de descarga dinámica a nivel de centro de datos que abarca desde adaptadores de host hasta arquitectura de red.

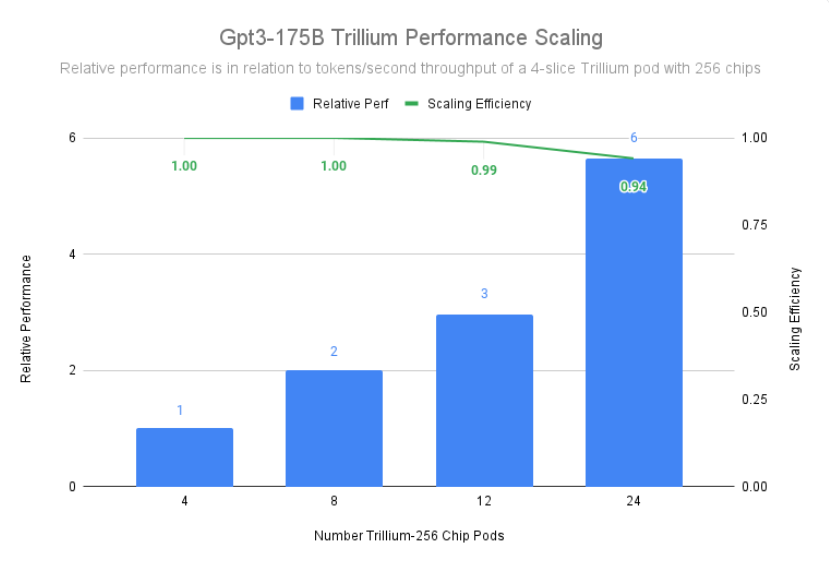

Trillium logró una eficiencia de escalado del 99 % en una implementación de 12 pods con 3072 chips y demostró una eficiencia de escalamiento del 94 % en 24 pods con 6144 chips para entrenar previamente gpt3-175b, incluso en Lo mismo ocurre cuando se ejecuta en redes de centros de datos.

Entrene LLM, incluidos modelos densos y modelos mixtos de expertos (MoE).

Los LLM como Gemini son inherentemente poderosos y complejos, con miles de millones de parámetros. La formación de un LLM tan intensivo requiere una enorme potencia informática, así como una optimización del software codiseñada. Trillium es 4 veces más rápido que la generación anterior Cloud TPU v5e cuando entrena LLM intensivos como Llama-2-70b y gpt3-175b.

Además del LLM intensivo, un enfoque cada vez más popular es entrenar LLM utilizando una arquitectura mixta experta (MoE), que combina múltiples redes neuronales "expertas", cada una especializada en diferentes aspectos de la tarea de IA. Gestionar y coordinar a estos expertos durante la formación añade complejidad en comparación con la formación de un único modelo monolítico. Trillium es 3,8 veces más rápido que la generación anterior Cloud TPU v5e al entrenar modelos MoE.

Además, Trillium TPU proporciona 3 veces la memoria dinámica de acceso aleatorio (DRAM) del host en comparación con Cloud TPU v5e. Esto descarga parte del cálculo al host, lo que ayuda a maximizar el rendimiento a gran escala y un buen rendimiento. La función de descarga de host de Trillium proporciona una mejora de rendimiento de más del 50 % en la utilización del modelo FLOP (MFU) al entrenar el modelo Llama-3.1-405B.

Rendimiento de inferencia y programación colectiva.

La creciente importancia de la inferencia de múltiples pasos requiere aceleradores que puedan manejar de manera eficiente las crecientes demandas computacionales. Trillium proporciona avances significativos para cargas de trabajo de inferencia, lo que permite una implementación más rápida y eficiente de modelos de IA. De hecho, Trillium ofrece nuestro mejor rendimiento de inferencia de TPU para difusión de imágenes y LLM denso. Nuestras pruebas muestran que Stable Diffusion XL tiene un rendimiento de inferencia relativo (imágenes por segundo) más de 3 veces mayor en comparación con Cloud TPU v5e, mientras que Llama2-70B tiene casi 2 veces.

Trillium es nuestra TPU de mayor rendimiento para casos de uso de inferencia de servidor y fuera de línea. La siguiente figura muestra que, en comparación con Cloud TPU v5e, el rendimiento relativo de Stable Diffusion XL (imágenes por segundo) para la inferencia fuera de línea es 3,1 veces mayor y su rendimiento relativo para la inferencia del servidor es 2,9 veces mayor.

Además de un mejor rendimiento, Trillium también introduce nuevas capacidades de programación colectiva. Esta característica permite que el sistema de programación de Google tome decisiones inteligentes de programación de trabajos para mejorar la disponibilidad general y la eficiencia de las cargas de trabajo de inferencia cuando existen múltiples réplicas en la colección. Proporciona una manera de administrar múltiples segmentos de TPU que ejecutan cargas de trabajo de inferencia de un solo host o de múltiples hosts, incluso a través de Google Kubernetes Engine (GKE). Agrupar estas piezas en una colección facilita ajustar el número de réplicas para satisfacer la demanda.

Incrustar modelos densos

Al agregar SparseCore de tercera generación, Trillium mejora el rendimiento de los modelos de integración intensiva 2 veces y DLRM DCNv2 5 veces.

SparseCore es un procesador de flujo de datos que proporciona una base arquitectónica más adaptable para cargas de trabajo integradas intensivas. SparseCore de tercera generación de Trillium se destaca por acelerar operaciones dinámicas y relacionadas con datos, como la recopilación de dispersión, las sumas de segmentos dispersos y la partición.

Proporcionar capacitación e inferencia con rentabilidad.

Además del gran rendimiento y escala necesarios para entrenar algunas de las cargas de trabajo de IA más grandes del mundo, Trillium está diseñado para optimizar el rendimiento por dólar. Hasta la fecha, Trillium ha logrado un rendimiento por dólar 2,1 veces mejor que Cloud TPU v5e y 2,5 veces mejor que Cloud TPU v5p al capacitar LLM intensivos como Llama2-70b y Llama3.1-405b.

Trillium sobresale en el procesamiento rentable de modelos grandes en paralelo. Está diseñado para permitir a los investigadores y desarrolladores ofrecer modelos de imágenes potentes y eficientes a un costo mucho menor que antes. El costo de generar mil imágenes en Trillium es un 27% menor que Cloud TPU v5e para inferencia fuera de línea y un 22% menor que Cloud TPU v5e para inferencia de servidor en SDXL.

Llevando la innovación en IA al siguiente nivel

Trillium representa un gran avance en la infraestructura de IA de Google Cloud, ya que ofrece un rendimiento, escalabilidad y eficiencia increíbles para una variedad de cargas de trabajo de IA. Con su capacidad de escalar a cientos de miles de chips utilizando software de codiseño de clase mundial, Trillium le permite lograr avances más rápidos y ofrecer soluciones de IA superiores. Además, la excepcional relación precio/rendimiento de Trillium lo convierte en una opción rentable para las organizaciones que buscan maximizar el valor de sus inversiones en IA. A medida que el panorama de la IA continúa evolucionando, Trillium demuestra el compromiso de Google Cloud de proporcionar infraestructura de vanguardia para ayudar a las empresas a desbloquear todo el potencial de la IA.

Introducción oficial: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

En definitiva, la aparición de Trillium TPU marca una mejora significativa en las capacidades informáticas de IA en la nube. Su potente rendimiento, escalabilidad y beneficios económicos promoverán un desarrollo más rápido en el campo de la IA y proporcionarán soluciones de IA más potentes para empresas e instituciones de investigación.