OpenAI anunció que se ha visualizado el modo de voz avanzado de ChatGPT. Los usuarios que se suscriban a Plus, Team o Pro pueden interactuar con ChatGPT en tiempo real a través de las cámaras de sus teléfonos móviles y tienen capacidades para compartir pantalla. Esta función se ha retrasado muchas veces y finalmente se lanzó oficialmente después de un largo período de prueba. Sin embargo, no todos los usuarios pueden usarla de inmediato. Algunas regiones y tipos de usuarios tendrán que esperar hasta enero del próximo año o incluso más.

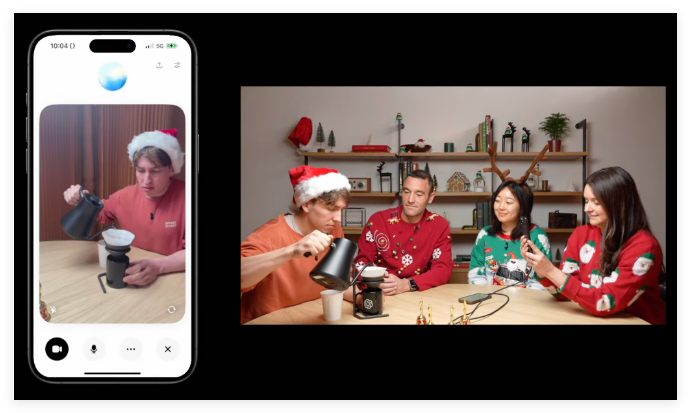

OpenAI anunció el jueves que se ha visualizado la función de conversación similar a la humana "Modo de voz avanzado" que desarrolló para ChatGPT. Los usuarios que se suscriben a ChatGPT Plus, Team o Pro ahora pueden apuntar la cámara de su teléfono a un objeto y ChatGPT responderá casi en tiempo real.

Este modo de voz avanzado con funciones de visión también presenta capacidades para compartir pantalla que analizan el contenido en la pantalla del dispositivo. Por ejemplo, puede explicar varios menús de configuración y brindar consejos sobre problemas matemáticos.

El método de uso es muy simple: haga clic en el ícono de voz al lado de la barra de chat de ChatGPT y luego haga clic en el ícono de video en la esquina inferior izquierda para iniciar el video. Si desea compartir su pantalla, puede hacer clic en el menú de tres puntos y seleccionar "Compartir pantalla".

Con respecto al lanzamiento de funciones, OpenAI dijo que el modo de voz avanzado con visión se implementará a partir de este jueves y finalizará la próxima semana. Es importante tener en cuenta que esto no estará disponible para todos los usuarios de inmediato. Los usuarios de ChatGPT Enterprise y Edu tendrán que esperar hasta enero del próximo año, mientras que los usuarios de la UE, Suiza, Islandia, Noruega y Liechtenstein aún no han anunciado un calendario específico.

Durante una aparición reciente en "60 Minutes" de CNN, el presidente de OpenAI, Greg Brockman, demostró capacidades avanzadas de análisis visual para patrones de habla a Anderson Cooper. Cuando Cooper dibujó partes del cuerpo humano en la pizarra, ChatGPT pudo comprender y comentar sus dibujos. Por ejemplo, afirma que el cerebro está posicionado con precisión y sugiere que la forma del cerebro se acerca más a una elipse.

Sin embargo, durante la demostración, este modo de habla avanzado también reveló algunas imprecisiones en cuestiones geométricas, lo que muestra el riesgo potencial de "alucinaciones".

Cabe mencionar que este modo de voz avanzado con funciones visuales se ha retrasado varias veces. En abril, OpenAI prometió que se lanzaría "en unas semanas", pero luego dijo que necesitaría más tiempo. Esta función no estuvo disponible para algunos usuarios de ChatGPT hasta principios de este otoño y la función de análisis visual aún no estaba disponible en ese momento.

En medio de una creciente competencia en inteligencia artificial, rivales como Google y Meta también están desarrollando capacidades similares. Esta semana, Google ha abierto su proyecto de inteligencia artificial conversacional de análisis de vídeo en tiempo real, Proyecto Astra, a algunos probadores de Android.

Además de las funciones visuales, OpenAI también lanzó el jueves un "Modo Santa" festivo, que permite a los usuarios habilitar la voz de Santa a través del ícono de copo de nieve al lado de la barra de notificaciones en la aplicación ChatGPT.

Esta actualización visual del modo de voz avanzado de ChatGPT marca una mejora en la capacidad de la IA para interactuar con el mundo real, pero también expone desafíos y limitaciones en el desarrollo tecnológico. En el futuro, vale la pena esperar la mejora y popularización de funciones similares. El avance de la tecnología de inteligencia artificial seguirá afectando nuestro estilo de vida.