El último modelo de lenguaje visual abierto de NVIDIA, NVILA, ha logrado importantes avances en precisión y eficiencia, convirtiéndose en otro hito en el campo de la IA visual. En comparación con otros modelos de visión a gran escala, NVILA ha logrado reducciones significativas en los costos de capacitación, el uso de memoria y la latencia. También ha demostrado un rendimiento excelente en múltiples pruebas comparativas, superando incluso a algunos competidores. El artículo presenta en detalle los detalles técnicos de NVILA, incluida la tecnología de "expansión primero y compresión después", así como la expansión dinámica S2, la poda de conjuntos de datos basada en DeltaLoss y otras estrategias de optimización, con el objetivo de equilibrar la precisión y la eficiencia del modelo. Esto marca el desarrollo de la tecnología de modelos de lenguaje visual en una dirección más económica y eficiente.

Recientemente, NVIDIA lanzó una nueva generación de modelo de lenguaje visual abierto: NVILA. Diseñado para optimizar la precisión y la eficiencia, se ha convertido en un líder en el campo de la IA visual con su rendimiento sobresaliente.

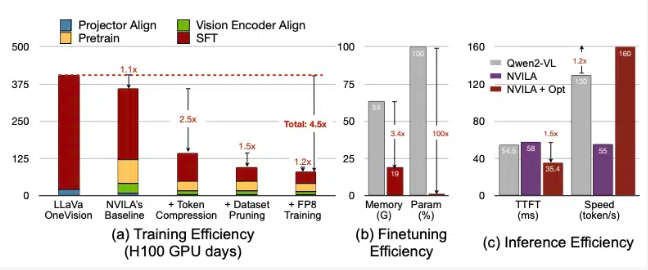

Según NVIDIA, NVILA reduce los costos de capacitación 4,5 veces, reduce la memoria necesaria para el ajuste fino 3,4 veces y reduce las latencias de precarga y decodificación casi 2 veces. Estos datos se comparan con otro modelo de gran visión, LLaVa OneVision.

En pruebas de vídeo, NVILA superó a GPT4o Mini y también tuvo un buen desempeño en comparación con GPT4o, Sonnet3.5 y Gemini1.5Pro. Además, NVILA también logró una ligera victoria en la comparación con Llama3.2. A pesar de esto, NVIDIA declaró que el modelo aún no se ha lanzado a la plataforma Hugging Face y prometieron publicar el código y el modelo pronto para promover la reproducibilidad del modelo.

NVIDIA señaló que el costo de entrenar modelos de lenguaje visual es muy alto. Se necesitan aproximadamente 400 días de GPU para entrenar un modelo de lenguaje visual de 7B parámetros. Al mismo tiempo, ajustar un modelo de este tipo también consume mucha memoria: un modelo de parámetros 7B requiere más de 64 GB de memoria GPU.

Por lo tanto, NVIDIA utiliza una técnica llamada expandir y luego comprimir para equilibrar la precisión y la eficiencia del modelo. En lugar de reducir el tamaño de las fotos y los vídeos, el modelo utiliza múltiples fotogramas de imágenes y vídeos de alta resolución para garantizar que no se pierda ningún detalle.

Durante el proceso de compresión, el modelo reduce el tamaño de los datos de entrada comprimiendo la información visual en menos tokens y agrupa píxeles para retener información importante. NVIDIA mencionó en el documento que duplicar la resolución duplicará la cantidad de tokens visuales, lo que aumentará los costos de entrenamiento e inferencia en más de 2 veces. Por lo tanto, reducen este costo comprimiendo tokens de espacio/tiempo.

NVIDIA también mostró demostraciones de algunos modelos y NVILLA puede responder múltiples consultas basadas en una imagen o un video. Sus resultados de salida también se comparan con el modelo VILA1.5 lanzado anteriormente por NVIDIA. Además, NVIDIA también presentó en detalle algunas otras tecnologías, como la expansión dinámica S2, la poda de conjuntos de datos basada en DeltaLoss, la cuantificación con precisión FP8, etc.

Estas técnicas se aplican a un modelo de parámetros 8B y los detalles específicos se pueden ver en Arxiv.

Entrada en papel: https://arxiv.org/pdf/2412.04468

Destacar:

? El modelo NVILA reduce los costos de capacitación en 4,5 veces, mejorando la eficiencia de la IA visual.

? Con imágenes y fotogramas de vídeo de alta resolución, NVILA garantiza la integridad de la información de entrada.

? NVIDIA promete lanzar códigos y modelos pronto para promover la reproducibilidad de la investigación.

Con todo, la aparición de NVILA ha brindado nuevas posibilidades para el desarrollo de modelos de lenguaje visual. Su proceso eficiente de entrenamiento e inferencia reducirá el umbral para las aplicaciones de IA visual y promoverá un mayor desarrollo en este campo. Esperamos con interés la pronta divulgación del código y los modelos de NVIDIA para que más investigadores puedan participar y promover conjuntamente el progreso de la tecnología de IA visual.