Epoch AI lanzó recientemente un simulador de potencia informática de entrenamiento de modelos de lenguaje a gran escala. El simulador proporciona una referencia valiosa para los investigadores al simular el costo y la eficiencia del entrenamiento de GPT-4 en diferentes condiciones de hardware. Los resultados de la simulación muestran que incluso usando una tarjeta gráfica antigua GTX580 de 2012 se puede entrenar GPT-4, pero el costo será diez veces mayor que el del hardware moderno, lo que resalta la importancia de mejorar el rendimiento del hardware para el entrenamiento del modelo de IA. El simulador también admite simulación de entrenamiento en múltiples centros de datos, lo que permite a los usuarios personalizar parámetros y analizar las diferencias de rendimiento de diferentes hardware y estrategias de entrenamiento, proporcionando una base importante para la toma de decisiones para el entrenamiento de futuros modelos de IA a gran escala.

Recientemente, la empresa de investigación de inteligencia artificial Epoch AI lanzó un simulador interactivo diseñado específicamente para simular la potencia informática necesaria para entrenar modelos de lenguaje de gran tamaño. Utilizando este simulador, los investigadores descubrieron que, si bien era posible entrenar GPT-4 utilizando tarjetas gráficas más antiguas de 2012, como una GTX580, el coste sería diez veces mayor que el del hardware moderno actual.

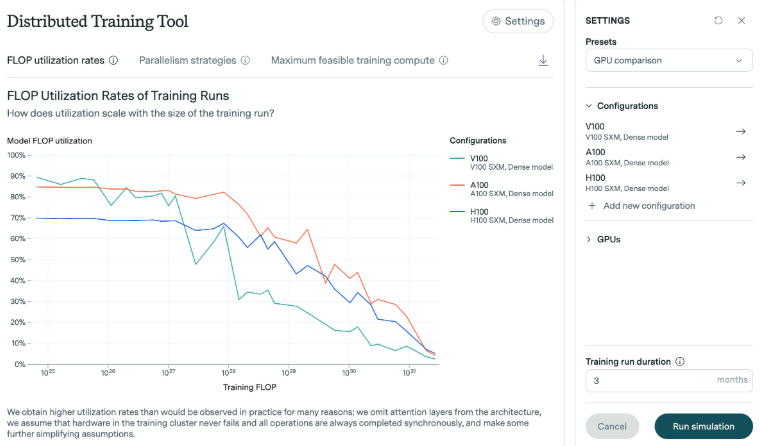

La investigación de Epoch AI muestra que la cantidad de operaciones de punto flotante (FLOP) necesarias para entrenar GPT-4 está entre 1e25 y 1e26. Para este estudio, el simulador analizó la eficiencia de diferentes tarjetas gráficas, especialmente a medida que el modelo crece. Los resultados muestran que a medida que el modelo crece, la eficiencia generalmente disminuye. Tomemos como ejemplo la tarjeta gráfica H100 lanzada en los últimos años. Puede mantener una alta eficiencia durante mucho tiempo, mientras que la eficiencia de la tarjeta gráfica V100 cae más obviamente cuando se enfrenta a escalas de entrenamiento más grandes.

En los experimentos de Epoch AI, la memoria de la tarjeta gráfica GTX580 era de solo 3 GB. Esta tarjeta gráfica fue la opción principal al entrenar el modelo AlexNet en 2012. Aunque la tecnología ha avanzado, los investigadores creen que la formación a tan gran escala es posible utilizando hardware más antiguo, pero los recursos y costes necesarios serían prohibitivos.

Además, el simulador admite simulaciones de entrenamiento complejas en múltiples centros de datos. Los usuarios pueden personalizar parámetros como el tamaño del centro de datos, la latencia y el ancho de banda de la conexión para simular ejecuciones de entrenamiento en múltiples ubicaciones. Esta herramienta también permite analizar las diferencias de rendimiento entre las tarjetas gráficas modernas (como H100 y A100), estudiar los efectos de diferentes tamaños de lote y entrenamiento multi-GPU, y generar archivos de registro detallados que documenten la salida del modelo.

Epoch AI dijo que desarrolló el simulador para profundizar su comprensión de las mejoras en la eficiencia del hardware y evaluar el impacto de los controles de exportación de chips. Con el aumento esperado de misiones de entrenamiento a gran escala durante este siglo, es especialmente importante comprender los requisitos de hardware necesarios en el futuro.

En definitiva, esta investigación y simulador de Epoch AI proporciona un valor de referencia importante para el entrenamiento de grandes modelos de lenguaje, ayudando a los investigadores a comprender mejor la eficiencia del hardware, optimizar las estrategias de entrenamiento y proporcionar un entrenamiento más confiable para futuros modelos de IA.