Los modelos de lenguajes grandes (LLM) han logrado un gran éxito en el campo del procesamiento del lenguaje natural, pero su procesamiento basado en tokens limita su rendimiento en la comprensión de textos largos y en aplicaciones multilingües y multimodales. El modelo de concepto grande (LCM) propuesto por Meta AI proporciona una solución completamente nueva que opera unidades semánticas abstractas: conceptos en un espacio de incrustación de alta dimensión, superando así las limitaciones del LLM. La innovación de LCM radica en su enfoque de modelado independiente del lenguaje y la modalidad, así como en su arquitectura jerárquica y mecanismo de generación basado en difusión. Esto permite a LCM lograr un modelado de lenguaje eficiente y escalable con sólidas capacidades de generalización inmediata.

Los modelos de lenguaje grande (LLM) han logrado avances significativos en el campo del procesamiento del lenguaje natural (NLP), lo que los ha hecho populares en aplicaciones como la generación de texto, el resumen y la respuesta a preguntas. Sin embargo, la dependencia de LLM del procesamiento a nivel de token (predecir una palabra a la vez) también plantea algunos desafíos. Este enfoque contrasta con la forma en que los humanos se comunican, que normalmente opera en un nivel más alto de abstracción, como oraciones o ideas.

El modelado a nivel de token también se queda corto en tareas que requieren una comprensión del contexto a largo plazo y puede producir resultados inconsistentes. Además, ampliar estos modelos a aplicaciones multilingües y multimodales es computacionalmente costoso y requiere muchos datos. Para resolver estos problemas, los investigadores de Meta AI propusieron un nuevo método: el modelo conceptual grande (LCM).

Grandes modelos conceptuales: un nuevo paradigma para la comprensión semántica

El gran modelo conceptual (LCM) de Meta AI representa un cambio con respecto a la arquitectura LLM tradicional. LCM introduce dos innovaciones importantes:

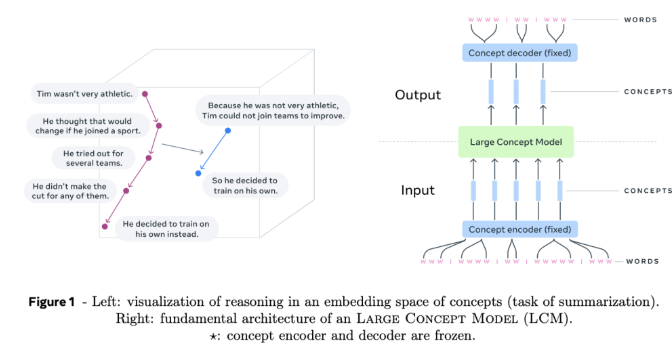

Modelado de espacios de incrustación de alta dimensión: LCM ya no opera en tokens discretos, sino que realiza cálculos en un espacio de incrustación de alta dimensión. Este espacio representa unidades abstractas de significado, llamadas conceptos, correspondientes a oraciones o enunciados. Este espacio de integración, llamado SONAR, está diseñado para ser independiente del idioma y la modalidad, y admite más de 200 idiomas y múltiples modalidades, incluidos texto y voz.

Modelado independiente del lenguaje y la modalidad: a diferencia de los modelos que están vinculados a un lenguaje o modalidad específica, LCM procesa y genera contenido a un nivel puramente semántico. Este diseño permite un cambio fluido entre idiomas y modalidades, lo que da como resultado una fuerte generalización cero.

En el núcleo de LCM se encuentran codificadores y decodificadores de conceptos que asignan oraciones de entrada al espacio de incrustación de SONAR y decodifican las incrustaciones en lenguaje natural u otras modalidades. Estos componentes están congelados, lo que garantiza modularidad y una fácil expansión a nuevos lenguajes o modalidades sin tener que volver a entrenar todo el modelo.

Detalles técnicos y ventajas de LCM

LCM introduce varias innovaciones para avanzar en el modelado del lenguaje:

Arquitectura en capas: LCM adopta una estructura en capas que refleja el proceso de razonamiento humano. Este diseño mejora la coherencia del contenido de formato largo y permite la edición local sin destruir el contexto más amplio.

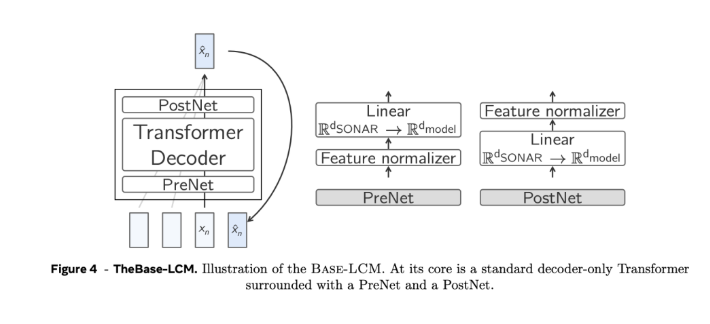

Generación basada en difusión: el modelo de difusión se considera el diseño más eficiente de LCM. Estos modelos predicen la próxima incorporación de SONAR en función de la incorporación anterior. Se exploraron dos arquitecturas:

Torre única: un único decodificador Transformer maneja la codificación de contexto y la eliminación de ruido.

Torres Gemelas: codificación de contexto separada y eliminación de ruido, proporcionando componentes dedicados para cada tarea.

Escalabilidad y eficiencia: en comparación con el procesamiento a nivel de token, el modelado a nivel de concepto reduce la longitud de las secuencias, resuelve la complejidad cuadrática de los Transformers estándar y puede manejar contextos largos de manera más eficiente.

Generalización de disparo cero: LCM exhibe sólidas capacidades de generalización de disparo cero en lenguajes y modalidades invisibles al aprovechar el amplio soporte multilenguaje y multimodalidad de SONAR.

Criterios de búsqueda y detención: Algoritmo de búsqueda con criterios de detención basados en la distancia al concepto de "fin de documento", asegurando una generación coherente y completa sin necesidad de ajustes.

Con todo, el gran modelo conceptual (LCM) de Meta AI aporta nuevas ideas al campo del procesamiento del lenguaje natural. Sus ventajas en el procesamiento de textos largos, datos multilingües y multimodales indican una dirección importante para el desarrollo futuro de los modelos lingüísticos. . El surgimiento de LCM mejorará significativamente las capacidades de la inteligencia artificial en el procesamiento de información entre idiomas y modos, y ampliará sus aplicaciones en más campos.