Answer.AI y LightOn lanzaron conjuntamente el modelo de lenguaje de código abierto ModernBERT, que supone una mejora importante con respecto a Google BERT y ha mejorado significativamente la velocidad, la eficiencia y la calidad. ModernBERT procesa cuatro veces más rápido que BERT, utiliza menos memoria y puede manejar texto hasta 8192 tokens, que es 16 veces más rápido que los modelos existentes. También logró un gran progreso en la codificación de código de programación por primera vez, con una puntuación de más de 80 en el conjunto de datos de preguntas y respuestas de StackOverflow, estableciendo un nuevo récord. Más importante aún, ModernBERT reduce significativamente el costo del procesamiento de texto a gran escala y puede ejecutarse en hardware común de consumo, lo que lo hace más rentable que modelos como GPT-4.

El diseño de ModernBERT le permite manejar texto de hasta 8192 tokens de longitud, lo que supone una mejora 16 veces mayor que el límite típico de 512 tokens de los modelos de codificación existentes. Además, ModernBERT es el primer modelo de codificación de código de programación ampliamente capacitado y logró una puntuación de más de 80 en el conjunto de datos de preguntas y respuestas de StackOverflow, estableciendo un nuevo récord para modelos de codificación.

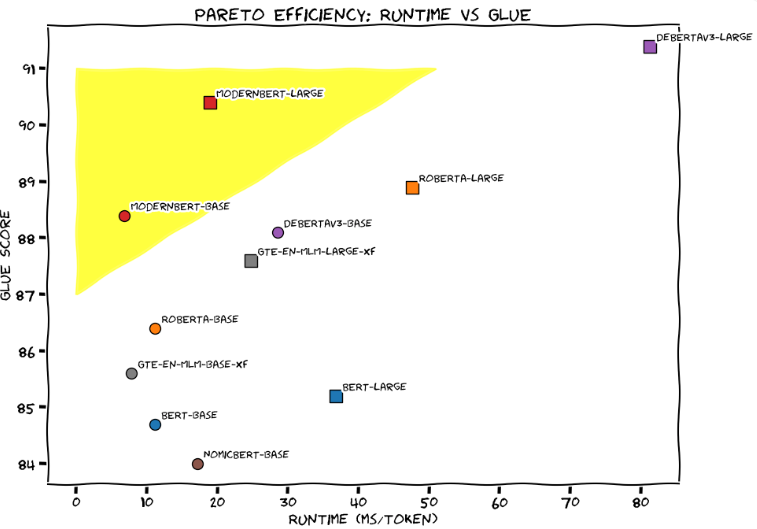

En la Evaluación de comprensión general del lenguaje (GLUE), ModernBERT-Large logró el mejor equilibrio entre velocidad de procesamiento y precisión, con un tiempo de procesamiento de aproximadamente 20 milisegundos por token y una puntuación de 90. El equipo de desarrollo comparó vívidamente ModernBERT con un Honda Civic sintonizado, enfatizando su confiabilidad y eficiencia en aplicaciones diarias.

En comparación con los modelos de lenguaje a gran escala existentes, como GPT-4, ModernBERT reduce significativamente el costo del procesamiento de texto a gran escala. GPT-4 cuesta unos centavos por consulta, mientras que ModernBERT se ejecuta localmente, es más rápido y económico. Por ejemplo, cuando el proyecto FineWeb Edu filtró 15 mil millones de etiquetas, el costo de usar el modelo BERT fue de 60.000 dólares estadounidenses, e incluso usar el decodificador Gemini Flash de Google, el costo fue de más de 1 millón de dólares estadounidenses.

El equipo de desarrollo dice que ModernBERT es muy adecuado para una variedad de aplicaciones prácticas, incluidos sistemas de generación aumentada de recuperación (RAG), búsqueda de código y revisión de contenido. A diferencia de GPT-4, que requiere hardware especializado, ModernBERT puede ejecutarse de manera efectiva en GPU de juegos de consumo comunes.

Actualmente, ModernBERT está disponible en dos versiones: el modelo base contiene 139 millones de parámetros y la versión grande contiene 395 millones de parámetros. Ambas versiones ahora se lanzan en Hugging Face y los usuarios pueden reemplazar directamente los modelos BERT existentes con ellas. El equipo de desarrollo planea lanzar una versión más grande el próximo año, pero no hay planes para capacidades multimodales. Para promover el desarrollo de nuevas aplicaciones, también están lanzando un concurso que otorgará $100 y una suscripción profesional de Hugging Face de seis meses a los cinco mejores presentadores.

Desde que Google lanzó BERT en 2018, el modelo ha sido uno de los modelos de lenguaje más populares, con más de 68 millones de descargas mensuales en HuggingFace.

Entrada del proyecto: https://huggingface.co/blog/modernbert

Destacar:

ModernBERT es cuatro veces más rápido que BERT y puede manejar texto de hasta 8192 tokens.

En comparación con GPT-4, el costo de ModernBERT en el procesamiento de textos a gran escala se reduce significativamente y su operación es más eficiente.

Este modelo es particularmente bueno en el procesamiento de código de programación, con una puntuación de más de 80 en el conjunto de datos de preguntas y respuestas de StackOverflow, estableciendo un nuevo récord.

En resumen, la versión de código abierto de ModernBERT ofrece a los desarrolladores una opción de modelo de lenguaje eficiente, económica y potente. Tiene importantes ventajas en cuanto a velocidad, eficiencia y capacidad para procesar textos largos, y se espera que promueva el desarrollo innovador de más aplicaciones de IA. . Esperamos futuras actualizaciones y aplicaciones más amplias.