El Instituto de Investigación Zhiyuan y Tencent lanzaron conjuntamente LongBench v2, una plataforma de prueba de referencia para evaluar la comprensión de textos largos y las capacidades de razonamiento de modelos de lenguaje grandes (LLM). LongBench v2 mejora significativamente la longitud del texto y la dificultad de la evaluación, incluidas 503 desafiantes preguntas de opción múltiple de cuatro opciones, lo que dificulta incluso para los expertos humanos obtener una alta precisión en poco tiempo. El punto de referencia cubre seis categorías de tareas principales e incluye mejoras en la metodología de evaluación para aumentar la confiabilidad y precisión de los resultados. Este movimiento tiene como objetivo promover el progreso de modelos de lenguaje grandes en el procesamiento de textos largos y proporcionar una herramienta de evaluación más efectiva para la investigación relacionada.

En una conferencia de prensa celebrada el 19 de diciembre de 2024, el Instituto de Investigación Zhiyuan y Tencent anunciaron el lanzamiento de LongBench v2, que está diseñado para evaluar la comprensión profunda y las capacidades de razonamiento de modelos de lenguaje grandes (LLM) en tareas múltiples de texto largo del mundo real. Puntos de referencia diseñados. La plataforma tiene como objetivo promover el progreso de los modelos de texto largo en la comprensión y el razonamiento, y responde a los desafíos actuales en la aplicación de modelos de texto largo y de lenguaje de gran tamaño.

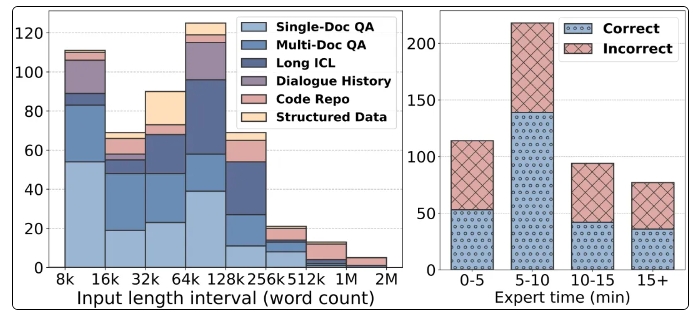

Las características notables de LongBench v2 incluyen soporte para longitudes de texto más largas, que van desde 8k hasta 2 millones de palabras, y contiene 503 desafiantes preguntas de opción múltiple de cuatro opciones con mayor dificultad, incluso la precisión promedio de los expertos humanos en 15 minutos. La tasa es solo del 53,7%. . Además, el punto de referencia cubre seis categorías de tareas principales, incluidas preguntas y respuestas de un solo documento, preguntas y respuestas de varios documentos, aprendizaje de contexto de texto largo, etc., lo que garantiza una amplia gama de escenarios de aplicación.

Para garantizar la confiabilidad de la evaluación, todas las preguntas en LongBench v2 tienen la forma de preguntas de opción múltiple y se someten a un estricto proceso de revisión y anotación manual. Durante el proceso de recopilación de datos, se reclutaron anotadores de las mejores universidades para garantizar la calidad y dificultad de las preguntas. Al introducir variables de control, LongBench v2 mejora el algoritmo estadístico Bradley-Terry original, reduciendo el impacto de los factores de confusión y haciendo que la clasificación del modelo sea más científica y precisa.

En términos de resultados de la evaluación, el equipo de investigación probó 10 LLM de código abierto y 6 LLM de código cerrado y descubrió que el rendimiento del modelo mejoró significativamente después de introducir variables de control. En particular, el modelo GPT-4o funciona bien en tareas como la respuesta a preguntas de varios documentos y el aprendizaje del contexto de textos largos después de introducir más pasos de razonamiento, lo que demuestra la importancia de las capacidades de razonamiento.

El lanzamiento de LongBench v2 no solo proporciona una nueva herramienta para la evaluación de modelos de lenguaje grandes, sino que también señala la dirección para futuras investigaciones, enfatizando la importancia de mejorar la comprensión y las capacidades de razonamiento del propio modelo. La cooperación entre el Instituto de Investigación Zhiyuan y Tencent marca un mayor desarrollo en el campo de la tecnología de inteligencia artificial. Se espera que esta prueba de referencia pueda promover el avance de la tecnología de razonamiento y comprensión de textos largos.

Página de inicio: https://longbench2.github.io

Documento: https://arxiv.org/abs/2412.15204

Datos y código: https://github.com/THUDM/LongBench

El lanzamiento de LongBench v2 marca una nueva etapa en la evaluación de modelos de lenguaje grandes. Sus estándares de evaluación más estrictos y su contenido de prueba más completo ayudarán a promover la mejora continua de los modelos de lenguaje grandes en la comprensión y las capacidades de razonamiento de textos largos. Esperamos que en el futuro aparezcan más resultados de investigación basados en LongBench v2 para promover aún más el desarrollo de la tecnología de IA.