Apple ha logrado recientemente un gran avance en la velocidad de generación de modelos de lenguaje grande (LLM). Ha cooperado con NVIDIA para utilizar la tecnología de código abierto Recurrent Drafter (ReDrafter) para casi triplicar la velocidad de generación. ReDrafter utiliza un método de decodificación especulativa para mejorar significativamente la eficiencia del entrenamiento del modelo y está integrado con el marco de aceleración de inferencia TensorRT-LLM de NVIDIA para reducir aún más los costos de uso y la latencia. Esta cooperación no solo mejora la eficiencia del desarrollo, sino que también brinda a los usuarios una experiencia de servicio más rápida, lo que marca la determinación y la fuerza de Apple para continuar innovando en el campo de la IA. Este artículo detallará los detalles de la cooperación entre Apple y NVIDIA y las ventajas de la tecnología ReDrafter.

Recientemente, la última investigación de Apple en el campo del aprendizaje automático muestra que a través de la cooperación con NVIDIA, han aumentado con éxito la velocidad de generación de modelos de lenguaje grandes (LLM) casi tres veces. La clave de este progreso radica en la tecnología de código abierto "Recurrent Drafter" (ReDrafter) de Apple, que utiliza un método de decodificación especulativa que puede mejorar significativamente la eficiencia del entrenamiento de modelos.

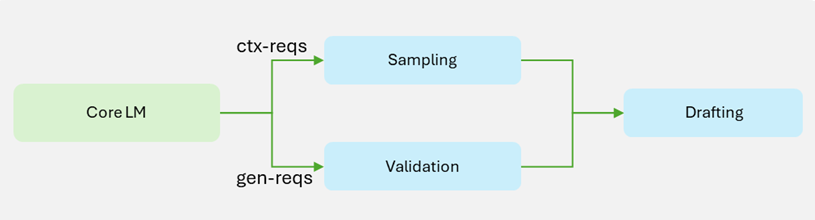

En el pasado, el proceso de creación de grandes modelos de lenguaje solía consumir mucho tiempo y recursos, y las empresas a menudo necesitaban comprar una gran cantidad de dispositivos de hardware, lo que aumentaba los costos operativos. A principios de 2024, Apple lanzó ReDrafter, una tecnología que combina redes neuronales recursivas y métodos dinámicos de atención de árboles para generar y verificar etiquetas rápidamente, aumentando la velocidad de generación de etiquetas 3,5 veces en comparación con los métodos tradicionales de regresión automática.

Esta semana, Apple anunció además que su cooperación con NVIDIA integrará ReDrafter en el marco de aceleración de inferencia TensorRT-LLM de NVIDIA. Este movimiento permitirá a los desarrolladores de aprendizaje automático que utilizan GPU NVIDIA aprovechar las capacidades de aceleración de ReDrafter en entornos de producción. Vale la pena mencionar que, aunque los servidores multi-GPU de alto rendimiento suelen ser costosos, esta cooperación puede reducir la latencia y al mismo tiempo reducir la cantidad de hardware requerido, lo que resulta en una solución más económica.

En las pruebas comparativas con NVIDIA, la eficiencia de generación con ReDrafter mejoró significativamente, con un aumento de 2,7 veces en la generación de tokens por segundo en el modo de codificación codiciosa. Esto significa que los desarrolladores pueden obtener más resultados en menos tiempo y brindar a los usuarios una experiencia de servicio más rápida.

Después de confirmar su cooperación con NVIDIA, Apple también declaró que están considerando utilizar el chip Trainium2 de Amazon para mejorar la eficiencia del entrenamiento de modelos. Se espera que la eficiencia del entrenamiento previo con Trainium2 mejore en un 50% en comparación con el hardware existente.

Blog oficial: https://developer.nvidia.com/blog/nvidia-tensorrt-llm-now-supports-recurrent-drafting-for-optimizing-llm-inference/

Reflejos:

Apple se asocia con NVIDIA para casi triplicar la velocidad de generación de modelos de lenguajes grandes.

La tecnología de código abierto ReDrafter se combina con redes neuronales recurrentes para mejorar significativamente la eficiencia del entrenamiento de modelos.

Esta colaboración ayuda a reducir costos y proporcionar soluciones más eficientes para los desarrolladores de aprendizaje automático.

Con todo, la cooperación entre Apple y NVIDIA y la aplicación de la tecnología ReDrafter han aportado importantes mejoras de eficiencia y reducciones de costes en el desarrollo y la aplicación de grandes modelos de lenguaje. Esto no solo promueve el progreso tecnológico en el campo de la inteligencia artificial, sino que también brinda soluciones más convenientes y económicas para desarrolladores y usuarios, lo que indica el vigoroso desarrollo de las aplicaciones de IA en el futuro.