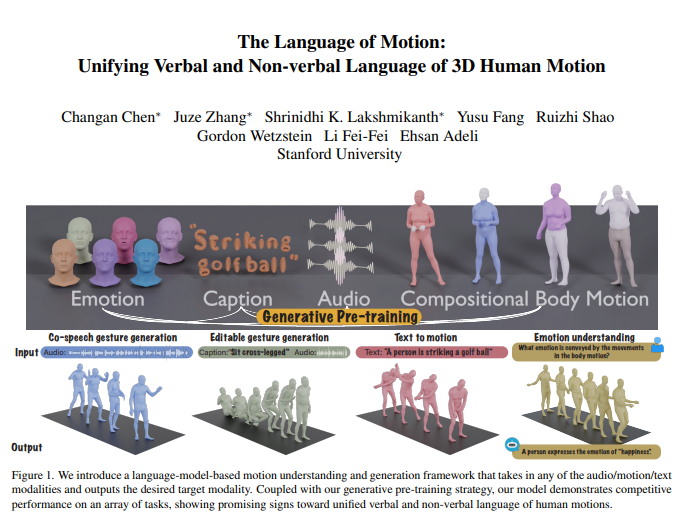

El equipo de Li Feifei publicó recientemente un resultado de investigación revolucionario: un nuevo modelo multimodal que puede comprender y generar acciones humanas y combina inteligentemente modelos de lenguaje para lograr un procesamiento unificado del lenguaje verbal y no verbal. Esta innovación no sólo permite a las máquinas comprender las instrucciones humanas, sino también interpretar las emociones detrás de las acciones, logrando así una interacción persona-computadora más natural y fluida. El núcleo del modelo radica en su marco de modelo de lenguaje multimodal, que puede integrar múltiples entradas como audio, movimiento y texto, y generar los datos modales correspondientes. Funciona bien en tareas como la generación colaborativa de gestos de voz, reduce significativamente la cantidad de datos necesarios para el entrenamiento del modelo y amplía nuevos escenarios de aplicación, como la generación de gestos editables y la predicción de emociones a través de acciones.

El equipo de Li Feifei lanzó un nuevo modelo multimodal que puede comprender y generar acciones humanas y, al combinar modelos de lenguaje, logra un procesamiento unificado del lenguaje verbal y no verbal. Esta innovadora investigación permite a las máquinas no sólo comprender las instrucciones humanas, sino también leer las emociones contenidas en las acciones, lo que permite una interacción más natural entre humanos y computadoras.

El núcleo del modelo radica en su marco de modelo de lenguaje multimodal, que puede recibir múltiples formas de entrada, como audio, movimiento y texto, y generar los datos modales requeridos. Combinado con una estrategia generativa de preentrenamiento, el modelo exhibe un rendimiento excelente en múltiples tareas. Por ejemplo, en la generación colaborativa de gestos de voz, el modelo no solo supera el estado del arte sino que también reduce significativamente la cantidad de datos necesarios para el entrenamiento. Además, el modelo también desbloquea nuevos escenarios de aplicación, como la generación de gestos editables y la predicción de emociones a través de acciones.

La comunicación humana es de naturaleza multimodal e incluye señales verbales y no verbales como el habla, las expresiones faciales y la postura corporal. La capacidad de este modelo para comprender estos comportamientos multimodales es fundamental para crear personajes virtuales que se comuniquen de forma natural en aplicaciones como juegos, películas y realidad virtual. Sin embargo, los modelos de generación de acciones existentes a menudo se limitan a modalidades de entrada específicas (voz, texto o datos de acción) y no logran explotar plenamente la diversidad de datos disponibles.

Este modelo utiliza modelos de lenguaje para unificar el lenguaje verbal y no verbal por tres razones principales:

Los modelos lingüísticos conectan naturalmente diferentes modalidades.

El habla es altamente semántica y tareas como modelar respuestas a chistes requieren fuertes capacidades de razonamiento semántico.

El modelo de lenguaje adquiere sólidas capacidades de comprensión semántica mediante un extenso entrenamiento previo.

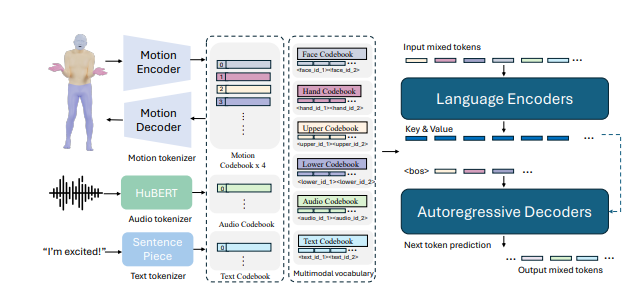

Para lograr esto, el equipo de investigación primero dividió el cuerpo en diferentes partes (cara, manos, parte superior e inferior del cuerpo) y etiquetó cada parte individualmente para el movimiento. Al combinar tokenizadores de texto y voz, la entrada en cualquier modalidad se puede representar como una serie de tokens para su uso en modelos de lenguaje. El modelo adopta un proceso de entrenamiento de dos etapas: primero un entrenamiento previo para lograr la alineación de varias modalidades con movimientos corporales combinados, así como la alineación de audio y texto. Luego, las tareas posteriores se convierten en instrucciones y el modelo se entrena con estas instrucciones para que pueda seguir varias instrucciones de tareas.

El modelo tuvo un buen desempeño en el punto de referencia de generación de gestos de voz colaborativa BEATv2, superando con creces a los modelos existentes. También se ha verificado el efecto de la estrategia de preformación, especialmente cuando los datos son escasos, lo que demuestra una fuerte capacidad de generalización. Al realizar un entrenamiento posterior en tareas de acción de habla y acción de texto, el modelo no solo puede seguir indicaciones de audio y texto, sino también lograr nuevas funciones, como predecir emociones a partir de datos de acción.

En detalles técnicos, el modelo emplea tokenizadores específicos de modalidad para manejar varias modalidades de entrada. Específicamente, el modelo entrena un movimiento corporal combinado VQ-VAE que convierte los movimientos faciales, de las manos, de la parte superior e inferior del cuerpo en marcadores discretos. Estos vocabularios específicos de modalidad (audio y texto) se combinan en un vocabulario multimodal unificado. Durante el entrenamiento, se utilizan tokens mixtos de diferentes modalidades como entrada y la salida se genera mediante un modelo de lenguaje codificador-decodificador.

El modelo también utiliza un vocabulario multimodal para convertir diferentes datos modales en un formato unificado para su procesamiento. En la etapa de preentrenamiento, el modelo aprende la correspondencia entre diferentes modalidades realizando tareas de conversión entre modalidades. Por ejemplo, un modelo puede aprender a traducir los movimientos de la parte superior del cuerpo en movimientos de la parte inferior del cuerpo o convertir audio en texto. Además, el modelo aprende la evolución temporal de las acciones enmascarando aleatoriamente ciertos marcos de acción.

En la fase posterior al entrenamiento, el modelo se ajusta utilizando datos emparejados para realizar tareas posteriores, como la generación colaborativa de gestos de voz o la generación de texto a acción. Para permitir que el modelo siga instrucciones humanas naturales, los investigadores crearon una plantilla de seguimiento de instrucciones multitarea que convierte tareas como audio en acción, texto en acción y emoción en acción en instrucciones. El modelo también tiene la capacidad de editar gestos para generar movimientos coordinados de todo el cuerpo basados en texto y señales de audio.

Finalmente, el modelo también desbloquea nuevas capacidades para predecir emociones a partir de acciones. Esto tiene implicaciones importantes para campos como la salud mental o la psiquiatría. Este modelo es capaz de predecir con mayor precisión las emociones expresadas en acciones que otros modelos, mostrando fuertes capacidades de comprensión del lenguaje corporal.

La investigación muestra que unificar el lenguaje verbal y no verbal de las acciones humanas es fundamental para las aplicaciones prácticas, y los modelos de lenguaje proporcionan un marco poderoso para ello.

Dirección del artículo: https://arxiv.org/pdf/2412.10523v1

En definitiva, esta investigación ha aportado avances significativos al campo de la inteligencia artificial multimodal. Su potencial de aplicación en la interacción persona-computadora, la creación de personajes virtuales y el reconocimiento de emociones es enorme y merece más atención e investigación. En el futuro, se espera que este modelo desempeñe un papel en más campos y promueva el desarrollo de la tecnología de inteligencia artificial.