NVIDIA lanzó rápidamente las GPU GB300 y B300, logrando importantes mejoras de rendimiento apenas medio año después del lanzamiento de GB200 y B200, especialmente en los modelos de inferencia. Esto no es solo una simple actualización de hardware, sino que también representa el ajuste de diseño estratégico de NVIDIA en el campo de la aceleración de IA, que tendrá un profundo impacto en la industria. El núcleo de esta actualización radica en un gran salto en el rendimiento de inferencia, así como en la optimización de la memoria y la arquitectura, lo que afectará directamente la eficiencia y el costo de los modelos de lenguaje grandes.

Sólo 6 meses después del lanzamiento de GB200 y B200, Nvidia volvió a lanzar nuevas GPU: GB300 y B300. Esto puede parecer una pequeña mejora, pero en realidad contiene grandes cambios, especialmente una mejora significativa en el rendimiento del modelo de inferencia, que tendrá un profundo impacto en toda la industria.

B300/GB300: un gran salto en el rendimiento de inferencia

B300GPU utiliza el nodo de proceso 4NP de TSMC y está optimizado para chips informáticos. Esto hace que el rendimiento FLOPS del B300 sea un 50% mayor que el del B200. Parte de la mejora del rendimiento proviene del aumento del TDP. El TDP de GB300 y B300HGX alcanza 1,4 KW y 1,2 KW respectivamente (GB200 y B200 son 1,2 KW y 1 KW respectivamente). Las ganancias de rendimiento restantes provienen de mejoras arquitectónicas y optimizaciones a nivel de sistema, como la asignación dinámica de energía entre la CPU y la GPU.

Además del aumento de FLOPS, la memoria también se actualizó a 12-Hi HBM3E y la capacidad HBM de cada GPU se incrementó a 288 GB. Sin embargo, la velocidad del pin permanece sin cambios, por lo que el ancho de banda de la memoria por GPU sigue siendo de 8 TB/s. Vale la pena señalar que Samsung no logró ingresar a la cadena de suministro de GB200 o GB300.

Además, Nvidia también ha realizado ajustes en los precios. Esto afectará hasta cierto punto el margen de beneficio de los productos Blackwell, pero lo más importante es que la mejora del rendimiento del B300/GB300 se reflejará principalmente en el modelo de inferencia.

Diseñado para modelos de inferencia

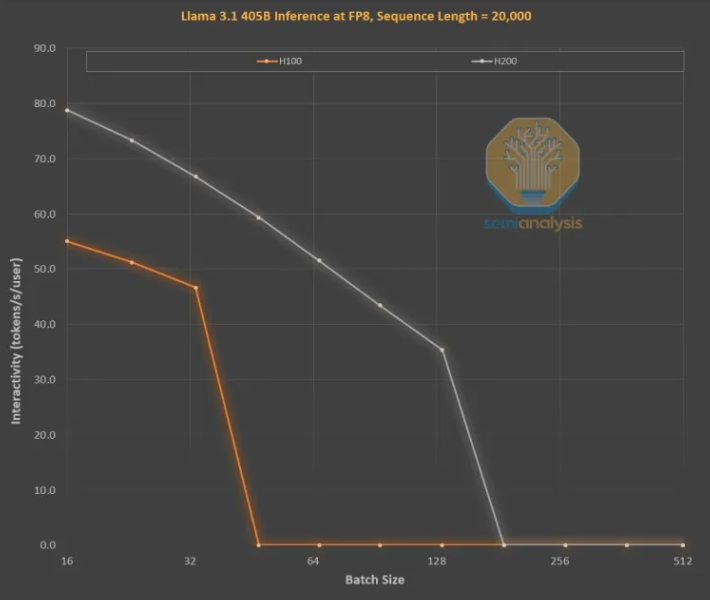

Las mejoras en la memoria son fundamentales para el entrenamiento de inferencia LLM estilo OpenAI O3, ya que las secuencias largas aumentan KVCache, lo que limita el tamaño de lote crítico y la latencia. La actualización de H100 a H200 (principalmente el aumento de memoria) ha traído mejoras en los dos aspectos siguientes:

Un mayor ancho de banda de memoria (4,8 TB/s en el H200 y 3,35 TB/s en el H100) dio como resultado una mejora general del 43 % en la interactividad en todos los tamaños de lote comparables.

Dado que el H200 ejecuta un tamaño de lote mayor que el H100, la cantidad de tokens generados por segundo aumenta 3 veces y el costo se reduce aproximadamente 3 veces. Esta diferencia se debe principalmente a que KVCache limita el tamaño total del lote.

La mejora del rendimiento derivada de una mayor capacidad de memoria es enorme. Las diferencias económicas y de rendimiento entre las dos GPU son mucho mayores de lo que sugieren sus especificaciones:

La experiencia del usuario con los modelos de inferencia puede ser deficiente porque existe una latencia significativa entre las solicitudes y las respuestas. Si el tiempo de inferencia se puede acelerar significativamente, aumentará la disposición de los usuarios a usar y pagar.

La mejora de 3 veces en el rendimiento del hardware gracias a las actualizaciones de memoria de generación media es asombrosa y mucho más rápida que la Ley de Moore, la Ley de Huang o cualquier otra mejora de hardware que hayamos visto.

Con todo, el lanzamiento de NVIDIA B300/GB300 no es solo otro salto en la tecnología de GPU, sino también una fuerte promoción de la aplicación de modelos de inferencia de IA. Mejorará en gran medida la experiencia del usuario y reducirá los costos, lo que llevará a la industria de la IA a avanzar. entrar en una nueva etapa de desarrollo.