Entrenar grandes modelos de IA es costoso y sus enormes necesidades de recursos limitan su aplicación generalizada y plantean preocupaciones sobre la eficiencia energética y el impacto ambiental. Los métodos de formación tradicionales son ineficientes, se basan en matrices densas y requieren grandes cantidades de memoria y potencia informática. Aunque algunos métodos existentes intentan aliviar estos problemas, todavía tienen limitaciones en las aplicaciones prácticas. Por lo tanto, es crucial desarrollar un enfoque que pueda reducir simultáneamente el uso de memoria, el costo computacional y el tiempo de entrenamiento sin comprometer el rendimiento.

El entrenamiento de modelos de IA a gran escala (como Transformers y modelos de lenguaje) se ha convertido en un vínculo clave indispensable en el campo de la IA, pero también enfrenta altos costos de computación, consumo de memoria y requisitos de energía. Por ejemplo, GPT-3 de OpenAI tiene 175 mil millones de parámetros y requiere semanas de entrenamiento de GPU. Este enorme requisito de recursos limita la aplicación de esta tecnología a organizaciones de gran escala con abundantes recursos informáticos, al tiempo que exacerba las preocupaciones sobre la eficiencia energética y el impacto ambiental. Abordar estos desafíos es fundamental para garantizar una mayor accesibilidad y sostenibilidad del desarrollo de la IA.

Los métodos de formación tradicionales son ineficientes y se necesitan urgentemente soluciones innovadoras

Marco CoMERA: entrenamiento eficiente a través de la optimización adaptativa del tensor

La base de CoMERA es una representación tensorial adaptativa, que permite que las capas del modelo ajusten dinámicamente sus rangos en función de las limitaciones de recursos. Al modificar el rango del tensor, el marco permite la compresión sin comprometer la integridad operativa de la red neuronal. Esta optimización dinámica se logra mediante un proceso de formación en dos etapas:

Primeras etapas: centrarse en la convergencia estable.

Etapas posteriores: ajuste del rango para cumplir objetivos de compresión específicos.

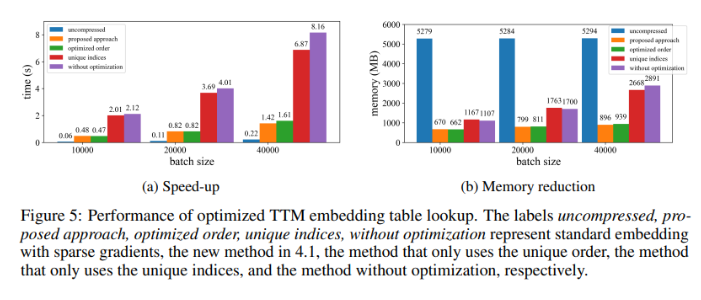

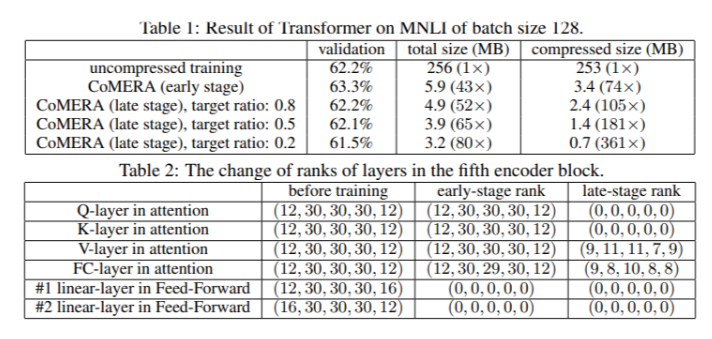

En un modelo Transformer de seis codificadores, CoMERA logró una relación de compresión de hasta 43x en sus primeras etapas, y una relación de compresión aún mayor de 361x en sus etapas posteriores de optimización. Además, reduce el consumo de memoria 9 veces y acelera el entrenamiento entre 2 y 3 veces por ronda en comparación con GaLore.

Múltiples resultados de pruebas muestran que CoMERA tiene un rendimiento excelente

Cuando se aplica a un modelo Transformer entrenado en el conjunto de datos MNLI, CoMERA reduce el tamaño del modelo de 256 MB a tan solo 3,2 MB manteniendo la precisión. En sistemas de recomendación a gran escala como DLRM, CoMERA comprime los modelos 99 veces y reduce el uso máximo de memoria 7 veces. El marco también funcionó bien en el entrenamiento previo de CodeBERT, un modelo de lenguaje a gran escala de dominio específico, logrando una relación de compresión general de 4,23x y logrando una aceleración de 2x en algunas etapas de entrenamiento. Estos resultados resaltan su capacidad para manejar una variedad de tareas y arquitecturas, ampliando su aplicabilidad en diversos campos.

Resumen de los beneficios clave del marco CoMERA

Las principales conclusiones de este estudio son las siguientes:

CoMERA logra relaciones de compresión de hasta 361x para capas específicas y 99x para todo el modelo, lo que reduce significativamente los requisitos de almacenamiento y memoria.

Este marco acorta el tiempo de capacitación de cada ronda de Transformer y sistemas de recomendación entre 2 y 3 veces, lo que ahorra tiempo y recursos informáticos.

Al utilizar representaciones tensorizadas y gráficos CUDA, CoMERA reduce el consumo máximo de memoria 7 veces, lo que hace posible el entrenamiento en GPU más pequeñas.

El enfoque de CoMERA admite múltiples arquitecturas, incluidos Transformers y modelos de lenguaje grandes, al tiempo que mantiene o mejora la precisión.

Al reducir la energía y los recursos necesarios para la formación, CoMERA ayuda a permitir prácticas de IA más sostenibles y pone a disposición de un público más amplio modelos de vanguardia.

En definitiva, el marco CoMERA proporciona una solución innovadora para entrenar de manera eficiente grandes modelos de IA, lo que reduce significativamente los costos computacionales y los requisitos de memoria a través de la optimización adaptativa del tensor mientras se mantiene la precisión del modelo. Esta investigación hace una contribución importante al desarrollo continuo y a una accesibilidad más amplia del campo de la IA.