El equipo de Qwen ha abierto su último modelo de razonamiento multimodal QVQ, que se basa en Qwen2-VL-72B y mejora significativamente la comprensión visual y las capacidades de razonamiento de la IA. QVQ logró una puntuación alta de 70,3 en la revisión MMMU y superó a su modelo predecesor en múltiples puntos de referencia matemáticos. Este artículo presentará en detalle las características, ventajas, limitaciones y uso del modelo QVQ, y proporcionará enlaces relevantes para facilitar que los lectores lo comprendan y utilicen mejor.

El equipo de Qwen anunció recientemente el código abierto de su último modelo de razonamiento multimodal QVQ, lo que marca un paso importante en la comprensión visual y las capacidades complejas de resolución de problemas de la inteligencia artificial. Este modelo se basa en Qwen2-VL-72B y tiene como objetivo mejorar las capacidades de razonamiento de la IA combinando lenguaje e información visual. En la evaluación MMMU, QVQ logró una puntuación alta de 70,3 y mostró mejoras de rendimiento significativas en comparación con Qwen2-VL-72B-Instruct en múltiples pruebas de referencia relacionadas con las matemáticas.

El modelo QVQ ha mostrado ventajas particulares en tareas de razonamiento visual, especialmente en áreas que requieren un pensamiento analítico complejo. A pesar del excelente rendimiento de QVQ-72B-Preview, el equipo también señaló algunas limitaciones del modelo, incluidos problemas de mezcla de idiomas y cambio de código, la posibilidad de caer en patrones lógicos circulares, consideraciones éticas y de seguridad, y limitaciones de rendimiento y puntos de referencia. El equipo enfatizó que aunque el modelo ha mejorado en el razonamiento visual, no puede reemplazar completamente la capacidad de Qwen2-VL-72B. Durante el proceso de razonamiento visual de varios pasos, el modelo puede perder gradualmente el enfoque en el contenido de la imagen, lo que provoca alucinaciones.

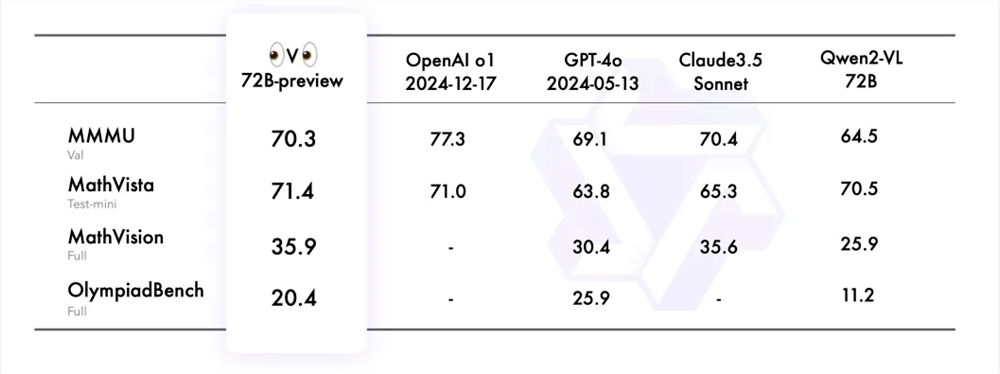

El equipo de Qwen evaluó QVQ-72B-Preview en cuatro conjuntos de datos, incluidos MMMU, MathVista, MathVision y OlympiadBench. Estos conjuntos de datos están diseñados para examinar la comprensión integral y las capacidades de razonamiento del modelo relacionadas con la visión. El QVQ-72B-Preview tuvo un buen desempeño en estos puntos de referencia, cerrando efectivamente la brecha con el modelo líder.

Para demostrar aún más la aplicación del modelo QVQ en tareas de razonamiento visual, el equipo de Qwen proporcionó varios ejemplos y compartió un enlace al blog técnico. Además, el equipo también proporcionó ejemplos de código para la inferencia de modelos y cómo utilizar Magic API-Inference para llamar directamente al modelo QVQ-72B-Preview. La API-Inference de Magic Platform brinda soporte para el modelo QVQ-72B-Preview, y los usuarios pueden usar el modelo directamente a través de llamadas API.

Enlace del modelo:

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

Enlace de experiencia:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

blog chino:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

El código abierto del modelo QVQ proporciona recursos valiosos para la investigación de inteligencia artificial multimodal y también presagia un mayor desarrollo de la IA en el campo del razonamiento visual en el futuro. Aunque existen algunas limitaciones, su excelente rendimiento en muchas pruebas comparativas sigue siendo impresionante. Esperamos seguir optimizando y mejorando el modelo QVQ en el futuro.