Magic Square Quantitative lanzó recientemente una nueva generación de modelo grande DeepSeek-V3. Su escala de 671 mil millones de parámetros y su arquitectura MoE hacen que su rendimiento sea comparable al de los mejores modelos de código cerrado. También tiene las características de bajo costo y alta eficiencia, lo que ha atraído una gran popularidad. atención en la industria. DeepSeek-V3 ha obtenido buenos resultados en muchas pruebas, superando especialmente a todos los modelos existentes en la prueba de capacidad matemática, y proporciona servicios API a un precio significativamente más bajo que modelos como GPT-4, proporcionando a los desarrolladores y empresas una solución de IA rentable. Este artículo analizará en detalle el rendimiento, el costo y la estrategia de comercialización de DeepSeek-V3 y discutirá su impacto en la industria de la IA.

Magic Square Quantitative lanzó una nueva generación del modelo grande DeepSeek-V3 la noche del 26 de diciembre, mostrando un avance tecnológico sorprendente. Este modelo que utiliza la arquitectura MoE (Mixed Experts) no solo es comparable en rendimiento a los mejores modelos de código cerrado, sino que sus características de bajo costo y alta eficiencia han atraído la atención de la industria.

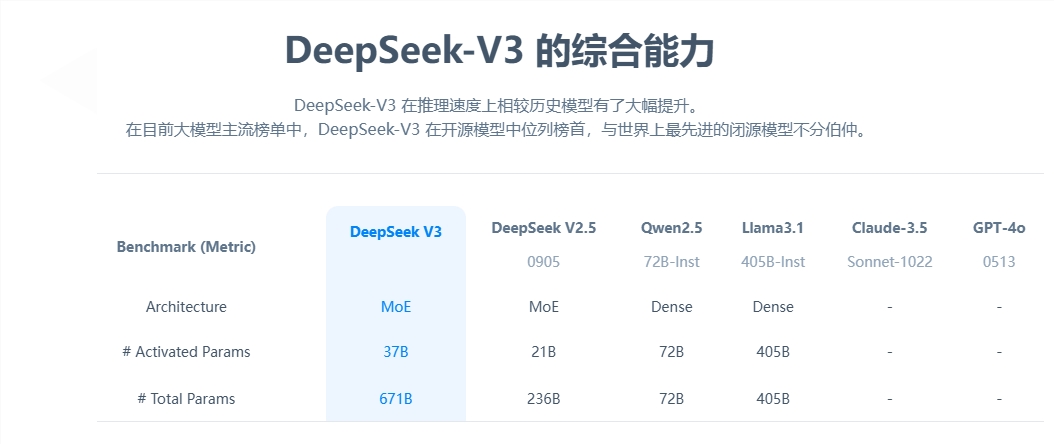

Desde la perspectiva de los parámetros centrales, DeepSeek-V3 tiene 671 mil millones de parámetros, de los cuales 37 mil millones son parámetros de activación, y ha completado el entrenamiento previo en una escala de datos de 14,8 billones de tokens. En comparación con el producto de la generación anterior, la velocidad de generación del nuevo modelo se ha incrementado 3 veces y puede procesar 60 tokens por segundo, lo que mejora significativamente la eficiencia de las aplicaciones prácticas.

En términos de evaluación del rendimiento, DeepSeek-V3 muestra una solidez excelente. No sólo supera a modelos de código abierto conocidos como Qwen2.5-72B y Llama-3.1-405B, sino que también está a la par con GPT-4 y Claude-3.5-Sonnet en múltiples pruebas. Especialmente en la prueba de capacidad matemática, el modelo superó a todos los modelos de código abierto y cerrado existentes con excelentes resultados.

Lo más sorprendente es la ventaja de bajo costo de DeepSeek-V3. Según artículos de código abierto, calculado en 2 dólares estadounidenses por hora de GPU, el coste total de formación del modelo es de sólo 5,576 millones de dólares. Este resultado revolucionario se debe a la optimización colaborativa de algoritmos, marcos y hardware. El cofundador de OpenAI, Karpathy, elogió esto y señaló que DeepSeek-V3 logró un rendimiento que superó a Llama3 en solo 2,8 millones de horas de GPU y que la eficiencia informática aumentó aproximadamente 11 veces.

En términos de comercialización, aunque el precio del servicio API de DeepSeek-V3 ha aumentado en comparación con la generación anterior, todavía mantiene un alto rendimiento de costos. La nueva versión tiene un precio de 0,5 a 2 yuanes por millón de tokens de entrada y 8 yuanes por millón de tokens de salida, con un costo total de aproximadamente 10 yuanes. En comparación, el precio del servicio equivalente de GPT-4 es de unos 140 yuanes y la diferencia de precios es significativa.

Como gran modelo integral de código abierto, el lanzamiento de DeepSeek-V3 no solo demuestra el progreso de la tecnología de IA de China, sino que también proporciona a los desarrolladores y empresas una solución de IA de alto rendimiento y bajo costo.

La aparición de DeepSeek-V3 marca un gran avance en la tecnología de inteligencia artificial de China en el campo de los modelos de lenguaje a gran escala. Sus ventajas de bajo costo y alto rendimiento la hacen altamente competitiva en aplicaciones comerciales, y vale la pena esperar su desarrollo futuro. . El código abierto de este modelo también aporta recursos valiosos a la comunidad global de IA y promueve el intercambio y el desarrollo de la tecnología de IA.