La plataforma abierta Kimi está a punto de lanzar la muy esperada prueba interna de la función Context Caching. Esta tecnología innovadora mejorará significativamente la experiencia del usuario de modelos de texto largos. Al almacenar en caché el contenido de tokens duplicados, Context Caching puede reducir significativamente el costo de los usuarios que solicitan el mismo contenido y mejorar en gran medida la velocidad de respuesta de la interfaz API. Esto es particularmente importante para escenarios de aplicaciones que requieren solicitudes frecuentes y referencias repetidas a una gran cantidad de contextos iniciales, como escenarios de avisos a gran escala y altamente repetitivos.

Noticias de ChinaZ.com el 20 de junio: Kimi Open Platform anunció recientemente que la tan esperada función Context Caching pronto lanzará pruebas internas. Esta característica innovadora admitirá grandes modelos de texto largo y brindará a los usuarios una experiencia sin precedentes a través de un mecanismo eficiente de almacenamiento en caché de contexto.

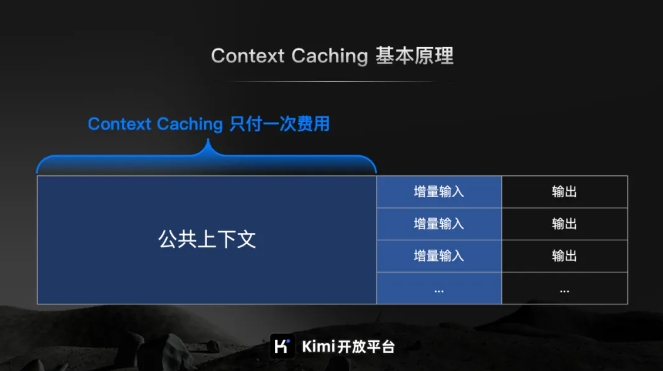

Según la introducción oficial de Kimi Open Platform, Context Caching es una tecnología de vanguardia diseñada para reducir significativamente el costo de los usuarios que solicitan el mismo contenido al almacenar en caché contenido de Tokens duplicados. Su principio de funcionamiento es identificar y almacenar de forma inteligente fragmentos de texto procesados. Cuando el usuario vuelve a solicitarlo, el sistema puede recuperarlo rápidamente del caché, mejorando así en gran medida la velocidad de respuesta de la interfaz API.

Para escenarios de avisos a gran escala y altamente repetitivos, las ventajas de la función Context Caching son particularmente significativas. Puede responder rápidamente a una gran cantidad de solicitudes frecuentes y mejorar significativamente la eficiencia del procesamiento al tiempo que reduce los costos al reutilizar el contenido almacenado en caché.

Vale la pena mencionar especialmente que la función Context Caching es particularmente adecuada para escenarios de aplicaciones que requieren solicitudes frecuentes y referencias repetidas a una gran cantidad de contextos iniciales. A través de esta característica, los usuarios pueden implementar fácilmente un almacenamiento en caché de contexto eficiente, mejorando así la eficiencia del trabajo y reduciendo los costos operativos.

Las pruebas internas de la función Context Caching están a punto de comenzar, lo que marca un paso importante dado por la plataforma abierta Kimi para mejorar la eficiencia de los modelos grandes y reducir los costos para los usuarios. El futuro es prometedor.