Equipos de investigación de instituciones como la Universidad China de Hong Kong y la Academia de Ciencias de China lanzaron recientemente un paradigma de preentrenamiento modal completo llamado MiCo, que ha logrado avances revolucionarios en el campo del aprendizaje multimodal y ha actualizado 37 estados de Registros de rendimiento de última generación (SOTA). MiCo tiene como objetivo construir inteligencia totalmente modal que pueda comprender cualquier modalidad y aprender representaciones universales, y simula el proceso cognitivo multimodal del cerebro humano mediante la introducción de más modalidades, volúmenes de datos y parámetros del modelo. El núcleo es dividir diferentes modos en "modo de conocimiento" y "modo de interfaz", y diseñar una arquitectura de aprendizaje modal completa correspondiente, utilizando un contexto multimodal para fortalecer el refuerzo mutuo entre modalidades y construir relaciones contextuales intermodales. El resultado de esta investigación proporciona nuevas direcciones e ideas para el desarrollo del campo de la inteligencia artificial.

Noticias de ChinaZ.com el 17 de junio: Un equipo de investigación de la Universidad China de Hong Kong, la Academia de Ciencias de China y otras instituciones propusieron un paradigma de preentrenamiento modal completo llamado MiCo (Contexto multimodal). Este método tiene resultados notables. Se ha logrado en el campo del aprendizaje multimodal, estableciendo 37 récords de rendimiento de última generación (SOTA).

Características principales:

Comprensión modal completa: MiCo tiene como objetivo construir inteligencia modal completa que pueda comprender cualquier modalidad y aprender representaciones universales.

Preentrenamiento a gran escala: al introducir más modalidades, volúmenes de datos y parámetros del modelo, MiCo simula el proceso cognitivo multimodal del cerebro humano durante el proceso de preentrenamiento.

Diseño de estructura de red neuronal: MiCo divide diferentes modos en "modo de conocimiento" y "modo de interfaz" y diseña una arquitectura de aprendizaje totalmente modal correspondiente, que se alinea mediante métodos de razonamiento generativo.

Contexto multimodal y ley de escala: MiCo utiliza el contexto multimodal para fortalecer el refuerzo mutuo entre modalidades y construir relaciones de contexto intermodal.

Los resultados experimentales muestran:

En la prueba comparativa de percepción unimodal de 10 modos diferentes, MiCo logró 7 resultados SOTA.

En 25 tareas de comprensión intermodal, incluida recuperación, preguntas y respuestas, descripción, etc., MiCo logró 20 resultados SOTA.

En 18 pruebas comparativas de modelos de lenguaje multimodal a gran escala, MiCo logró un total de 10 resultados SOTA.

El método de preentrenamiento de MiCo:

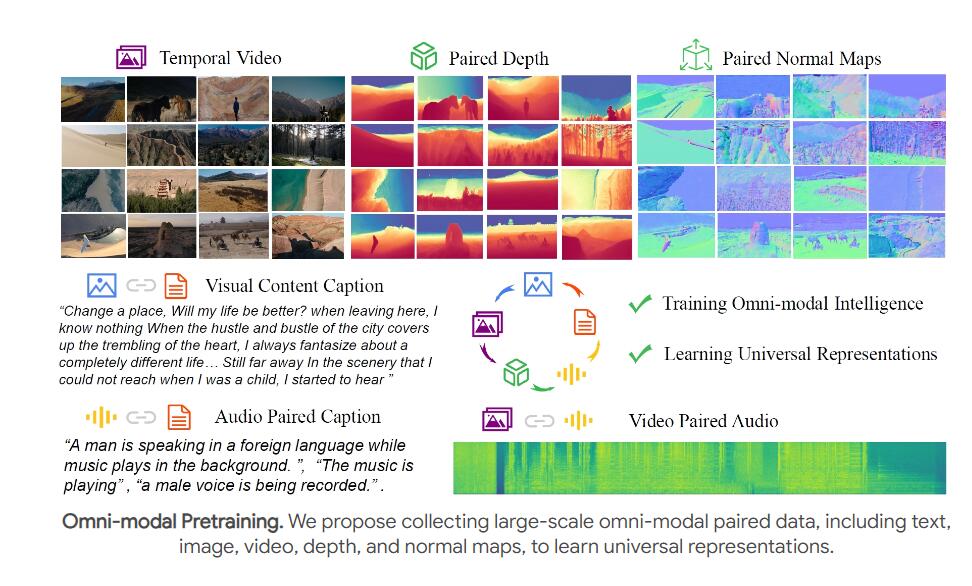

El equipo utilizó vídeos y audio emparejado, descripciones de texto, profundidad y normales para un preentrenamiento conjunto para simular las capacidades de percepción visual, auditiva y espacio-temporal del cerebro humano.

Las relaciones de contexto multimodal se construyen extrayendo características multimodales utilizando un codificador totalmente modal (como ViT) y extrayendo características de texto utilizando un codificador de texto.

Conclusión y trabajo futuro:

El proyecto MiCo es un importante intento de la inteligencia artificial para simular la cognición multimodal del cerebro humano. El equipo espera que inspire investigaciones futuras y desarrolle modelos básicos totalmente modales más potentes.

Los planes de trabajo futuros incluyen combinar más modalidades, como flujo óptico, datos IMU y archivos de eventos, para continuar mejorando la capacitación previa conjunta modal completa.

El excelente desempeño de MiCo ha establecido un nuevo punto de referencia en el campo del aprendizaje multimodal. Su potencial de desarrollo futuro es enorme y merece atención continua. También vale la pena esperar con ansias la futura dirección de investigación del equipo, y creo que MiCo continuará promoviendo el avance de la tecnología de inteligencia artificial.