El efecto de aplicación práctica de los modelos de lenguaje generativo a menudo está limitado por la estrategia de decodificación en la etapa de inferencia. Los métodos existentes, como RLHF, se centran principalmente en la tasa de ganancia del modelo e ignoran el impacto de las estrategias de decodificación en el rendimiento del modelo, lo que resulta en una baja eficiencia y dificultad para garantizar la calidad de la salida. Para resolver este problema, Google DeepMind y el equipo de investigación de Google propusieron el marco InfAlign, cuyo objetivo es combinar la estrategia de inferencia con el proceso de alineación del modelo para mejorar el rendimiento de la inferencia y la confiabilidad del modelo.

Los modelos de lenguaje generativo enfrentan muchos desafíos en el proceso desde la capacitación hasta las aplicaciones prácticas. Una de las principales cuestiones es cómo lograr un rendimiento óptimo del modelo durante la fase de inferencia.

Las contramedidas actuales, como el aprendizaje reforzado mediante retroalimentación humana (RLHF), se centran principalmente en mejorar la tasa de éxito del modelo, pero a menudo ignoran las estrategias de decodificación durante la inferencia, como el muestreo Best-of-N y la decodificación controlada. Esta brecha entre los objetivos de capacitación y el uso real puede generar ineficiencias y afectar la calidad y confiabilidad del resultado.

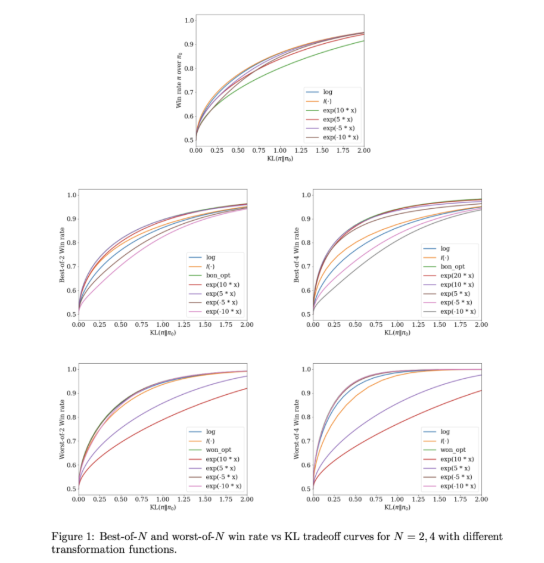

Para abordar estos problemas, Google DeepMind y el equipo de investigación de Google desarrollaron InfAlign, un marco de aprendizaje automático diseñado para combinarse con estrategias de inferencia. InfAlign incorpora métodos de tiempo de inferencia en el proceso de alineación y se esfuerza por cerrar la brecha entre la capacitación y la aplicación. Adopta un método de aprendizaje por refuerzo calibrado para ajustar la función de recompensa en función de una estrategia de inferencia específica. InfAlign es particularmente eficaz con técnicas como el muestreo Best-of-N (que genera múltiples respuestas y selecciona la mejor) y Worst-of-N (comúnmente utilizado en evaluaciones de seguridad), lo que garantiza que el modelo alineado funcione tanto en entornos controlados como en entornos reales. -Escenarios mundiales buenos.

El núcleo de InfAlign es el algoritmo de aprendizaje por refuerzo de calibración y transformación (CTRL), que sigue tres pasos: calibrar puntuaciones de recompensa, transformar estas puntuaciones de acuerdo con la estrategia de inferencia y resolver un problema de optimización regularizado de KL. InfAlign alinea los objetivos de entrenamiento con los requisitos de inferencia adaptando las transformaciones de recompensas a escenarios específicos. Este método no sólo mejora la tasa de ganancia durante la inferencia, sino que también mantiene la eficiencia computacional. Además, InfAlign mejora la solidez del modelo, permitiéndole hacer frente de manera efectiva a varias estrategias de decodificación y producir resultados consistentes de alta calidad.

La eficacia de InfAlign se verifica en experimentos que utilizan conjuntos de datos de utilidad e inocuidad de Anthropic. En comparación con los métodos existentes, InfAlign mejora la tasa de obtención de inferencias entre un 8% y un 12% en el muestreo Mejor de N y entre un 4% y un 9% en la evaluación de seguridad Peor de N. Estas mejoras se deben a su transformación de recompensa calibrada, que resuelve eficazmente el problema de mala calibración del modelo de recompensa y garantiza un rendimiento consistente en diferentes escenarios de inferencia.

InfAlign representa un avance importante en el alineamiento de modelos de lenguaje generativo. Al incorporar estrategias conscientes de la inferencia, InfAlign aborda la diferencia crítica entre capacitación e implementación. Su sólida base teórica y sus resultados empíricos resaltan su potencial para mejorar integralmente la alineación del sistema de IA.

Enlace: https://arxiv.org/abs/2412.19792

Reflejos:

InfAlign es un nuevo marco desarrollado por Google DeepMind, cuyo objetivo es mejorar el rendimiento de los modelos de lenguaje en la etapa de inferencia.

Este marco ajusta la función de recompensa de la estrategia de inferencia a través de métodos calibrados de aprendizaje por refuerzo para lograr la alineación entre los objetivos de entrenamiento y los requisitos de inferencia.

Los resultados experimentales muestran que InfAlign mejora significativamente la tasa de ganancia de inferencia del modelo en múltiples tareas, lo que demuestra buena adaptabilidad y confiabilidad.

La aparición del marco InfAlign proporciona nuevas ideas para resolver los problemas de eficiencia y calidad de los modelos de lenguaje generativo en la fase de inferencia. Su contribución a la mejora de la robustez y confiabilidad del modelo merece atención. Las investigaciones futuras pueden explorar más a fondo la aplicación de InfAlign en diferentes modelos y tareas para promover el desarrollo continuo de la tecnología de IA generativa.