Un artículo sobre la evaluación de la IA médica reveló inesperadamente los tamaños de los parámetros de varios de los principales modelos de lenguajes grandes, lo que provocó una preocupación generalizada en la industria. Este documento publicado por Microsoft toma la prueba de referencia de campo médico MEDEC como núcleo y estima los parámetros del modelo de OpenAI, Anthropic y otras compañías, incluidos modelos como la serie GPT-4 de OpenAI y Claude 3.5 Sonnet de Anthropic. Existen diferencias entre las escalas de parámetros mencionadas en el documento y la información pública. Por ejemplo, la escala de parámetros de GPT-4 es muy diferente de los datos anunciados anteriormente por NVIDIA, lo que ha provocado una acalorada discusión en la industria sobre la arquitectura y la técnica del modelo. fuerza, y una vez más desencadenó la preocupación de la gente sobre los modelos de IA. Pensamientos sobre la confidencialidad de los parámetros.

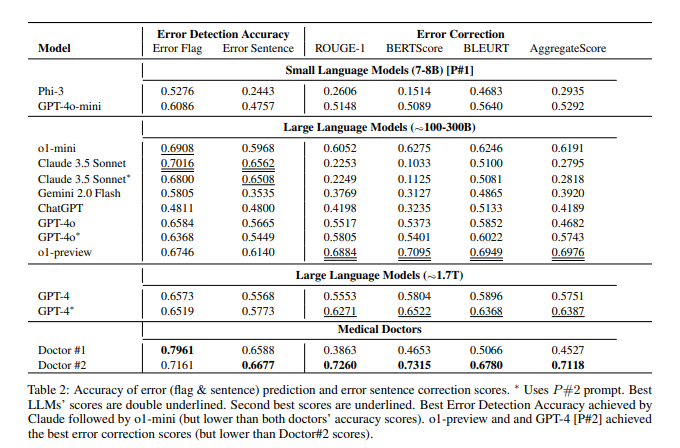

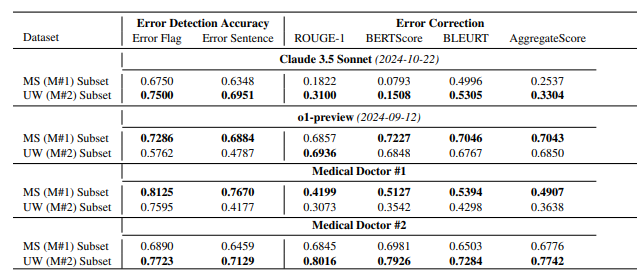

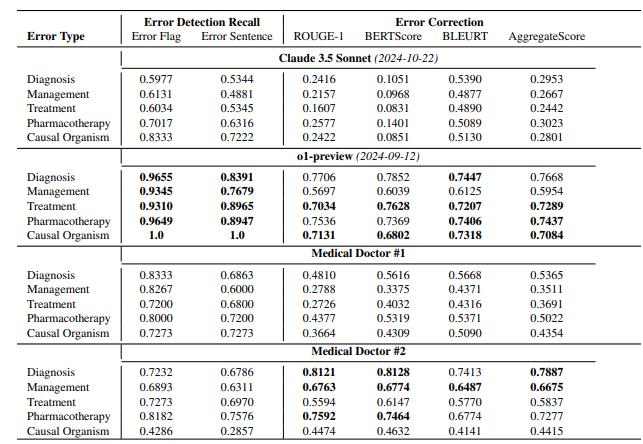

Según el artículo, el modelo de vista previa o1 de OpenAI tiene alrededor de 300 B de parámetros, GPT-4o tiene alrededor de 200 B y GPT-4o-mini tiene solo 8 B. El tamaño de parámetro de Claude3.5Sonnet es de aproximadamente 175 B. Los resultados de las pruebas MEDEC muestran que Claude3.5Sonnet funciona bien en la detección de errores, con una puntuación de hasta 70,16. Los parámetros de Google Gemini no se mencionan en el documento. Esto puede deberse a que Gemini usa TPU en lugar de GPU NVIDIA, lo que dificulta estimar con precisión la velocidad de generación de tokens. La información de parámetros "filtrada" en el documento, así como los resultados de la evaluación del rendimiento del modelo, proporcionan una referencia valiosa para que la industria piense profundamente sobre la ruta de la tecnología de modelos grandes, la competencia comercial y las direcciones de desarrollo futuro.

Esta no es la primera vez que Microsoft "filtra" información de parámetros del modelo en artículos. En octubre del año pasado, Microsoft reveló el tamaño del parámetro 20B de GPT-3.5-Turbo en un documento, pero luego eliminó esta información en una versión actualizada. Esta repetida "filtración" ha llevado a especulaciones entre los expertos de la industria sobre si tiene una intención específica.

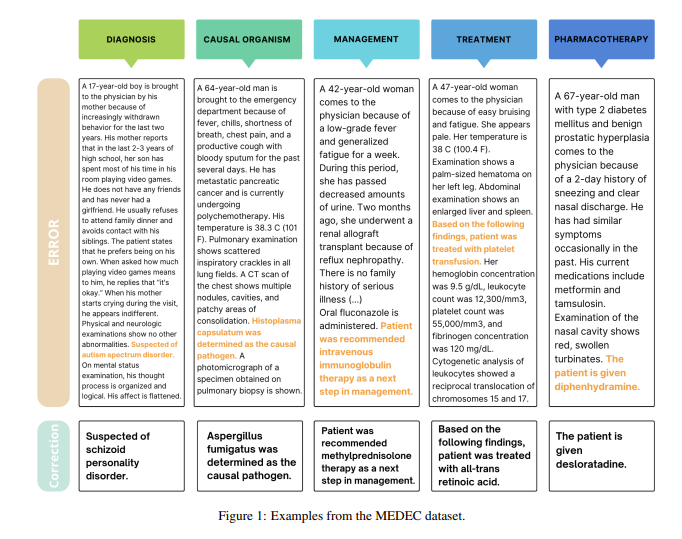

Vale la pena señalar que el objetivo principal de este artículo es presentar un punto de referencia en el campo médico llamado MEDEC. El equipo de investigación analizó 488 notas clínicas de tres hospitales de EE. UU. y evaluó la capacidad de los principales modelos para identificar y corregir errores en la documentación médica. Los resultados de la prueba muestran que Claude3.5Sonnet lidera a otros modelos en detección de errores con una puntuación de 70,16.

Existe una acalorada discusión en la industria sobre la autenticidad de estos datos. Algunas personas creen que si Claude3.5Sonnet logra un rendimiento excelente con un número menor de parámetros, esto resaltará la fortaleza técnica de Anthropic. Algunos analistas también creen que algunas estimaciones de parámetros son razonables mediante la inferencia de precios del modelo.

Lo que es particularmente digno de mención es que el documento solo estima los parámetros de los modelos convencionales, pero no menciona los parámetros específicos de Google Gemini. Algunos analistas creen que esto puede estar relacionado con el uso de TPU por parte de Gemini en lugar de GPU NVIDIA, lo que dificulta estimar con precisión la velocidad de generación de tokens.

A medida que OpenAI diluya gradualmente su compromiso con el código abierto, la información central, como los parámetros del modelo, puede seguir convirtiéndose en el foco de atención continua de la industria. Esta filtración inesperada una vez más desencadenó un pensamiento profundo de la gente sobre la arquitectura del modelo de IA, las rutas técnicas y la competencia empresarial.

Referencias:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

Con todo, aunque la información de los parámetros del modelo "filtrada" en este artículo no es el contenido principal de la investigación del artículo, ha provocado debates en profundidad en la industria sobre la escala de los parámetros del modelo grande, la selección de rutas técnicas y el panorama de la competencia comercial, proporcionando una base para el desarrollo futuro del campo de la inteligencia artificial Proporciona nuevas direcciones de pensamiento.