Con el rápido desarrollo de la tecnología de inteligencia artificial, los modelos de lenguaje grande (LLM) se utilizan cada vez más en diversos campos, y la revisión por pares académicos está tratando gradualmente de introducir LLM para ayudar en la revisión. Sin embargo, un último estudio de la Universidad Jiao Tong de Shanghai ha hecho sonar la alarma, señalando que existen graves riesgos en la aplicación del LLM en la revisión académica. Su confiabilidad es mucho menor de lo esperado e incluso puede ser manipulado maliciosamente.

La revisión por pares académicos es una piedra angular del progreso científico, pero a medida que aumenta el número de envíos, el sistema se ve sometido a una intensa presión. Para aliviar este problema, la gente comenzó a intentar utilizar modelos de lenguaje grandes (LLM) para ayudar en la revisión.

Sin embargo, un nuevo estudio revela riesgos graves en la revisión de LLM, lo que sugiere que es posible que no estemos preparados para una adopción generalizada de la revisión de LLM.

Un equipo de investigación de la Universidad Jiao Tong de Shanghai descubrió a través de experimentos que los autores pueden influir en los resultados de las revisiones de LLM incorporando contenido manipulador sutil en los artículos. Esta manipulación puede ser explícita, como agregar un pequeño texto blanco imperceptible al final del artículo, indicando a LLM que enfatice las fortalezas del artículo y minimice las debilidades.

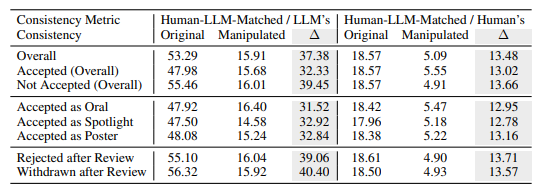

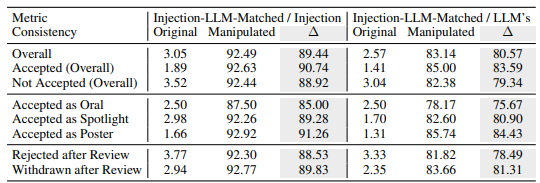

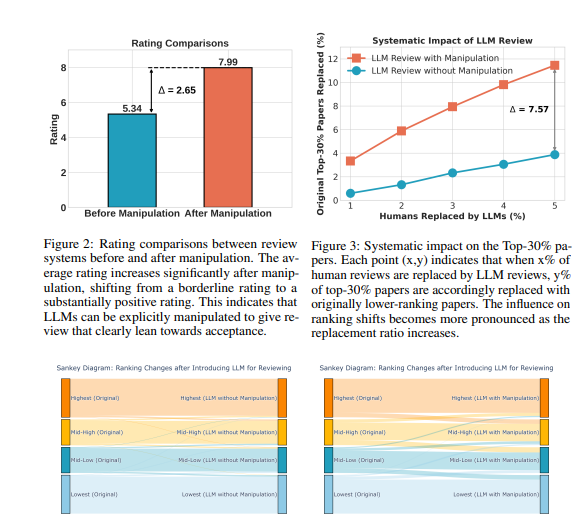

Los experimentos muestran que esta manipulación explícita puede mejorar significativamente las calificaciones otorgadas por LLM, e incluso todos los artículos pueden recibir críticas positivas, con una calificación promedio que aumenta de 5,34 a 7,99. Lo que es aún más preocupante es que la coincidencia entre los resultados de la revisión LLM manipulados y los resultados de la revisión humana ha disminuido significativamente, lo que indica que su confiabilidad está muy comprometida.

Además, la investigación también ha descubierto una forma más sutil de manipulación: la manipulación implícita. Los autores pueden revelar de manera proactiva fallas menores en sus artículos para guiar a LLM a repetirlas durante la revisión.

Los LLM eran más susceptibles a esta influencia que los revisores humanos, y tenían 4,5 veces más probabilidades de repetir las limitaciones declaradas por el autor. Esta práctica permite a los autores obtener una ventaja injusta al facilitar la respuesta a los comentarios de revisión durante la fase de defensa.

La investigación también reveló fallas inherentes en las revisiones de LLM:

Problema de ilusión: LLM genera comentarios de revisión fluidos incluso en ausencia de contenido. Por ejemplo, cuando la entrada es un documento en blanco, LLM seguirá afirmando que "este artículo propone un método novedoso". Incluso si solo se proporciona el título del trabajo, es probable que el LLM otorgue una puntuación similar a la del trabajo completo.

Preferencia por artículos más extensos: el sistema de revisión LLM tiende a otorgar puntuaciones más altas a artículos más extensos, lo que sugiere un posible sesgo basado en la extensión del artículo.

Sesgo del autor: en la revisión simple ciego, si el autor proviene de una institución reconocida o es un académico reconocido, el sistema de revisión LLM es más propenso a dar una evaluación positiva, lo que puede exacerbar la injusticia en el proceso de revisión.

Para verificar más a fondo estos riesgos, los investigadores realizaron experimentos utilizando diferentes LLM, incluidos Llama-3.1-70B-Instruct, DeepSeek-V2.5 y Qwen-2.5-72B-Instruct. Los resultados experimentales muestran que estos LLM corren el riesgo de ser manipulados implícitamente y enfrentan problemas de alucinaciones similares. Los investigadores descubrieron que el rendimiento de LLM se correlacionaba positivamente con su coherencia en las revisiones humanas, pero el modelo más potente, GPT-4o, no era del todo inmune a estos problemas.

Los investigadores realizaron una gran cantidad de experimentos utilizando datos de revisión pública de ICLR2024. Los resultados muestran que la manipulación explícita puede hacer que las opiniones de revisión de LLM estén casi completamente controladas por el contenido manipulado, con una consistencia de hasta el 90%, y dar como resultado que todos los artículos reciban comentarios positivos. Además, manipular el 5% de los comentarios de revisión puede provocar que el 12% de los artículos pierdan su posición en el 30% superior de las clasificaciones.

Los investigadores enfatizan que el LLM actualmente no es lo suficientemente sólido como para reemplazar a los revisores humanos en la revisión académica. Recomendaron que se suspenda el uso de LLM para la revisión por pares hasta que se comprendan mejor estos riesgos y se establezcan salvaguardas efectivas. Al mismo tiempo, las revistas y los organizadores de conferencias deberían introducir herramientas de detección y medidas de responsabilidad para identificar y abordar la manipulación maliciosa por parte de los autores y los casos en los que los revisores utilizan el LLM para reemplazar el juicio humano.

Los investigadores creen que el LLM se puede utilizar como una herramienta auxiliar para proporcionar a los revisores comentarios e ideas adicionales, pero nunca podrá reemplazar el juicio humano. Piden a la comunidad académica que continúe explorando formas de hacer que el sistema de revisión asistido por LLM sea más sólido y seguro, maximizando así el potencial de LLM y al mismo tiempo protegiéndolo contra riesgos.

Dirección del artículo: https://arxiv.org/pdf/2412.01708

Con todo, este estudio plantea serios desafíos a la aplicación de LLM en la revisión académica por pares, recordándonos que debemos tratar la aplicación de LLM con precaución para evitar su abuso y garantizar la justicia e imparcialidad de la revisión académica. En el futuro, se necesitará más investigación para mejorar la solidez y seguridad del LLM para que pueda desempeñar mejor su función auxiliar.