MiniMax lanzó una nueva serie de modelos de código abierto MiniMax-01 el 15 de enero de 2025, que incluye el modelo de texto grande MiniMax-Text-01 y el modelo visual multimodal grande MiniMax-VL-01. Esta serie de parámetros del modelo alcanza los 456 mil millones, con una única activación de 45,9 mil millones. Innova audazmente en arquitectura y aplica el mecanismo de atención lineal a gran escala por primera vez, rompiendo las limitaciones del transformador tradicional y capaz. de procesar eficientemente contextos de hasta 4 millones de tokens, significativamente por delante de los modelos existentes. La serie MiniMax-01 está a la par de los mejores modelos extranjeros en términos de rendimiento y muestra ventajas significativas en el procesamiento de textos largos. Su capacidad de procesamiento eficiente y su bajo precio la hacen extremadamente competitiva en aplicaciones comerciales.

MiniMax anunció el código abierto de su nueva serie de modelos MiniMax-01 el 15 de enero de 2025. La serie incluye el modelo grande de lenguaje básico MiniMax-Text-01 y el modelo grande visual multimodal MiniMax-VL-01. La serie MiniMax-01 ha realizado innovaciones audaces en arquitectura, implementando por primera vez un mecanismo de atención lineal a gran escala, rompiendo las limitaciones de la arquitectura tradicional Transformer. Su volumen de parámetros llega a 456 mil millones y una sola activación es de 45,9 mil millones. Su rendimiento integral es comparable al de los mejores modelos extranjeros y puede manejar de manera eficiente contextos de hasta 4 millones de tokens. Esta longitud es 32 veces mayor que la de GPT-4o. y Claude-3.5-Soneto 20 veces.

MiniMax cree que 2025 será un año crítico para el rápido desarrollo de los Agentes, ya sea un sistema de un solo agente o un sistema de múltiples agentes, se necesita un contexto más largo para admitir una memoria continua y una gran cantidad de comunicación. El lanzamiento de la serie de modelos MiniMax-01 es precisamente para satisfacer esta demanda y dar el primer paso para establecer las capacidades básicas de Agentes complejos.

Gracias a la innovación arquitectónica, la optimización de la eficiencia y la capacitación integrada en clústeres y el diseño push, MiniMax puede proporcionar servicios API de comprensión multimodal y de texto al rango de precios más bajo de la industria. El precio estándar es un token de entrada de 1 yuan/millón de tokens y un token de salida de 8. yuanes/cien 10.000 fichas. Se han lanzado la plataforma abierta MiniMax y la versión extranjera para que la experimenten los desarrolladores.

Los modelos de la serie MiniMax-01 son de código abierto en GitHub y se actualizarán continuamente. En las evaluaciones de comprensión multimodal y de textos convencionales de la industria, la serie MiniMax-01 empató con los modelos avanzados internacionalmente reconocidos GPT-4o-1120 y Claude-3.5-Sonnet-1022 en la mayoría de las tareas. Especialmente para tareas de texto largas, en comparación con el modelo Gemini de Google, MiniMax-Text-01 tiene la degradación de rendimiento más lenta a medida que aumenta la longitud de entrada, lo cual es significativamente mejor que Gemini.

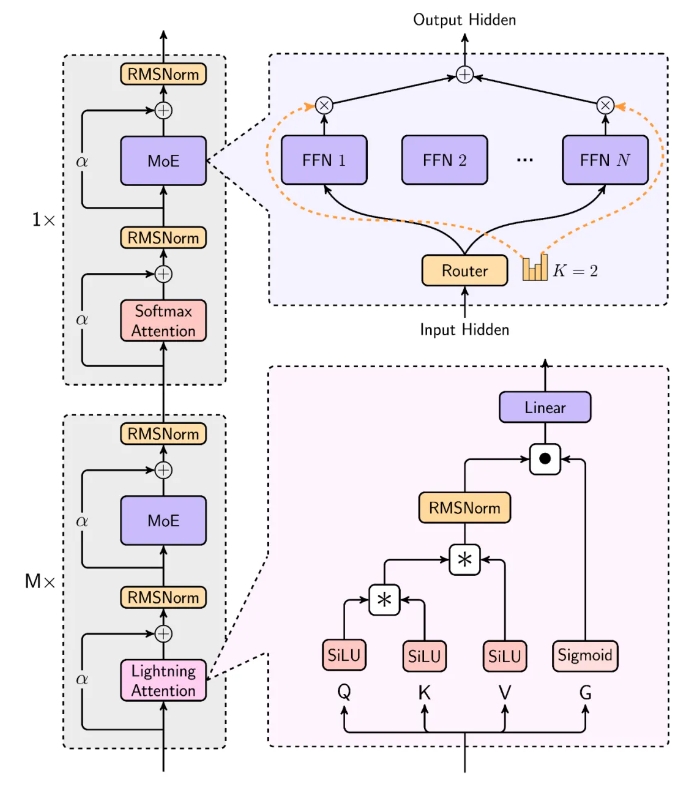

El modelo de MiniMax es extremadamente eficiente al procesar entradas largas, acercándose a la complejidad lineal. En su diseño estructural, 7 de cada 8 capas utilizan atención lineal basada en Lightning Attention, y 1 capa utiliza atención tradicional SoftMax. Esta es la primera vez en la industria que el mecanismo de atención lineal se extiende al nivel del modelo comercial. MiniMax considera de manera integral la ley de escala, la combinación con MoE, el diseño estructural, la optimización del entrenamiento y la optimización de la inferencia, y reconstruye el sistema de entrenamiento e inferencia. incluyendo MoE más eficiente Optimización de la comunicación total, optimización de secuencias más largas e implementación eficiente del kernel de atención lineal en el nivel de inferencia.

En la mayoría de las pruebas académicas, la serie MiniMax-01 ha logrado resultados comparables a los del primer nivel en el extranjero. Está significativamente por delante en el conjunto de evaluaciones de contexto a largo plazo, como su excelente desempeño en la tarea de recuperación de 4 millones de Needle-In-A-Haystack. Además de los conjuntos de datos académicos, MiniMax también creó un conjunto de prueba de escenario asistente basado en datos reales, y MiniMax-Text-01 tuvo un desempeño sobresaliente en este escenario. En el conjunto de pruebas de comprensión multimodal, MiniMax-VL-01 también está a la cabeza.

Dirección de código abierto: https://github.com/MiniMax-AI

El código abierto de los modelos de la serie MiniMax-01 ha inyectado nueva vitalidad al desarrollo del campo de la IA. Sus avances en el procesamiento de textos largos y la comprensión multimodal promoverán el rápido desarrollo de la tecnología de agentes y aplicaciones relacionadas. Esperamos más innovaciones y avances de MiniMax en el futuro.