Alibaba Damo Academy lanzó Valley2, un modelo de lenguaje multimodal a gran escala basado en escenarios de comercio electrónico. Este modelo combina Qwen2.5, codificador visual SigLIP-384 y módulos Eagle innovadores y adaptadores de convolución para mejorar el comercio electrónico y el rendimiento de las aplicaciones. en el campo de videos cortos. El conjunto de datos de Valley2 cubre datos de estilo OneVision, datos de campo de comercio electrónico y videos cortos y datos de pensamiento en cadena, y después de una capacitación de varias etapas, ha logrado excelentes resultados en múltiples pruebas de referencia públicas, especialmente en evaluaciones relacionadas con el comercio electrónico. La optimización de su diseño arquitectónico y estrategia de capacitación proporciona nuevas ideas para mejorar el rendimiento de grandes modelos multimodales.

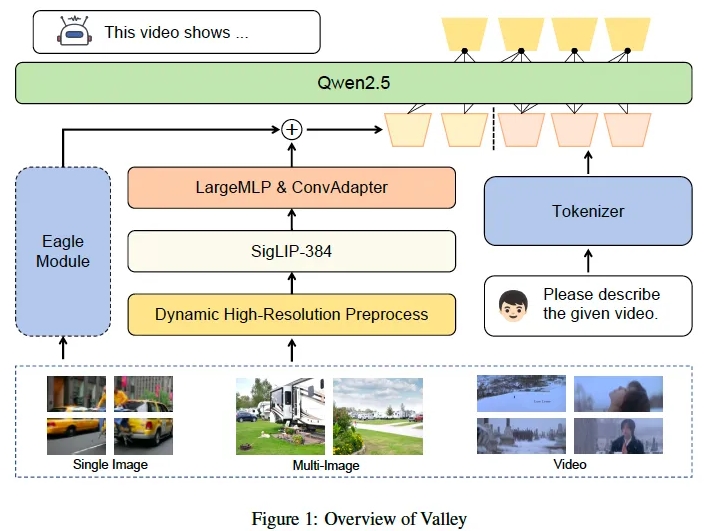

Alibaba Damo Academy lanzó recientemente un modelo de lenguaje multimodal a gran escala llamado Valley2. Este modelo está diseñado en base a escenarios de comercio electrónico y tiene como objetivo mejorar el rendimiento en varios campos y expandir el comercio electrónico y el uso a corto plazo a través de un visual escalable. Arquitectura del lenguaje. Límites de aplicación de escenas de vídeo. Valley2 utiliza Qwen2.5 como columna vertebral de LLM, junto con el codificador visual SigLIP-384, y combina capas MLP y convoluciones para una conversión de funciones eficiente. Su innovación radica en la introducción de un amplio vocabulario visual, un adaptador de convolución (ConvAdapter) y un módulo Eagle, que mejora la flexibilidad del procesamiento de diversas entradas del mundo real y la eficiencia del entrenamiento de inferencia.

Los datos de Valley2 consisten en datos de estilo OneVision, datos para comercio electrónico y campos de videos cortos, y datos de Chain of Thinking (CoT) para la resolución de problemas complejos. El proceso de capacitación se divide en cuatro etapas: alineación texto-visual, aprendizaje de conocimientos de alta calidad, ajuste de la instrucción y pensamiento en cadena posterior a la capacitación. En los experimentos, Valley2 tuvo un buen desempeño en múltiples pruebas de referencia públicas, especialmente con puntuaciones altas en MMBench, MMStar, MathVista y otras pruebas de referencia, y también superó a otros modelos del mismo tamaño en la prueba de referencia Ecom-VQA.

En el futuro, Alibaba DAMO Academy planea lanzar un modelo integral que incluya modalidades de texto, imagen, video y audio, e introducir un método de capacitación de integración multimodal basado en Valley para respaldar aplicaciones de recuperación y detección posteriores.

El lanzamiento de Valley2 marca un progreso importante en el campo de los modelos de lenguaje multimodales a gran escala, lo que demuestra la posibilidad de mejorar el rendimiento del modelo mediante mejoras estructurales, construcción de conjuntos de datos y optimización de estrategias de capacitación.

Enlace del modelo:

https://www.modelscope.cn/models/bytedance-research/Valley-Eagle-7B

Enlace de código:

https://github.com/bytedance/Valley

Enlace del artículo:

https://arxiv.org/abs/2501.05901

El lanzamiento de Valley2 no solo demuestra la tecnología avanzada de Alibaba Damo Academy en el campo de los modelos grandes multimodales, sino que también indica que los campos del comercio electrónico y los videos cortos marcarán el comienzo de aplicaciones más innovadoras basadas en IA en el futuro. Esperamos que Valley2 pueda mejorar y ampliar aún más sus escenarios de aplicaciones en el futuro, brindando servicios más convenientes e inteligentes a los usuarios.