Mejorar la eficiencia del razonamiento de modelos grandes es un desafío clave en el campo de la inteligencia artificial. La alta carga de inferencia, el alto costo y el largo tiempo de respuesta restringen severamente la aplicación de modelos grandes. Para resolver estos problemas, Kimi Company cooperó con el Laboratorio MADSys de la Universidad de Tsinghua para desarrollar conjuntamente el sistema de inferencia Mooncake basado en KVCache y se lanzará oficialmente en junio de 2024. El sistema adopta una innovadora arquitectura de separación de PD y un concepto centrado en la conversión de almacenamiento para mejorar significativamente el rendimiento del razonamiento. Para promover la aplicación y popularización de la tecnología, el proyecto Mooncake es oficialmente de código abierto.

Kimi Company, junto con el Laboratorio MADSys de la Universidad de Tsinghua, lanzó el plan de diseño del sistema de inferencia Mooncake basado en KVCache, que se lanzará oficialmente en junio de 2024.

El sistema de inferencia Mooncake ha mejorado significativamente el rendimiento de la inferencia a través de su innovadora arquitectura de separación de PD y su concepto centrado en la conversión de almacenamiento, atrayendo una atención generalizada de la industria. Para promover aún más la aplicación y popularización de este marco técnico, Kimi y el Laboratorio MADSys de la Universidad Tsinghua se asociaron con varias empresas, como 9#AISoft, Alibaba Cloud, Huawei Storage, etc., para lanzar el proyecto de código abierto Mooncake. . El 28 de noviembre, el marco técnico de Mooncake se lanzó oficialmente en la plataforma GitHub.

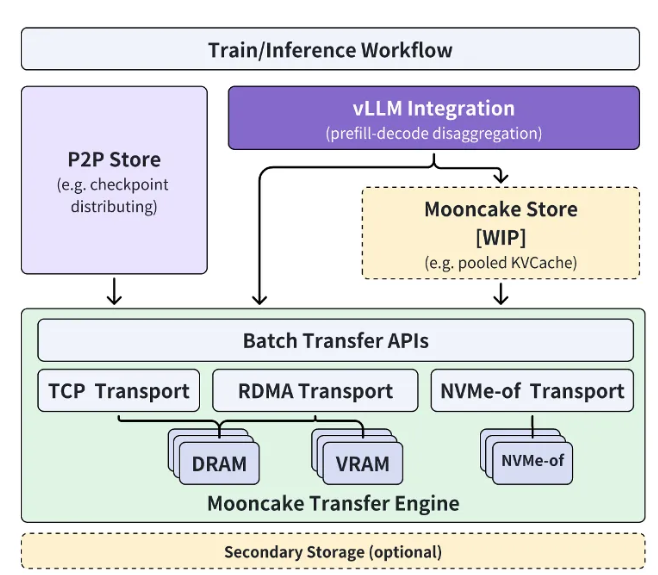

El proyecto de código abierto Mooncake gira en torno al grupo de caché KVCache de gran escala y se compromete a abrir gradualmente el código abierto del Mooncake Store de caché multinivel KVCache de alto rendimiento de manera gradual. Al mismo tiempo, el proyecto será compatible con una variedad de motores de inferencia y recursos subyacentes de almacenamiento y transmisión.

Actualmente, la parte de Transfer Engine ha sido de código abierto a nivel mundial en GitHub. El objetivo final del proyecto Mooncake es construir una nueva interfaz estándar para el almacenamiento semántico de memoria de alto rendimiento para la era de los modelos grandes y proporcionar soluciones de implementación de referencia relacionadas.

Xu Xinran, vicepresidente de ingeniería de Kimi Company, dijo: “A través de una estrecha cooperación con el laboratorio MADSys de la Universidad de Tsinghua, creamos conjuntamente Mooncake, una arquitectura de inferencia de modelos grandes separada, logrando la máxima optimización de los recursos de inferencia.

Mooncake no solo mejora la experiencia del usuario, sino que también reduce los costos, proporcionando una solución eficaz para procesar textos largos y requisitos de alta concurrencia. Espera que más empresas e instituciones de investigación se unan al proyecto Mooncake para explorar conjuntamente una arquitectura de sistema de razonamiento modelo más eficiente, de modo que los productos basados en tecnología de modelos grandes, como los asistentes de inteligencia artificial, puedan beneficiar a una gama más amplia de personas.

Entrada del proyecto: https://github.com/kvcache-ai/Mooncake

Destacar:

Kimi y la Universidad de Tsinghua lanzaron conjuntamente el sistema de razonamiento Mooncake para mejorar la eficiencia del razonamiento de la IA.

El proyecto Mooncake ha sido de código abierto en GitHub y tiene como objetivo crear una interfaz estándar de almacenamiento semántico de memoria de alto rendimiento.

Esperamos la participación de más empresas e instituciones de investigación para promover conjuntamente el progreso de la tecnología de IA.

El lanzamiento del proyecto de código abierto Mooncake marca una nueva etapa en la arquitectura de sistemas de inferencia de modelos grandes. Su desempeño eficiente y su modelo de cooperación abierta promoverán efectivamente el progreso y la aplicación de la tecnología de inteligencia artificial y contribuirán a construir un mundo más inteligente.