La tecnología de animación de imágenes basada en audio ha logrado avances significativos en los últimos años, pero los problemas de complejidad y eficiencia de los modelos existentes limitan su aplicación. Para resolver estos problemas, los investigadores desarrollaron una nueva tecnología llamada JoyVASA, que mejora significativamente la calidad, la eficiencia y el alcance de aplicación de la animación de imágenes basada en audio a través de un innovador diseño de dos etapas. JoyVASA no sólo es capaz de generar vídeos animados más largos, sino que también anima retratos humanos y rostros de animales, y admite varios idiomas.

Recientemente, los investigadores propusieron una nueva tecnología llamada JoyVASA, cuyo objetivo es mejorar los efectos de animación de imágenes basados en audio. Con el desarrollo continuo de modelos de difusión y aprendizaje profundo, la animación de retratos basada en audio ha logrado avances significativos en la calidad del video y la precisión de la sincronización de labios. Sin embargo, la complejidad de los modelos existentes aumenta la eficiencia del entrenamiento y la inferencia, al tiempo que limita la duración y la continuidad entre fotogramas de los vídeos.

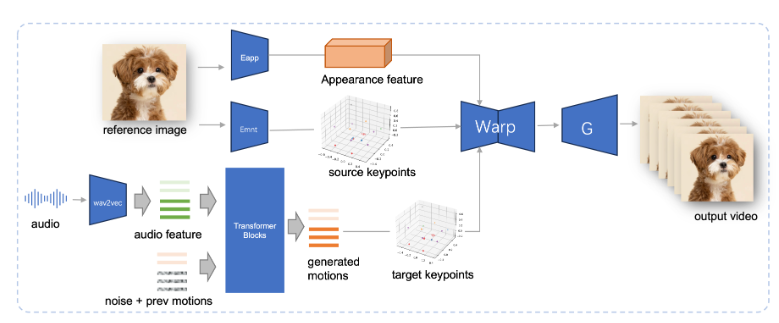

JoyVASA adopta un diseño de dos etapas. La primera etapa introduce un marco de representación facial desacoplada para separar las expresiones faciales dinámicas de las representaciones faciales estáticas tridimensionales.

Esta separación permite al sistema combinar cualquier modelo facial 3D estático con secuencias de acción dinámicas para generar videos animados más largos. En la segunda etapa, el equipo de investigación entrenó un transformador de difusión que puede generar secuencias de acción directamente a partir de señales de audio, un proceso independiente de la identidad del personaje. Finalmente, el generador basado en el entrenamiento de la primera etapa toma la representación facial 3D y la secuencia de acción generada como entrada para generar efectos de animación de alta calidad.

En particular, JoyVASA no se limita a la animación de retratos humanos, sino que también puede animar rostros de animales sin problemas. Este modelo está entrenado en un conjunto de datos mixtos, que combina datos privados en chino y datos públicos en inglés, lo que muestra buenas capacidades de soporte en varios idiomas. Los resultados experimentales demuestran la eficacia de este método. Las investigaciones futuras se centrarán en mejorar el rendimiento en tiempo real y perfeccionar el control de la expresión para ampliar aún más la aplicación de este marco en la animación de imágenes.

La aparición de JoyVASA marca un avance importante en la tecnología de animación basada en audio, promoviendo nuevas posibilidades en el campo de la animación.

Entrada del proyecto: https://jdh-algo.github.io/JoyVASA/

Destacar:

La tecnología JoyVASA permite una generación de videos animados más largos al desacoplar las expresiones faciales de los modelos 3D.

Esta tecnología puede generar secuencias de acción basadas en señales de audio y tiene la doble capacidad de animación de personajes y animales.

JoyVASA está capacitado en conjuntos de datos en chino e inglés, tiene soporte en varios idiomas y brinda servicios a usuarios de todo el mundo.

La innovación de la tecnología JoyVASA radica en su diseño desacoplado y el uso eficiente de señales de audio, lo que proporciona una nueva dirección para el desarrollo futuro de la tecnología de animación de imágenes impulsada por audio. Su soporte en varios idiomas y sus capacidades eficientes de generación de animación también la convierten en una aplicación ampliamente utilizada. perspectivas. Se espera que JoyVASA pueda mejorar aún más el rendimiento en tiempo real y lograr un control de expresión más sofisticado en el futuro.