El equipo de investigación de la Universidad de Washington lanzó un nuevo modelo de seguimiento visual SAMURAI, que se basa en SAM2 y tiene como objetivo superar los desafíos del seguimiento visual en escenas complejas, especialmente el seguimiento de objetos que se mueven rápidamente y se ocluyen automáticamente. SAMURAI mejora significativamente las capacidades de predicción del movimiento de objetos y la precisión de la selección de máscaras al introducir señales de movimiento temporal y mecanismos de selección de memoria conscientes del movimiento, logrando un seguimiento robusto y preciso sin reentrenamiento y funcionando bien en múltiples conjuntos de datos de referencia. Excelente rendimiento de muestra cero.

Recientemente, un equipo de investigación de la Universidad de Washington lanzó un nuevo modelo de seguimiento visual llamado SAMURAI. Este modelo se basa en Segment Anything Model2 (SAM2) y está diseñado para resolver los desafíos encontrados en el seguimiento visual de objetos en escenas complejas, especialmente cuando se trata de objetos que se mueven rápidamente y se ocluyen solos.

SAM2 funciona bien en tareas de segmentación de objetos, pero tiene algunas limitaciones en el seguimiento visual. Por ejemplo, en escenas con mucha gente, la memorización de ventana fija no tiene en cuenta la calidad de la memoria seleccionada, lo que puede provocar que los errores se propaguen a lo largo de la secuencia de vídeo.

Para resolver este problema, el equipo de investigación propuso SAMURAI, que mejora significativamente la capacidad de predicción del movimiento de objetos y la precisión de la selección de máscara mediante la introducción de señales de movimiento temporales y un mecanismo de selección de memoria de percepción de movimiento. Esta innovación permite a SAMURAI lograr un seguimiento sólido y preciso sin necesidad de volver a capacitarse o realizar ajustes.

En términos de operación en tiempo real, SAMURAI demostró un sólido rendimiento de disparo cero, lo que significa que el modelo aún puede funcionar bien sin ser entrenado en un conjunto de datos específico.

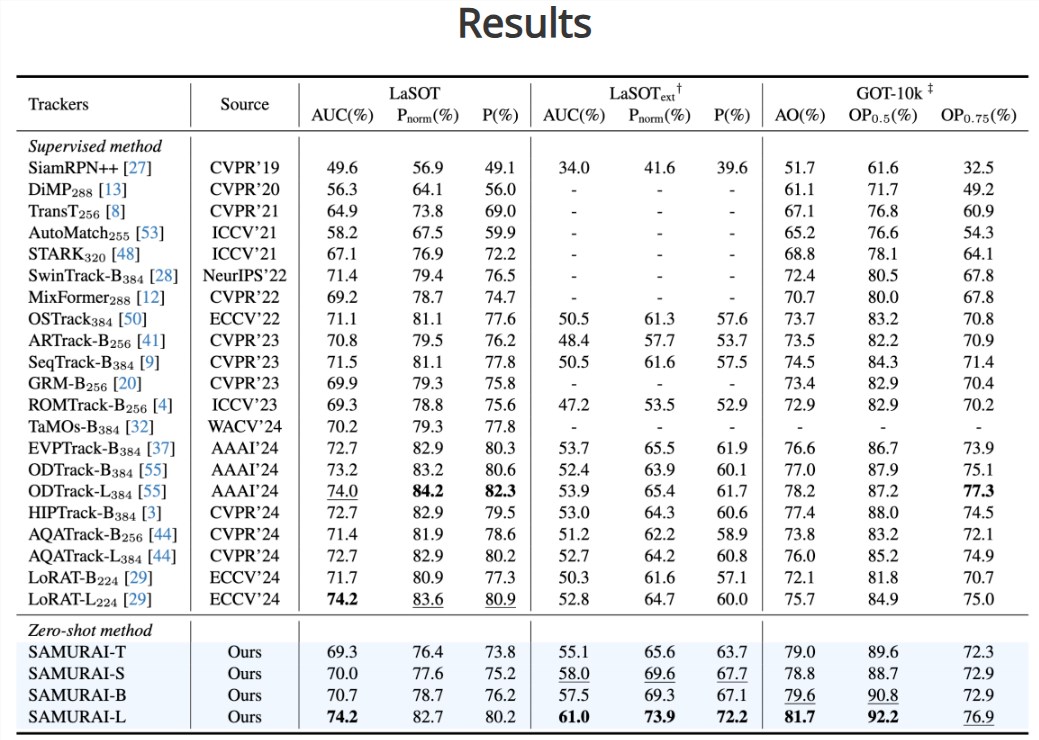

A través de la evaluación, el equipo de investigación descubrió que la tasa de éxito y la precisión de SAMURAI en múltiples conjuntos de datos de referencia han mejorado significativamente. En el conjunto de datos LaSOT-ext, SAMURAI logró un aumento de AUC del 7,1 %, mientras que en el conjunto de datos GOT-10k logró un aumento de AO del 3,5 %. Además, en comparación con los métodos totalmente supervisados, SAMURAI se desempeña igualmente de manera competitiva en el conjunto de datos LaSOT, lo que demuestra su solidez y su amplio potencial de aplicación en escenarios de seguimiento complejos.

El equipo de investigación afirmó que el éxito de SAMURAI sienta las bases para la futura aplicación de la tecnología de seguimiento visual en entornos más complejos y dinámicos. Esperan que esta innovación pueda promover el desarrollo del campo del seguimiento visual, satisfacer las necesidades de las aplicaciones en tiempo real y proporcionar capacidades de reconocimiento visual más sólidas para varios dispositivos inteligentes.

Entrada del proyecto: https://yangchris11.github.io/samurai/

Destacar:

SAMURAI es una mejora innovadora del modelo SAM2, cuyo objetivo es mejorar las capacidades de seguimiento visual de objetos en escenas complejas.

Al introducir un mecanismo de memoria sensible al movimiento, SAMURAI puede predecir con precisión el movimiento de los objetos y optimizar la selección de máscara, evitando la propagación de errores.

En múltiples conjuntos de datos de referencia, SAMURAI muestra un sólido rendimiento de disparo cero, lo que mejora significativamente la tasa de éxito y la precisión del seguimiento.

La aparición del modelo SAMURAI marca un progreso significativo en la tecnología de seguimiento visual. Su alta precisión y robustez en escenas complejas brindan un fuerte apoyo para la mejora de las capacidades de reconocimiento visual de futuros dispositivos inteligentes. .