Alibaba Cloud ha lanzado un modelo de lenguaje grande Qwen2.5-Turbo recientemente actualizado. Su longitud de contexto supera el millón de tokens y su potencia de procesamiento supera con creces la de productos similares. Esto representa un gran salto en las capacidades de procesamiento de textos largos, permitiendo a los usuarios procesar fácilmente el equivalente a 10 novelas de tres cuerpos o 30.000 líneas de código. El modelo funcionó bien en múltiples pruebas de referencia, superando especialmente a GPT-4 en comprensión de textos largos, y logró una velocidad de inferencia extremadamente alta y un costo extremadamente bajo manteniendo la precisión del procesamiento de textos cortos.

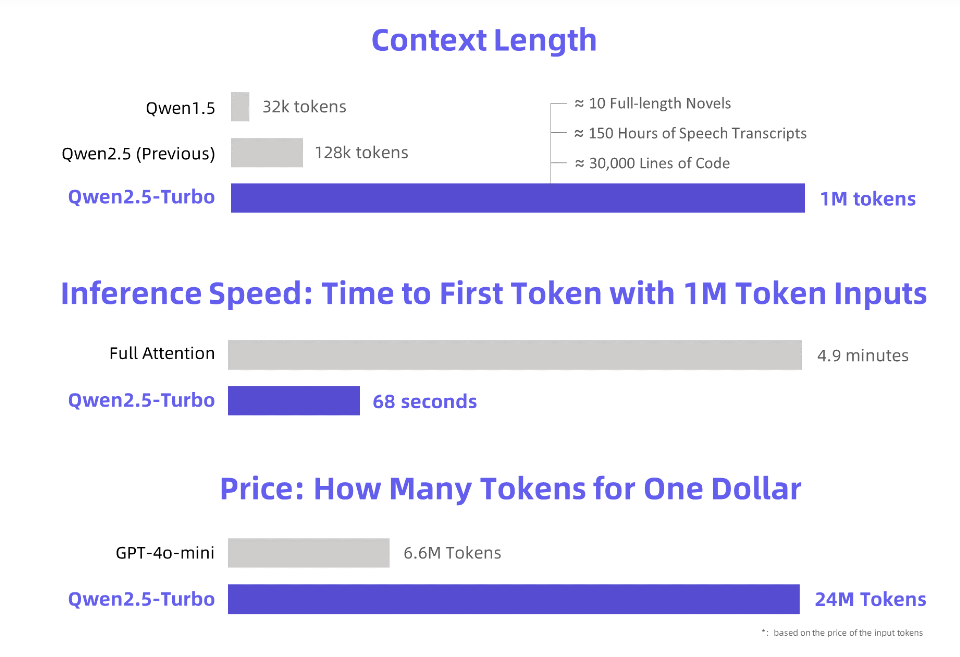

Alibaba Cloud lanza el modelo de lenguaje grande Qwen2.5-Turbo recientemente actualizado, cuya longitud de contexto supera la sorprendente cifra de 1 millón de tokens. ¿Cuál es el equivalente de este concepto? ¡Es equivalente a 10 novelas de "Tres cuerpos", 150 horas de transcripción de voz o 30.000 líneas de capacidad de código! ¡Esta vez, "leer diez novelas de una vez" ya no es un sueño!

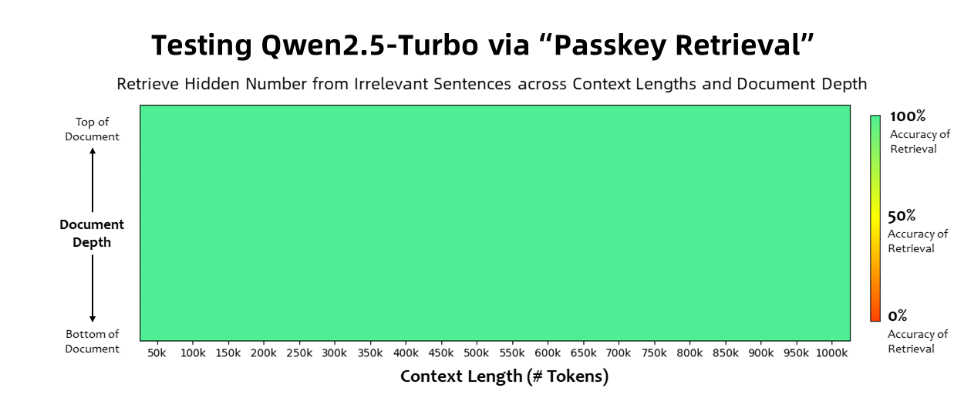

El modelo Qwen2.5-Turbo logró una precisión del 100% en la tarea de recuperación de claves de acceso y superó modelos similares como GPT-4 en términos de capacidades de comprensión de textos largos. El modelo logró una puntuación alta de 93,1 en la prueba de texto largo RULER, mientras que GPT-4 obtuvo sólo 91,6 y GLM4-9B-1M obtuvo 89,9.

Además de las capacidades de procesamiento de textos ultralargos, Qwen2.5-Turbo también tiene la precisión del procesamiento de textos cortos. En la prueba comparativa de textos cortos, su rendimiento es comparable al de GPT-4o-mini y Qwen2.5-14B-Instruct. modelos.

Al adoptar el mecanismo de atención escasa, el modelo Qwen2.5-Turbo acorta el tiempo de procesamiento del primer token de 1 millón de tokens de 4,9 minutos a 68 segundos, logrando un aumento de 4,3 veces en la velocidad de inferencia.

Al mismo tiempo, el costo de procesar 1 millón de tokens es de solo 0,3 yuanes. En comparación con GPT-4o-mini, puede procesar 3,6 veces el contenido al mismo costo.

Alibaba Cloud ha preparado una serie de demostraciones del modelo Qwen2.5-Turbo, que muestran su aplicación en la comprensión profunda de novelas, asistencia de código y lectura de múltiples artículos. Por ejemplo, después de que un usuario subiera la trilogía de novelas chinas "El problema de los tres cuerpos" que contenía 690.000 tokens, el modelo resumió con éxito la trama de cada novela en inglés.

Los usuarios pueden experimentar las potentes funciones del modelo Qwen2.5-Turbo a través del servicio API de Alibaba Cloud Model Studio, HuggingFace Demo o ModelScope Demo.

Alibaba Cloud declaró que en el futuro continuará optimizando el modelo para mejorar su alineación de preferencias humanas en tareas de secuencia larga, optimizar aún más la eficiencia de la inferencia, reducir el tiempo de computación e intentar lanzar un modelo de contexto largo más grande y más fuerte.

Introducción oficial: https://qwenlm.github.io/blog/qwen2.5-turbo/

Demostración en línea: https://huggingface.co/spaces/Qwen/Qwen2.5-Turbo-1M-Demo

Documentación API: https://help.aliyun.com/zh/model-studio/getting-started/first-api-call-to-qwen

Qwen2.5-Turbo, con sus poderosas capacidades de procesamiento de textos largos y su bajo costo, abre nuevas posibilidades para aplicaciones de modelos de lenguaje grandes, y vale la pena esperar su desarrollo futuro. Para obtener más información, visite el enlace proporcionado.