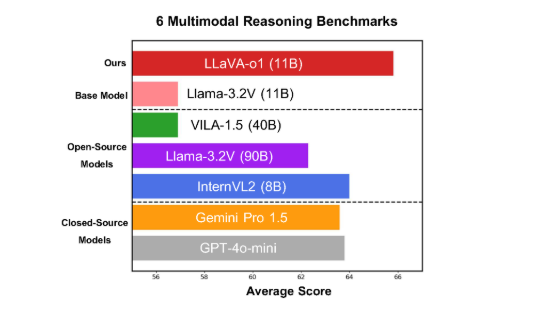

Los equipos de investigación como la Universidad de Peking publicaron recientemente un modelo de código abierto de modo múltiple Llava-O1. razonamiento sistemático. Llava-O1 adopta el mecanismo de razonamiento de "pensamiento lento" para descomponer el proceso de razonamiento en cuatro etapas: resumen, interpretación visual, razonamiento lógico y generación de conclusión, que evita efectivamente los errores causados por la simplificación de los procesos de razonamiento del modelo tradicional. Este modelo funcionó bien en seis pruebas de referencia desafiantes, superó a muchos competidores y se desempeñó bien en la comparación de fuentes más grandes o cerradas.

Recientemente, los equipos de investigación científica, como la Universidad de Pekín, anunciaron el lanzamiento de un modelo de código abierto de modo múltiple llamado Llava-O1. O1.

Este modelo funcionó bien en seis pruebas de referencia de modo múltiple desafiante.

Llava-O1 se basa en el modelo de visión LLAMA-3.2.

En la prueba de referencia de razonamiento de modo múltiple, el rendimiento de Llava-O1 excedió su modelo básico de 8.9%. La singularidad de este modelo es que su proceso de razonamiento se divide en cuatro etapas: resumen, interpretación visual, razonamiento lógico y generación de conclusión. En los modelos tradicionales, el proceso de razonamiento a menudo es relativamente simple, y es fácil causar errores.

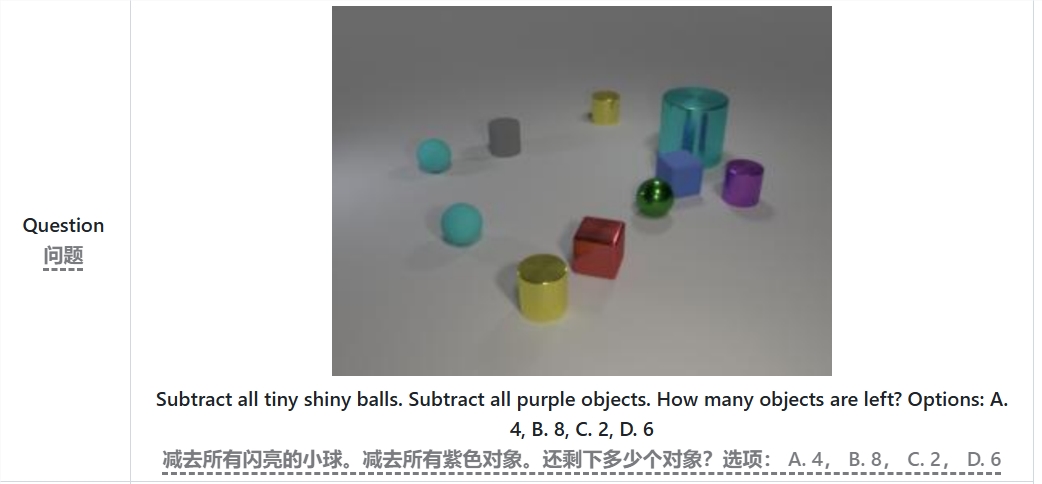

Por ejemplo, al resolver el problema de "menos todas las pequeñas bolas brillantes y objetos morados, cuántos objetos quedan", Llava-O1 primero resumirá el problema, luego extraerá información de la imagen, luego razonará gradualmente y finalmente lo dará para darlo. Este método en fase mejora las capacidades de razonamiento del sistema del modelo y lo hace más eficiente cuando se trata de problemas complejos.

Vale la pena mencionar que el Llava-O1 introdujo un método de búsqueda de haz de nivel de etapa durante el proceso de razonamiento. Este método permite que el modelo genere múltiples respuestas candidatas en cada etapa de razonamiento y seleccione la mejor respuesta para continuar la siguiente etapa de razonamiento, lo que mejora significativamente la calidad general de razonamiento. Al supervisar los datos de entrenamiento de ajuste fino y razonable, Llava-O1 funcionó bien en comparación con fuentes más grandes o cerradas.

Los resultados de la investigación del equipo de la Universidad de Pekín no solo promovieron el desarrollo de IA multimodal, sino que también proporcionaron nuevas ideas y métodos para futuros modelos de comprensión del lenguaje visual. El equipo dijo que el código de Llava-O1, el peso de entrenamiento previo al entrenamiento y los conjuntos de datos serán de código abierto, y se espera que más investigadores y desarrolladores exploren y apliquen este modelo innovador.

Tesis: https://arxiv.org/abs/2411.10440

GitHub: https: //github.com/pku- yuanroup/llava-o1

Agujas:

Llava-O1 es un nuevo modelo de razonamiento multimodal publicado por equipos como la Universidad de Pekín, que tiene la capacidad de "pensar lentamente" el razonamiento.

El rendimiento excede el 8,9%del modelo básico en la prueba de referencia de razonamiento de modificaciones múltiples.

Llava-O1 a través del razonamiento estructurado de varios pasos para garantizar la precisión y será de código abierto en el futuro cercano.

El código abierto de Llava-O1 promoverá la investigación y el desarrollo de campos de IA multimodales, y proporcionará una base sólida para la construcción de modelos de lenguaje visual más inteligentes y más fuertes. Esperamos mostrar más potencial en futuras aplicaciones. Los documentos y los enlaces de GitHub son convenientes para que los investigadores comprendan y usen el modelo en profundidad.