El costo de reducir el costo de capacitación de modelos grandes es el punto de acceso de investigación actual en el campo de la inteligencia artificial. La reciente investigación publicada por el equipo de Yuan Mixed Yuan ha discutido profundamente las leyes de la escala de capacitación cuantitativa de punto flotante de bajo precio, que proporciona nuevas ideas para modelos de capacitación de alta eficiencia. El estudio analizó los efectos del tamaño del modelo, los datos de capacitación, la precisión cuantitativa y otros factores sobre los efectos de capacitación a través de una gran cantidad de experimentos, y finalmente obtuvo la ley de cómo asignar eficazmente los recursos de capacitación para obtener el mejor efecto bajo diferente precisión. Esta investigación no solo tiene una importancia teórica importante, sino que también proporciona una guía valiosa para la aplicación real de modelos grandes.

Hoy, el rápido desarrollo del modelo de lenguaje grande (LLM), el costo de la capacitación y el razonamiento de los modelos se ha convertido cada vez más en el foco de investigación y aplicación. Recientemente, el equipo de Yuan Mixed de Tencent publicó un estudio importante que discutió profundamente las "leyes de escala" de la capacitación cuantitativa de punto flotante de bajo nivel, es decir, la ley a escala de la capacitación a escala de la capacitación cuantitativa de punto flotante. El núcleo de este estudio es reducir los costos de cálculo y almacenamiento al reducir la precisión del modelo y no perder el rendimiento.

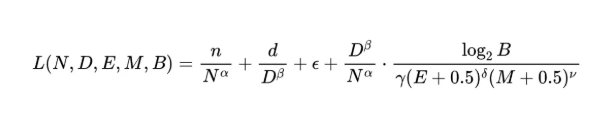

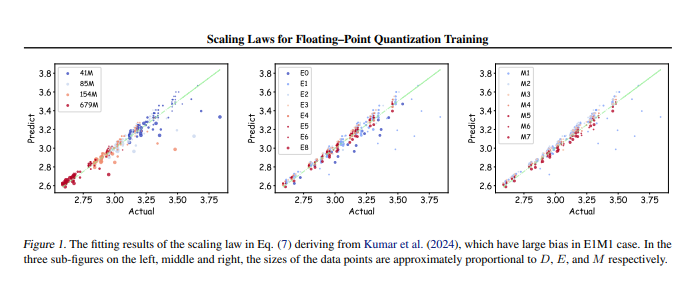

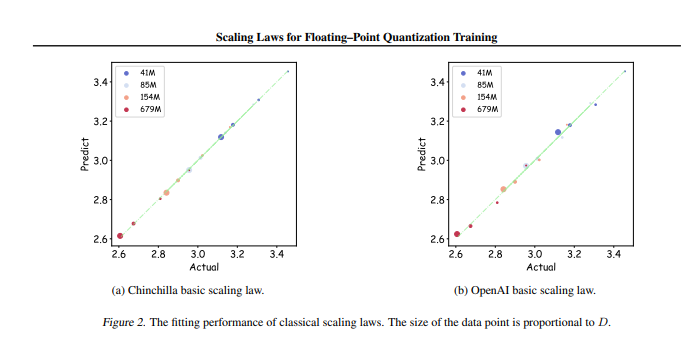

El equipo de investigación realizó hasta 366 conjuntos de entrenamiento cuantitativo de punto flotante de diferentes parámetros y precisión. ), el bit de índice (e) ,,,,,,,,, el bit de índice (e) ,,,,, el bit de índice (e) ,,,,,,,, Tail digital (M) y la partícula cuantitativa tamaño (b). A través de estos experimentos, los investigadores han obtenido una ley de escala unificada, revelando cómo configurar de manera efectiva los datos de capacitación y los parámetros del modelo con una precisión diferente para obtener los mejores resultados de capacitación.

Lo más importante es que la investigación señaló que en cualquier capacitación cuantitativa de punto flotante de baja precisión, existe un "efecto límite", es decir, bajo una cantidad específica de datos, el rendimiento del modelo alcanzará lo óptimo. . Además, el estudio también encontró que teóricamente la mejor precisión de entrenamiento cuantitativo de punto flotante efectivo de costo debe ser de entre 4 y 8 bocas, lo que tiene una importante importancia guía para el LLM eficiente.

Este estudio no solo llena el vacío en el campo de la capacitación cuantitativa de punto flotante, sino que también proporciona referencia para futuros fabricantes de hardware para ayudarlos a optimizar las capacidades de computación de punto flotante con una precisión diferente. Al final, esta investigación proporciona una dirección clara para la práctica de una gran capacitación en modelos para garantizar que, en el caso de recursos limitados, aún pueda lograr efectos de capacitación eficientes.

Dirección de tesis: https: //arxiv.org/pdf/2501.02423

En resumen, este estudio del equipo híbrido de Tencent proporcionó una solución efectiva para reducir el costo de los grandes modelos de capacitación. Este trabajo señaló la dirección de la alta eficiencia y el entrenamiento de modelos de bajo costo, y es digno de atención y en una investigación profunda.