El equipo de Alibaba Cloud Tongyi lanza un nuevo modelo de recompensa de proceso de razonamiento matemático Qwen2.5-Math-PRM. Este modelo está disponible en tamaños 72B y 7B y supera significativamente los modelos similares de código abierto en rendimiento, especialmente en la identificación de errores de razonamiento. Vale la pena señalar que la versión 7B incluso superó al popular GPT-4o, lo que demuestra el gran avance de Alibaba Cloud en el campo de la investigación y el desarrollo de modelos de inferencia. Para evaluar el rendimiento del modelo de manera más integral, el equipo también abrió el estándar de evaluación de primer nivel ProcessBench, que contiene 3.400 preguntas matemáticas que cubren la dificultad de la Olimpiada de Matemáticas y está marcado con procesos de razonamiento detallados realizados por expertos para garantizar la cientificidad. y rigor de la evaluación.

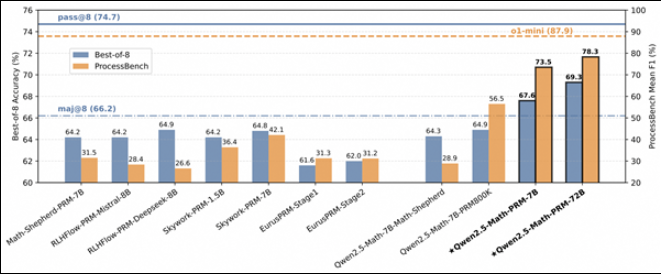

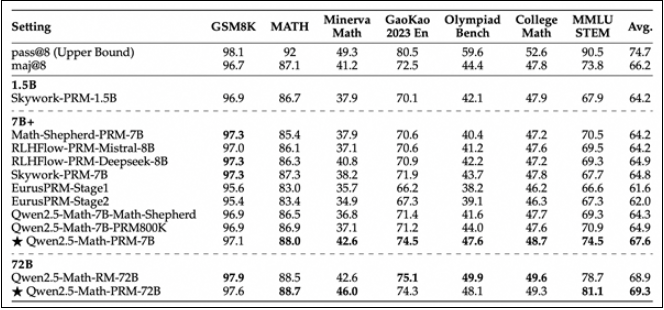

Hoy, el equipo de Alibaba Cloud Tongyi lanzó oficialmente un nuevo modelo de recompensa del proceso de razonamiento matemático Qwen2.5-Math-PRM. El modelo está disponible en tamaños 72B y 7B, y su rendimiento es significativamente mejor que modelos similares de recompensa de procesos de código abierto, especialmente en la identificación de errores de inferencia.

La versión 7B de Qwen2.5-Math-PRM superó sorprendentemente al popular GPT-4o de la industria. Este logro marca un paso importante para Alibaba Cloud en el desarrollo de modelos de inferencia. Para evaluar de manera integral el desempeño del modelo en el razonamiento matemático, el equipo de Tongyi también abrió el estándar de evaluación de primer nivel: ProcessBench. Este estándar de evaluación cubre 3400 casos de prueba de problemas matemáticos, incluidas preguntas difíciles de la Competencia Internacional de la Olimpiada de Matemáticas. Cada caso está marcado con un proceso de razonamiento detallado realizado por expertos humanos para garantizar la cientificidad y la exhaustividad de la evaluación.

Al evaluar el rendimiento de Qwen2.5-Math-PRM en ProcessBench, el equipo de investigación descubrió que tanto el modelo de tamaño 72B como el 7B funcionaron bien. Especialmente la versión 7B, no solo supera al modelo de código abierto del mismo tamaño, sino que incluso supera al modelo de código cerrado GPT-4o-0806 en algunos aspectos. Esto demuestra el gran potencial del Modelo de Recompensa de Procesos (PRM) para mejorar la confiabilidad del razonamiento y proporciona nuevas ideas para el desarrollo de futuras tecnologías de supervisión de procesos de razonamiento.

Este trabajo innovador del equipo de Alibaba Cloud Tongyi no solo promueve el avance de la tecnología de razonamiento de inteligencia artificial, sino que también proporciona una referencia valiosa para otros desarrolladores de la industria. A través del código abierto, el equipo de Tongyi espera compartir experiencias con más investigadores y promover el progreso tecnológico en toda la industria.

El lanzamiento de Qwen2.5-Math-PRM marca un nuevo avance para los modelos grandes en el campo del razonamiento matemático. Su característica de código abierto también proporciona una gran conveniencia para la investigación y la aplicación en el mundo académico y la industria. Más posibilidades en el futuro desarrollo de la inteligencia artificial.