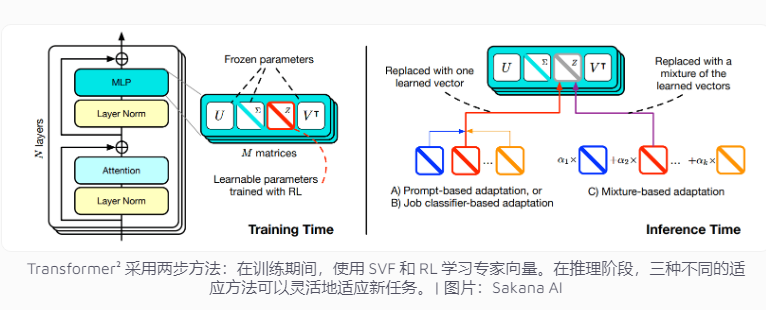

La empresa japonesa Sakana AI lanzó recientemente Transformer², una tecnología innovadora diseñada para mejorar la adaptabilidad de las tareas del modelo de lenguaje. A diferencia de los sistemas de IA tradicionales que necesitan procesar múltiples tareas a la vez, Transformer² utiliza aprendizaje en dos etapas, utilizando vectores expertos y tecnología de ajuste fino de valor singular (SVF), lo que le permite adaptarse eficientemente a nuevas tareas sin volver a capacitar a toda la red, mejorando significativamente Esto reduce significativamente el consumo de recursos y mejora la flexibilidad y precisión del modelo. Esta tecnología se centra en tareas específicas como operaciones matemáticas, programación y razonamiento lógico mediante el aprendizaje de vectores expertos que controlan la importancia de las conexiones de red y combina el aprendizaje por refuerzo para optimizar aún más el rendimiento del modelo.

Los sistemas de inteligencia artificial actuales generalmente necesitan manejar múltiples tareas en una sola capacitación. Sin embargo, son propensos a encontrar desafíos inesperados al enfrentar nuevas tareas, lo que resulta en una adaptabilidad limitada del modelo. El concepto de diseño de Transformer² está dirigido a este problema, utilizando tecnología vectorial experta y de ajuste fino de valor singular (SVF), de modo que el modelo pueda hacer frente de manera flexible a nuevas tareas sin volver a capacitar a toda la red.

Los métodos de entrenamiento tradicionales requieren ajustar los pesos de toda la red neuronal, lo que no sólo es costoso sino que también puede hacer que el modelo "olvide" el conocimiento aprendido previamente. Por el contrario, las técnicas SVF evitan estos problemas al aprender vectores expertos que controlan la importancia de cada conexión de red. Los vectores expertos ayudan al modelo a centrarse en tareas específicas, como operaciones matemáticas, programación y razonamiento lógico, ajustando la matriz de ponderaciones de las conexiones de red.

Este enfoque reduce significativamente la cantidad de parámetros necesarios para adaptar el modelo a nuevas tareas. Por ejemplo, el método LoRA requiere 6,82 millones de parámetros, mientras que SVF solo requiere 160.000 parámetros. Esto no solo reduce el consumo de memoria y potencia de procesamiento, sino que también evita que el modelo olvide otros conocimientos mientras se concentra en una determinada tarea. Lo más importante es que estos vectores expertos pueden trabajar juntos de manera efectiva para mejorar la adaptabilidad del modelo a diversas tareas.

Para mejorar aún más la adaptabilidad, Transformer² introduce el aprendizaje por refuerzo. Durante el proceso de capacitación, el modelo optimiza continuamente los vectores expertos proponiendo soluciones de tareas y obteniendo retroalimentación, mejorando así el desempeño en nuevas tareas. El equipo desarrolló tres estrategias para aprovechar este conocimiento experto: señales adaptativas, clasificadores de tareas y adaptación de pocas oportunidades. En particular, la estrategia adaptativa de pocos disparos mejora aún más la flexibilidad y precisión del modelo al analizar ejemplos de nuevas tareas y ajustar vectores expertos.

Transformer² supera al método tradicional LoRA en múltiples puntos de referencia. En tareas matemáticas, su rendimiento aumentó en un 16% y los parámetros requeridos se redujeron significativamente. Cuando se enfrentó a una nueva tarea, la precisión de Transformer² fue un 4% mayor que la del modelo original, mientras que LoRA no logró los resultados esperados.

Transformer² no solo resuelve problemas matemáticos complejos, sino que también combina capacidades de programación y razonamiento lógico para lograr el intercambio de conocimientos entre dominios. Por ejemplo, el equipo descubrió que los modelos más pequeños también pueden mejorar el rendimiento al aprovechar el conocimiento de modelos más grandes mediante la transferencia de vectores expertos, lo que brinda nuevas posibilidades para compartir conocimientos entre modelos.

Aunque Transformer² ha logrado avances significativos en la adaptabilidad de tareas, todavía enfrenta algunas limitaciones. Actualmente, los vectores expertos entrenados con SVF solo pueden confiar en las capacidades existentes en el modelo previamente entrenado y no pueden agregar habilidades completamente nuevas. El verdadero aprendizaje continuo significa que el modelo puede aprender nuevas habilidades de forma independiente. Aún lleva tiempo lograr este objetivo. Cómo ampliar esta técnica a modelos grandes con más de 70 mil millones de parámetros sigue siendo una cuestión abierta.

Con todo, Transformer² muestra un gran potencial en el campo del aprendizaje continuo, y su utilización eficiente de recursos y una mejora significativa del rendimiento proporcionan una nueva dirección para el desarrollo de futuros modelos de lenguaje. Sin embargo, la tecnología aún necesita mejorarse continuamente para superar las limitaciones existentes y lograr verdaderos objetivos de aprendizaje continuo.