Sakana AI lanza el innovador Transformer² del modelo de lenguaje adaptativo, que utiliza un mecanismo único de ajuste de peso dinámico de dos pasos que aprende y se adapta dinámicamente a nuevas tareas durante el proceso de inferencia sin un ajuste costoso. Esto marca un gran avance en la tecnología del modelo de lenguaje grande (LLM) y se espera que cambie la forma en que se aplica LLM para que sea más eficiente, personalizado y práctico. En comparación con los métodos tradicionales de ajuste fino, Transformer² ajusta selectivamente los componentes clave de los pesos del modelo a través de técnicas de descomposición de valor singular (SVD) y singular valor de ajuste fino (SVF) para optimizar el rendimiento en tiempo real, evitando el recolectión que requiere mucho tiempo. Los resultados de las pruebas muestran que Transformer² es superior al modelo LORA en múltiples tareas, con menos parámetros, y también demuestra fuertes capacidades de transferencia de conocimiento.

La innovación central de Transformer² se encuentra en su único mecanismo de ajuste de peso dinámico de dos pasos de dos pasos. Primero, analiza las solicitudes de usuario entrantes y comprende los requisitos de la tarea; Al ajustar selectivamente los componentes clave de los pesos del modelo, Transformer² permite la optimización en tiempo real del rendimiento sin el reentrenamiento que requiere mucho tiempo. Esto contrasta con el método tradicional de ajuste fino, que requiere mantener los parámetros estáticos después del entrenamiento, o usar métodos como la adaptación de bajo rango (LORA) para modificar solo un pequeño número de parámetros.

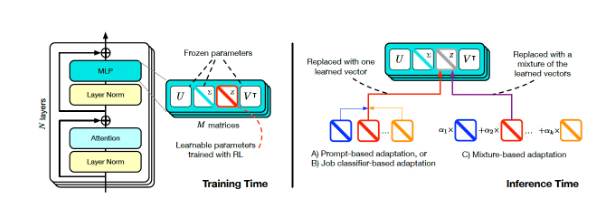

Transformer Square Entrenamiento e inferencia (Fuente: ARXIV)

Para lograr un ajuste dinámico, los investigadores adoptaron el método de ajuste de valor singular (SVF). Durante el entrenamiento, SVF aprende un conjunto de representaciones de habilidades llamadas vectores Z de los componentes SVD del modelo. Al razonar el razonamiento, Transformer² determina las habilidades requeridas analizando las indicaciones y luego configurando los vectores Z correspondientes para lograr una respuesta adaptada a cada mensaje.

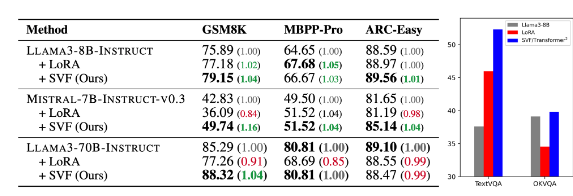

Los resultados de las pruebas muestran que Transformer² es superior al modelo LORA en varias tareas, como las matemáticas, la codificación, el razonamiento y la pregunta y la respuesta visuales, y tiene menos parámetros. Más notable es que el modelo también tiene la capacidad de transferencia de conocimiento, es decir, los vectores Z aprendidos de un modelo pueden aplicarse a otro, lo que demuestra el potencial de una aplicación generalizada.

Comparación de transformador cuadrado (SVF en la tabla) con el modelo subyacente y Lora (fuente: ARXIV)

Sakana AI lanzó el código de entrenamiento para el componente Transformer² en su página de Github, abriendo la puerta a otros investigadores y desarrolladores.

A medida que las empresas continúan explorando la aplicación de LLM, la tecnología de personalización de inferencia se está convirtiendo gradualmente en la tendencia principal. Transformer², junto con otras tecnologías como los titanes de Google, está cambiando la forma en que se utiliza LLM, lo que permite a los usuarios ajustar dinámicamente los modelos a sus necesidades específicas sin reentrenamiento. Este avance tecnológico hará que LLM sea más útil y práctico en una gama más amplia de áreas.

Sakana AI 的研究人员表示,Transformer² 代表了静态人工智能与生命智能之间的桥梁,为高效、个性化和完全集成的人工智能工具奠定了基础。

Transformer² 的开源发布,将极大推动LLM 技术的发展和应用,为构建更加高效、个性化的人工智能系统提供了新的方向。其动态学习和适应新任务的能力,使其在各种领域都具有巨大的应用潜力,值得期待未来的发展。