En el campo de la inteligencia artificial, la evaluación efectiva de modelos de idiomas grandes (LLM) es crucial. Sin embargo, los métodos de evaluación tradicionales a menudo les resulta difícil satisfacer las necesidades prácticas de la aplicación. Para abordar este problema, Hugging Face ha lanzado un paquete de evaluación de IA liviano llamado Lighteval. Lighteval tiene como objetivo ayudar a las empresas e investigadores a evaluar LLM de manera más fácil y efectiva, asegurando la precisión del modelo y la conformidad con los objetivos comerciales. Admite múltiples dispositivos y procesos de evaluación personalizados y se integra a la perfección con otras herramientas faciales de abrazo para proporcionar un proceso completo para el desarrollo de IA.

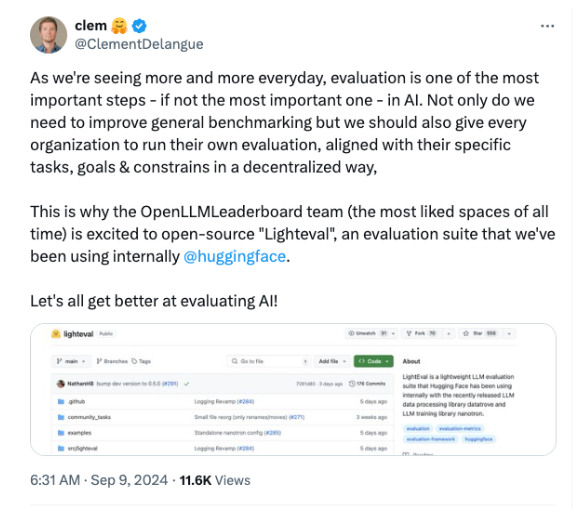

Recientemente, Hugging Face lanzó una nueva herramienta llamada Lighteval, un conjunto de evaluación de IA ligero diseñado para ayudar a las empresas e investigadores a evaluar mejor los modelos de idiomas grandes (LLM).

A medida que las tecnologías de IA se vuelven más importantes en diversas industrias, es particularmente importante evaluar estos modelos de manera efectiva para garantizar su precisión y ajuste a los objetivos comerciales.

En términos generales, la evaluación de los modelos de IA a menudo se subestima. A menudo nos centramos en la creación y el entrenamiento del modelo, pero la forma en que evaluamos el modelo es igualmente crucial. Sin evaluaciones rigurosas y específicas del contexto, los sistemas de IA pueden generar inexactos, sesgados o inconsistentes con los objetivos comerciales.

Por lo tanto, abrazar el CEO de Face, Clément Delangue, enfatizó en las redes sociales que la evaluación no es solo un punto de control final, sino también la base para garantizar que el modelo de IA cumpla con las expectativas.

Hoy en día, la IA ya no se limita a laboratorios de investigación o compañías de tecnología, y muchas industrias, como las finanzas, la atención médica y el comercio minorista, están adoptando activamente la tecnología de IA. Sin embargo, muchas compañías a menudo enfrentan desafíos al evaluar los modelos, porque los puntos de referencia estandarizados a menudo no logran capturar la complejidad en las aplicaciones del mundo real. LightEval nace para resolver este problema, lo que permite a los usuarios realizar evaluaciones personalizadas en función de sus necesidades.

Esta herramienta de evaluación se integra perfectamente con la gama de herramientas existentes de Hugging Face, incluidas Datatrove, Datatrove y Model Training Library, Nanotron, para proporcionar un proceso de desarrollo de IA completo.

LightVal admite la evaluación en una variedad de dispositivos, incluidas CPU, GPU y TPU, para adaptarse a diferentes entornos de hardware y satisfacer las necesidades de la empresa.

El lanzamiento de Lighteval llega en un momento en que la evaluación de IA está atrayendo más y más atención. A medida que aumenta la complejidad del modelo, las técnicas de evaluación tradicionales se vuelven sin escrúpulos. Hacer la estrategia de código abierto de Facing permitirá a las empresas ejecutar sus propias evaluaciones, asegurando que sus modelos cumplan con sus estándares éticos y comerciales antes de que entren en producción.

Además, LightVal es fácil de usar y puede usarse incluso para usuarios con bajas habilidades técnicas. Los usuarios pueden evaluar modelos en una variedad de puntos de referencia populares, o incluso definir sus propias tareas personalizadas. Además, LightEval también permite a los usuarios especificar configuraciones para la evaluación del modelo, como pesos, paralelismo de tuberías, etc., lo que proporciona un fuerte apoyo a las empresas que requieren un proceso de evaluación único.

Entrada del proyecto: https://github.com/huggingface/lighteval

Puntos clave:

Abrazo de la cara lanza Loirval, un conjunto de evaluación de IA liviano diseñado para aumentar la transparencia y la personalización de las evaluaciones.

LightEval se integra sin problemas con las herramientas existentes para admitir la evaluación de múltiples dispositivos para adaptarse a las necesidades de diferentes entornos de hardware.

Esta herramienta de código abierto permite a las empresas evaluarse a sí mismas, asegurando que el modelo cumpla con sus estándares comerciales y éticos.

El código abierto y la facilidad de uso de Lighteval lo convierten en una herramienta poderosa para que las empresas e investigadores evalúen LLM, ayudando a impulsar el desarrollo más seguro y confiable de la tecnología de IA. A través de procesos de evaluación personalizados y soporte de dispositivos múltiples, LightEval satisface las necesidades de evaluación en diferentes escenarios y proporciona garantías sólidas para la implementación de aplicaciones de IA.