El Instituto Allen de Inteligencia Artificial (AI2) lanzó recientemente un nuevo modelo de lenguaje a gran escala Olmoe, un modelo de experto híbrido disperso (MOE) con 7 mil millones de parámetros, pero cada marca de entrada usa solo mil millones de parámetros, lo que reduce significativamente el número de inferencias de inferencias de inferencias costos y requisitos de memoria. Olmoe tiene dos versiones: la versión universal OLMOE-1B-7B y la versión de instrucción ajustada Olmoe-1B-7B-Instructo, que realiza no menos que otros modelos grandes en puntos de referencia, e incluso supera algunos modelos más grandes. AI2 enfatiza el código abierto completo de Olmoe, que es particularmente precioso en el campo de los modelos MOE y proporciona recursos valiosos para la investigación académica.

Olmoe adopta una arquitectura de experto híbrido disperso (MOE) con 7 mil millones de parámetros, pero solo se utilizan 1 mil millones de parámetros por etiqueta de entrada. Viene en dos versiones, el Olmoe-1B-7B más general y el Instructo OLMOE-1B-7B sintonizado con instrucciones.

A diferencia de la mayoría de los otros modelos de expertos híbridos que son de código cerrado, AI2 enfatiza que Olmoe es completamente de código abierto. Mencionaron en el documento que "la mayoría de los modelos MOE son de código cerrado: aunque algunos revelan pesos de modelos, hay información extremadamente limitada sobre sus datos de capacitación, código o recetas".

El científico de investigación de AI2, Nathan Lambert, dijo en las redes sociales que Olmoe ayudará con la formulación de políticas, lo que podría proporcionar un punto de partida para el lanzamiento del clúster H100 en la academia. También mencionó que el lanzamiento del modelo Olmoe es parte del objetivo de AI2 de desarrollar modelos de código abierto y hacer que su rendimiento sea comparable a los modelos cerrados.

En términos de construcción de modelos, AI2 decidió usar 64 pequeños expertos para un enrutamiento fino y activar solo ocho de ellos en tiempo de ejecución. Los experimentos muestran que OLMOE es comparable a otros modelos en el rendimiento, pero se reduce significativamente en el costo de inferencia y el almacenamiento de memoria. Olmoe también se basa en el modelo de código abierto OLMO1.7-7B antes de AI2, admitiendo 4096 ventanas de contexto etiquetadas. Los datos de entrenamiento de Olmoe provienen de múltiples fuentes, incluyendo Crawl Common, Dolma CC, Wikipedia, etc.

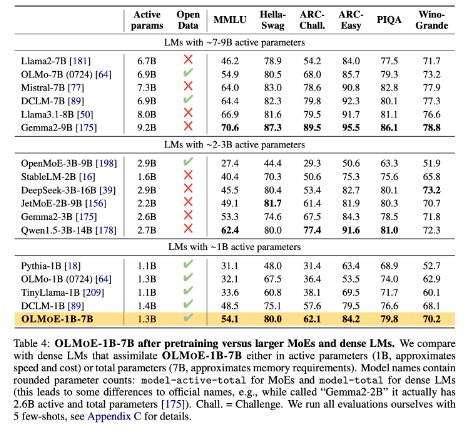

En el punto de referencia, OLMOE-1B-7B supera a muchos modelos existentes en comparación con modelos con parámetros similares, e incluso supera modelos más grandes como LLAMA2-13B-CHAT y Deepseekmoe-16b.

Uno de los objetivos de AI2 es proporcionar a los investigadores modelos de IA de código abierto, incluidas las arquitecturas de expertos híbridos. Aunque muchos desarrolladores usan MOE Architecture, AI2 cree que la mayoría de los otros modelos de IA están lejos de ser lo suficientemente abiertos.

Huggingface: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

Entrada en papel: https://arxiv.org/abs/2409.02060

Puntos clave:

- El nuevo modelo de código abierto Olmoe lanzado por AI2 es competitivo en términos de rendimiento y costo.

- Olmoe adopta una arquitectura experta híbrida escasa que puede reducir efectivamente los costos de inferencia y los requisitos de memoria.

- AI2 se compromete a proporcionar un modelo de IA de código abierto que promueve la investigación y el desarrollo académicos.

En resumen, el lanzamiento de código abierto de OLMOE es un avance importante en el campo de los modelos de idiomas a gran escala. El movimiento de AI2 refleja su firme compromiso con el desarrollo de la IA de código abierto y vale la pena esperar contribuciones más similares en el futuro.